Google DeepMindが「Gemini Robotics 1.5」の最新動画を2025年9月26日に一挙に4本公開し、驚異的な進化が話題になりはじめています(動画のYouTube設定で音声トラックに「日本語」を指定することで、AIによる日本語翻訳で解説を聞くことができる)。

「Gemini Robotics」はヒューマノイドを含むロボット工学向けに設計されたGeminiを基盤としたAIモデルです。

「Gemini Robotics」の最大の特徴は、ロボットを直接制御することを目的に、視覚(Vision)・言語(Language)・行動(Action)を統合したVLA(Vision-Language-Action)モデルを追求し、現実世界で汎用的に動作できる点です。VLAモデルは現在のAIロボティクス分野で最も注目されている最先端技術のひとつです。

「Gemini Robotics 1.5」は、高次元の思考・計画機能を持つ補助モデル「Gemini Robotics-ER 1.5」と連携して設計され、複雑なタスクやマルチステップの実行で、単なる反応的な動作ではなく「先読み」「分割実行」「ツール利用」などが拡張されています。

・Gemini Robotics は、視覚・言語・行動を統合する VLA(Vision-Language-Action)モデル を基盤とし、物理世界でロボットを制御可能にすることを目指している。

・Gemini Robotics 1.5 には補助モデル「Gemini Robotics-ER 1.5」との連携設計があり、複雑・多段階タスクでの振る舞いが強化されている。

・公開された各動画で示された主要な能力:

1.エージェンティック能力(自律判断・計画・ツール利用など)

2.具現体間の知識転移(異なるロボット構造間で学習を活用する能力)

3.実行中の思考と制御(動作中にも判断・調整できる能力)

4.計画/思考+ツール利用 を組み合わせて複雑なタスクを遂行する能力

・こうした進展は、将来のロボットが単なる命令実行型から、より自律・柔軟で汎用的な存在へ進化する可能性を示している。

では、各動画とポイントを見ていきましょう。

・Gemini Robotics 1.5: Enabling robots to plan, think and use tools to solve complex tasks

・Gemini Robotics 1.5: Using agentic capabilities

・Gemini Robotics 1.5: Learning across embodiments

・Gemini Robotics 1.5: Thinking while acting

冒頭の「Gemini Robotics 1.5: Enabling robots to plan, think and use tools to solve complex tasks」は以降の3つの動画を包括的にまとめたものになっています。時間のない人はまずはこれを見るとよいでしよう。じっくり理解したい人のために、この記事では最初の動画をあえてラストに解説します。

■Gemini Robotics 1.5: Using agentic capabilities

この動画は、Gemini Robotics 1.5 が単に反応的に動くロボットではなく、ある種の自律的判断能力を持つ「AIエージェント」として振る舞えることを示しています。

動画では、ロボットが「エージェンティックAI(AIエージェント)の能力、エージェンティック(agentic)能力」を持つことにフォーカスしています。今までは単純に「命令」を受けて「動作」するだけの行動だったものが、エージェンティックAIの進化によって、自律的に判断・計画・行動ができるようになる、という能力です。

エージェンティックAIによって、環境を観察し、目標を分割したり、優先度をつけたり、その場で戦略を変えたりしながら動作を決定する、その一連の様子が見て取れると思います。

もうひとつ重要なポイントとして、エージェンティックAIは必要なツール(例えば Google検索など)を呼び出したり、外部の情報にアクセスすることで、必要な知識をAIロボットが補完しながら行動できる能力も示唆しています。この機能はロボティクスに限らず、ビジネス分野でも、最新のエージェンティックAIが、目的を遂行するために必要なソフトウェアやAPIをAIが自律的に活用する機能として注目されています。

また、動作を実行する際の思考プロセス(行動をステップごとに言語で表現する思考)をAIが生成している可能性もあります。「思考してから動く (think before acting)」能力を垣間見ることができます。

■Gemini Robotics 1.5: Learning across embodiments

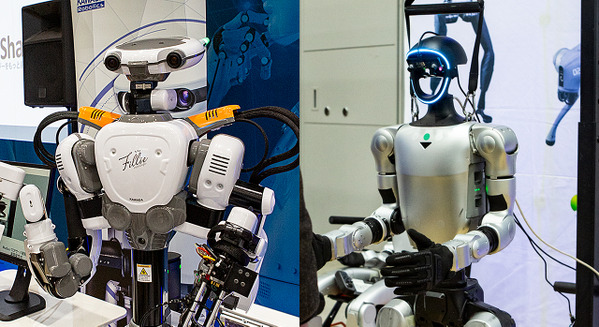

この動画では、ロボットが把持や物体操作、持ち替える動作などの具体的なタスクを、複数のロボット構成であっても同一のモデルがで実行できる様子に着目するとよいでしょう。

この動画の「embodiment(具現体・身体構成)」とは、ロボットの形や関節やセンサー構成などを指す用語として使われています。従来、ひとつのロボットで学習した動作を別の形状のロボットにそのまま適用するのは困難でした。例えばアーム型、双腕型、ヒューマノイドでは、基本構造はもちろん、関節の自由度、動力の特性等が異なるためです。しかし、次世代のロボット基盤モデルでは、その違いをソフトウェアが吸収することを目指して研究が進められています。

この動画では、「Gemini Robotics 1.5」は「ロボットの種類や身体構成が異なっていても、学習した動作やスキルを別のロボット(embodiment)に転移(transfer)できる」能力の成果が示されています。

動画の中で、Google DeepMindは、アーム型ロボットの「ALOHA2」で学習したスキルを、双腕ロボット「Franka」やヒューマノイド「Apollo」にそのまま応用(転移)したデモを披露しています。

こうした能力は、ロボット学習における汎化性能を大きく高めます。従来のようにロボットのメーカーや機種が異なる度にAIの膨大な再学習が必要なくなれば、時間やコストを大幅に削減できる可能性があります。

■Gemini Robotics 1.5: Thinking while acting

「thinking while acting」とは「思考しながら動く」ことで、タスクを実行中にも判断と制御をリアルタイムで更新し、次に行うべき最適な動作を絶えず思考しながら実行できるスキルを指しています。

従来は「ある計画を立てたらその通りに実行する」というのがプログラムにとってはセオリーでしたが、人はタスクの途中に障害物が現れたり、物の位置が変わったり、他の人が介入するなど、予期しない環境変化を認識したとき、臨機応変に対応しようとします。身体性を持ったAIロボットにも同様に「thinking while acting」が重要です。

具体的には、タスク遂行中にも「思考ステップ:中間推論(intermediate reasoning)」を生成・更新しながら、次の動きを決定する様子を動画で確認することができます。

Google DeepMindのブログによれば、「思考 (thinking) を経てから動く (think before acting)」というスキルをさらに発展させた形として「思考しながら動き続ける」能力が重要視されています。

この動画では、途中で目標物が動いたり、障害物が現れたり、環境変化が起こっても、ロボットが思考を止めることなく、連続的に最適なタスクを再演算・更新しながら動作を修正しています。

■Gemini Robotics 1.5: Enabling robots to plan, think and use tools to solve complex tasks

この動画は「複雑なタスク」を解くために、ロボットが「計画 (planning)」「思考 (thinking)」「ツール使用 (tool use)」まで組み合わせて行動するなど、総合的な作業を達成できる様子を紹介したものです。以降の3つ動画が詳細に解説していることを包括的にまとめたものでもあります。

他の3つ動画で示されているように、ロボットが単純な命令に応えるだけではなく、タスクのゴールまでのプロセスを分解して段階的なステップを生成し、そのステップにもとづいて行動し、必要に応じて外部ツール(検索、データベース参照、情報取得など)を活用して補助を行う能力を達成する可能性が示されています。

例えば、「洗濯物を色別に仕分けする」「ある地域(サンフランシスコなど)のゴミ分別ルールを調べて適切に分類する」など、作業のタスクが複数の段階にわたっていても、AIロボットが自律的に考えて実行していく可能性を示唆しています。

また、AIロボットが「リーズニング」を生成し、それをもとに行動を段階的に実行していく手法として「思考してから動く (thinking before acting)」ことも示されています。

例えば「AIロボットが実世界で何をすればいいか判断するために、ウェブ検索をかけてその地域のゴミの分別ルールを参照」することで、より詳細な情報を取得して行動の精度を上げたり、改善するため活用するといったタスクに発展できる可能性があります。

ビジネス分野でも「AIエージェント」は単にユーザーの質問に回答するツールとしてだけでなく、「思考」「計画」「実行プロセス立案」「選択」「ツール呼び出し」「実行」「成果と評価」といった一連の流れを自律的に行うことが期待されています。身体を持ったロボットにも自身が自律的に構成して制御できるスキルが求められていることを示した内容になっています。