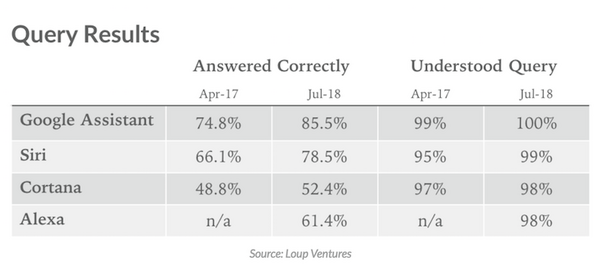

2018年7月25日、Loup Venturesが発表したAI音声アシスタントの評価テスト結果のレポートを紹介する。

原文ではIQテストとなっているが、実際には質問への回答テスト。Apple Siri、Google Assistant、Amazon Alexa、Microsoft Cortanaに対して、約800の質問を行い、その結果を2017年4月と2018年7月と比較したものだ。

今回は「質問を理解できたか?」「正しく返答できたか?」の2つの指標で評価。また質問は以下5つのカテゴリで行われた。

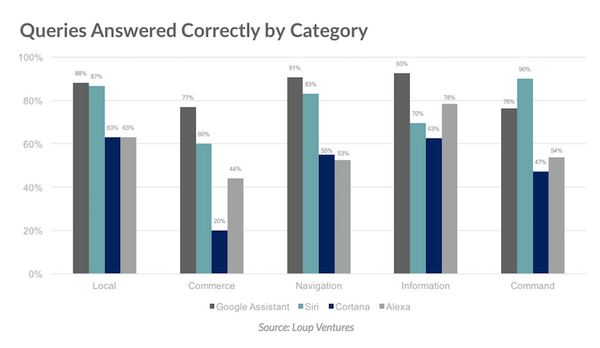

・ローカル – 最も近いコーヒーショップはどこ?

・コマース – ペーパータオルを注文して

・ナビゲーション – バスでアップタウンへ行く方法は?

・インフォメーション – 今夜は誰がツインズをプレイする?

・コマンド – 今日の午後2時にスティーブに電話するのをリマインドして

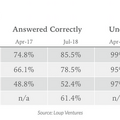

正解率

正しく返答できた率は2017年4月、2018年7月ともにGoogle Assistantがトップ。次いでApple Siri、Amazon Alexa、Microsoft Cortanaと続いた。

質問の理解力についてはGoogle Assistantが100%とトップだが、他社も98~99%と高いレベルにある。

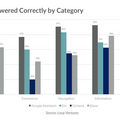

カテゴリ別の正解率

Google Assistantは、コマンドを除くすべてのカテゴリで優秀だった。コマンドのみApple Siriがトップ。コマースでAmazon Alexaがトップではないというのも意外だ。

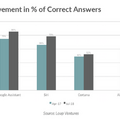

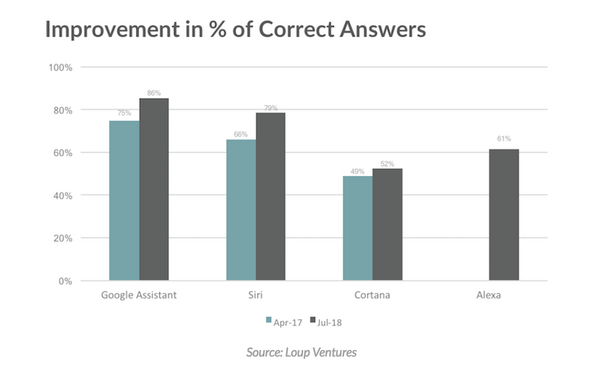

正解率の改善

15か月間でGoogle Assistantの正解率は11%改善、Siriは13%、Cortanaは3%だった。Alexaはアプリでの過去評価データがないので集計外。各社正解率は上がっており、日々性能が向上していることが示された。

なお、本調査はあくまで英語版の調査であり、日本語版では別の結果になる可能性もあるだろう。

ロボスタ / Amazon Echo