スマートフォンで4人のメンバーが入室したチャットルーム。

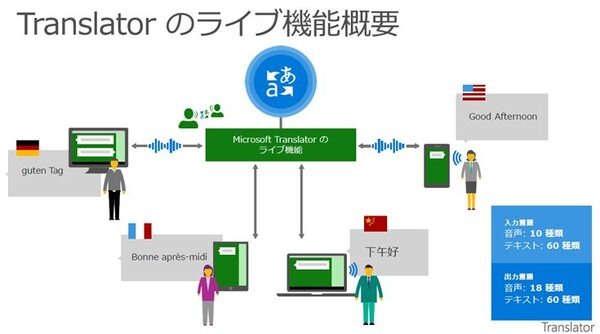

4人のメンバーはそれぞれ別の言語を使う。英語やドイツ語、中国語、彼はフランス語だ。しかし、彼のスマートフォンの画面では、みんなそれぞれの言語で話しているにも関わらず、会話はフランス語のテキストで表示され音声も流れる。それぞれ画面でそれぞれの自国語で会話が進む。

これは、ほかの3人の会話をシステムがリアルタイムで翻訳して発話しているから。

マイクロソフトは4月7日、AI技術(ニューラルネットワーク/ディープラーニング)を活用した新バージョンの「Microsoft Translator」を発表した。この技術はリアルタイム翻訳を実現する技術となる。

記者発表会で展示されたスカイプでは、日本語を使う人と英語を使う人が会話をしている。日本語を使う人が話すのは日本語、イヤホンに聞こえてくる相手の話も音声合成の日本語で聞こえてくる。

「確かに今、多くの企業が翻訳技術にニューラルネットワークを活用し始めていて、競争になっています。ニューラルネットワークの技術を持たない翻訳システムは撤退することになるでしょう。それほどニューラルネットワークによる機械翻訳は精度が高いのです」

これは、報道関係者からの質問に答えて、来日中の米マイクロソフトのAI & Researchグループリーダーのオリヴィエ・フォンタナ氏が語った言葉だ。

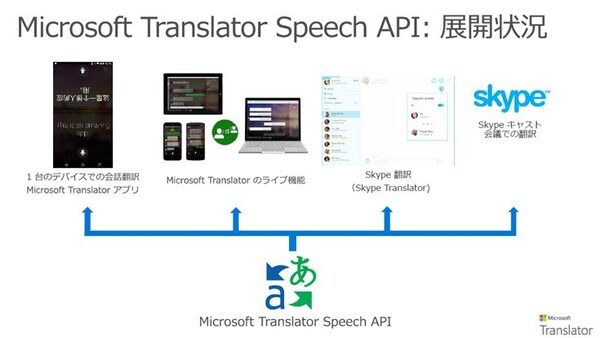

リアルタイム翻訳を実現する「Microsoft Translator Speech API」

リアルタイム翻訳の提供方法のひとつが、Microsoftのクラウドプラットフォーム「Azure」のAPI(Cognitive Services API)、「Microsoft Translator Speech API」としてサービス提供される形態だ。

また、更にそれを組み込んだ「Microsoft Translator ライブ機能」のリリースも発表した。

また、今後は同社のほぼすべての製品へこの翻訳技術を導入していく予定だ。

具体的にどのようなものに組み込まれる予定なのかを次に見ていこう。

今後はMicrosoft Translatorの技術を同社のほぼすべての製品へ導入していく予定だ。

その第一弾として3つの製品への導入を発表した。

■Microsoft Translator

「Microsoft Translator」アプリ(Windows、Android、iOS版)、Microsoft Translatorライブ機能。例えば、iPhone用「Microsoft Translator」アプリが本日以降、AI対応版にアップデートされ、高精度なリアルタイム翻訳版へと変わる。

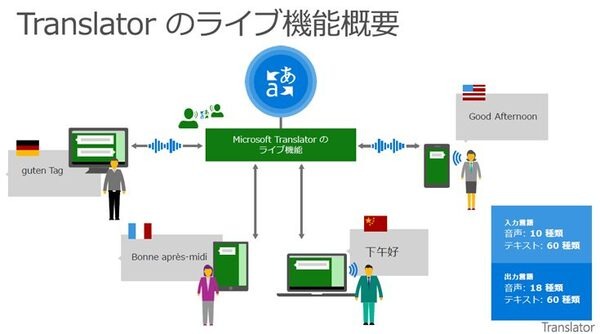

音声でもテキストでもリアルタイム翻訳できて、スマートフォン、パソコン、タブレットなど好きなデバイスで利用できる。発話での会話なら10言語、テキストでの対話チャットなら60の言語に対応。

Microsoft Translator ライブ機能のご紹介(動画)

■スカイプ翻訳

「Skype for Windows」と「Skype Preview for Windows 10」のSkype翻訳で新版が活用される。この機能を使うと、英語と日本語など他言語を使うユーザーがスカイプを通じて共通の言語でコミュニケーションをとることができる。

■パワーポイントでリアルタイム翻訳

「Microsoft Translator PowerPoint アドイン」 (プレビュー版) をリリース。

PowerPointから Translator のライブ機能を直接使用することで、リアルタイムでプレゼンテーションに字幕を付けることができる。

■その他

その他、今後は下記のプロダクトやサービスへの反映が予定されている。

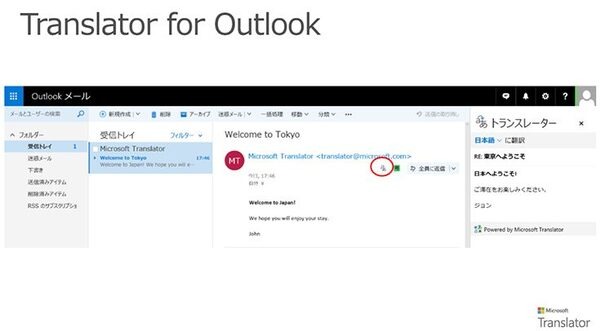

・Outlook アドイン

AIのパワーを電子メールの翻訳に活用。翻訳ボタン(アイコン)が追加される。

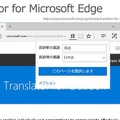

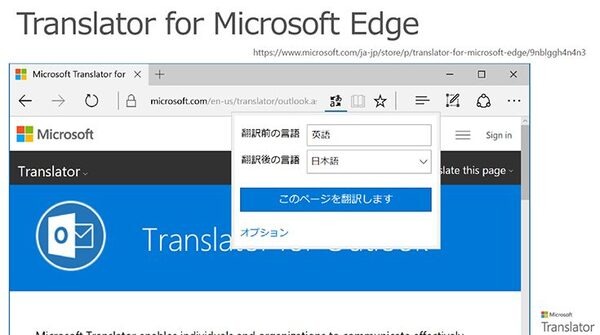

・Microsoft Edge のアドイン

他国語のウェブサイトもユーザーが使う言語でチェック。翻訳ボタン(アイコン)が追加される。

・その他の翻訳

短い文章ならWebサイトの翻訳サービス(www.bing.com/translator)で翻訳したり、単語の意味を調べたり。文章をPCやスマホなど、各種デバイス向けのMicrosoft Translatorで翻訳できる。

Microsoft Translatorのライブ機能

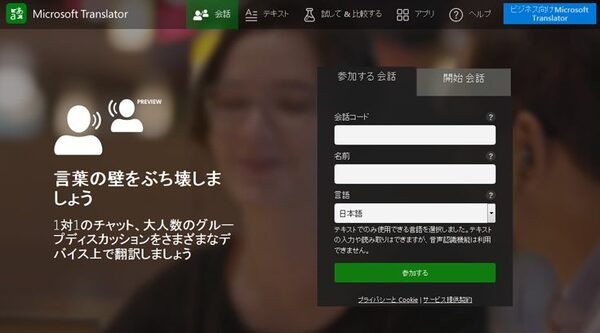

Microsoft Translatorのライブ機能とは、ウェブサイト「Microsoft Translator」上で会話コードを知っている者達が集い、別々の言語でチャットのコミュニケーションをはかることができるもの。

Microsoft Translatorのライブ機能がすべての言語を瞬時に翻訳して全員に伝達する。テキストでは60言語に対応するが、音声の場合は入力言語が10種類に限られる。(下図参照:冒頭の画像と同じ:クリックして拡大)

Microsoft Translator ライブ機能の使い方

下記のウェブサイトでサービス提供されている。

https://translator.microsoft.com/

パソコン、スマートフォン、タブレットなど、多くのデバイスで利用できる。

https://translator.microsoft.com/apps/

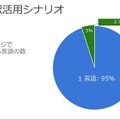

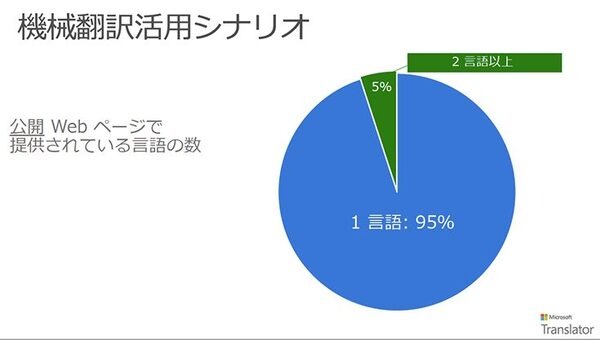

95%のウェブサイトが一言語だけで書かれていて、ビジネス機会を損失している

4月7日のリリースに先だち、同社は報道関係者向けにプレスブリーフィングを実施し、今回の技術の解説と今後の展望などを語った。

プレスブリーフィングでは、まず日本マイクロソフト株式会社のCTO、榊原彰氏のプレゼンテーションが行われた。

「Microsoft Translatorは、リアルタイムで音声翻訳やテキスト翻訳ができるAPIのサービスです。開発者はプログラムにAPIを組み込むことで、すぐに翻訳機能を使うことができます。ベースはテキスト翻訳で、ある言語のテキストから別の言語のテキストへの翻訳は60以上の言語に対応しています。音声翻訳の場合は、音声認識を行ってテキストに変換、それを文章に成形してテキスト翻訳にかける、という手順です。音声翻訳は認識の関係でテキスト翻訳よりは対応言語の数は少なくなります。

AzureのAPIサービスのひとつとして従量課金で提供します。そのためデベロッパーの方は大きな初期投資することなく、気軽に開発を始めることができます」

APIでは開発者に対しての課金プランであり、現状でユーザーは費用の心配する必要はないと言う。

Microsoft Translator、スカイプ、PowerPointのアドインなどは当面、無償で使用することが可能だ。

「今日も同時通訳の方に来て頂いていますが、Microsoft Translatorは通訳の仕事を置き換えるためにリリースするのではありません。残念ながら機械には情緒豊かな翻訳や状況に応じた通訳はできず、まだまだ人間には叶いません。

一方で機械翻訳の利点として翻訳スピードが速い、ということです。次々に情報がアップデートされるような場面で、スピーディな翻訳を手軽に低コストで行いたいというケースでは機械翻訳は有効です」

「世界中で公開されているウェブサイトを見ると、一ヶ国語だけで書かれているサイトが95%を占めています。社内用のウェブページに至っては更に97%が1言語だけで書かれています」

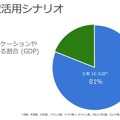

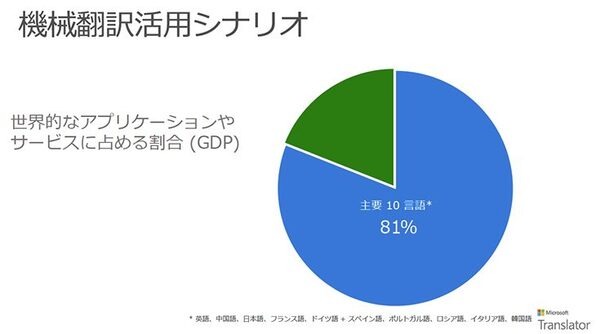

「GDPで見ますと英語圏は全体の32%に過ぎません。対象を英語、中国語、日本語、フランス語、ドイツ語に増やすと64%に増えます。更に主要10言語に増やすと、81%が網羅できます。すなわち、ウェブサイトを1言語でしか用意していないのは、膨大なビジネスのチャンスを逸しているとも言えます。

マイクロソフトはこのMicrosoft Translatorの機能をあらゆるプロダクトに搭載していきたいと考えています。Visual Studio、スカイプ、Officeツールなど全てです」

機械学習で「文脈を読む」力を付けた翻訳

米Microsoft CorporationのMicrosoft ResearchのAI & Research グループリーダーのオリヴィエ・フォンタナ氏が登壇し、技術的なしくみから、マーケティング等を解説した。

「従来は統計的手法による機械翻訳が行われてきました。人間が翻訳した膨大なデータを見て、単語の並び順などをマッチングして翻訳する手法です。しかし、それには限界があります。特に長い文章の全体の関係を処理するはできませんでした。

そこでニューラルネットワークによる翻訳に移行することに決めました。これは統計的手法とは大きく異なります。

まず各単語を見て、次に全体の文章を見て文脈をつかみます。例えば「犬」という単語を見たあと、「仔犬の世話をしている」という文脈であれば、この犬はメスであることが解ります」

このように2~7つの単語で文脈を構成する統計的機械翻訳と比較して、ニューラルネットワークの機械翻訳は文脈全体を見て適した翻訳をおこなう点で、今までより精度の高い翻訳が実現するとしている。

「他言語の翻訳によるコミュニケーションだけでなく、聴覚障害のある方には音声をテキストに変換することで、コミュニケーションのグループに参加することができるようになります」

音声翻訳の仕組み

マイクロソフトは、2014年12月にスカイプ翻訳(Skype Translator)を提供開始し、2015年にMicrosoft Translator APIとアプリを提供開始した。あらゆる言語に存在する固有の特性に合わせて、同社のAIと自然言語処理の専門家チームは個別に対応する必要があったと言う。

音声翻訳は、マイクロソフトの独自技術「TrueText」によって音声認識用と機械翻訳用の異なる2タイプのAIを組み合わせることで実現される。

TrueTextは認識した音声を機械翻訳で翻訳可能な形に成形する。音声はまずマイクロソフトの音声認識ニューラルネットワークシステムへと送られる。このシステムは人間の自然な対話を扱えるよう設計されている。この最初のステップでは、自然言語の専門家が「ディスフルエンシ(disfluencies)」と呼ぶものを含んだテキストが生成される。ディスフルエンシとは、私たちが話すとき、多くは無意識のうちに繰り返し発生しているつなぎ言葉であり、日本語では「えーと」、英語では「um」などが知られている。ノイズと呼ぶ場合もある。

TrueText は、このようなディスフルエンシを削除し、完全な文章に必要な大文字化や、句読点の追加を行ない、翻訳段階でより精度の高い処理を可能にする。

次に、TrueText の出力が機械学習による第二段階のAI機能に送られ、文章の文脈を利用して、流暢で人間らしく聞こえる翻訳が行なわれると言う。

そして、最後のステップはテキスト読み上げ機能。翻訳したテキストを音声に変換して出力することでユーザーは耳で翻訳された文章を聴くことができる。

この一連の流れは下記のようにアニメーションで公開されている。

なお、利用料金については同社の「Cognitive Services の価格 – Translator Speech API」を参照のこと。

いよいよ夢の音声リアルタイム翻訳がいろいろなシステムに組み込まれるときがやってくる…そう期待したい。