中国のロボットスタートアップ AgileX Roboticsは、スタンフォード大学のTony Z. Zhao氏らによるオープンソースのロボットシステム「Mobile ALOHA(モバイル アロハ)」を利用して、モバイルベースと双腕マニピュレータの同時遠隔操作を行う「COBOT MAGIC」を発売した。リーダー・フォロワー(マスター・スレーブ)による遠隔操作で双腕モバイルマニピュレーター型のロボットに動作を学習させるためのデータを収集するために用いる。

2024年5月13日(月)~5月17日(金)に開催されたロボティクスとオートメーションのIEEE国際会議「ICRA 2024」で公開された。

*動画

日本国内では販売代理店のTechShareから発売される。価格は「現在調整中」だが、数百万円程度になる見込み。5月22日には、東陽町にあるTechShare社のロボットショールームにて説明会・体験会が開かれた。レポートする。

■ AgileX「COBOT MAGIC」

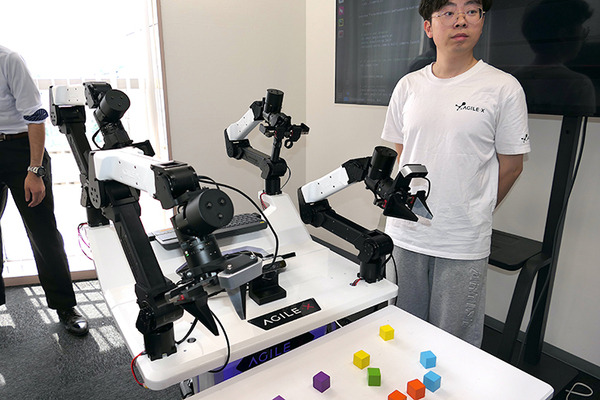

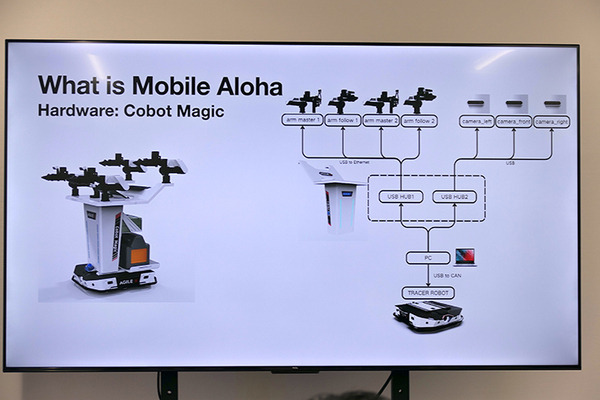

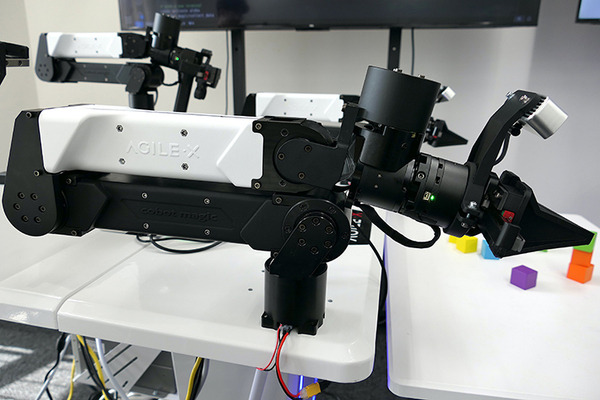

AgileX Roboticは、2016年に中国の東莞で設立された移動ロボットシャーシーの開発メーカー。「COBOT MAGIC」のハードウェアは移動台車、4本の6軸ロボットアーム、2本の手先それぞれと台車の中心に配置された3つのRGB+デプスカメラ、そしてコンピュータという構成のロボットだ。操作者は後ろの2本のアームを使い、二人羽織のようにロボットを直接動かして、モノをつかんだりする動作パターンを学習させる。

リーダーとフォロワーはEthernetで200Hzで通信をしている。学習に用いられるのは基本的にはロボットの関節角度とRGBデータのみ。それを使って50回くらい実際に動作させてデータを収集させたあと、3000回程度の学習を行うことで、およそ8割から9割くらいの確率で動作が成功できるようになる。AIモデルの学習に必要な時間はGPUの性能に依存する。

移動台車部分にはAgileXの二輪差動輪型UGV「TRACER」が、そのまま使われている。「TRACER」のペイロードは100kgで、ROSとROS2による開発に対応する。そのエンコーダーのデータも学習に用いられる。

■双腕遠隔操作のデータを安価・簡易に収集できる「ALOHA」

「Mobile ALOHA」は、先に発表された「ALOHA」をモバイル、移動可能に拡張したシステムである。「ALOHA」とは「A Low-cost Open-source Hardware System for Bimanual Teleoperation」の略だ。

TechShare技術部の松村優氏がまず、技術的な概要を紹介した。従来はロボットに機械学習で動作を覚えさせるためには高性能かつ高コストなセンサー・ハードウェアが必要であり、双腕協調のためのキャリブレーション作業コストも高く、教示データの収集のコストも高かった。

また、アクションの誤差が、その後のアクションへと伝搬していく「Compound error」によってロバスト性が低下するという問題もあった。

そこに登場した「ALOHA」は、模倣学習モデルを使い、フォースフィードバックがない低コストなハードウェアで微細作業を実現したという研究だった。システムはカメラからのRGB情報と関節角度を入力とし、一連の関節角シーケンスを出力してロボットを動作させる。

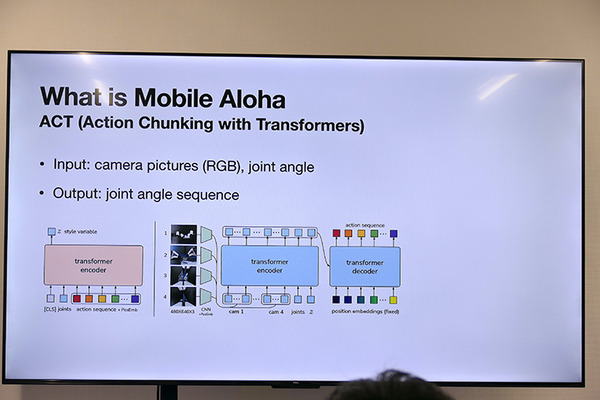

ポイントは「ACT(Action Chunking with Transformers)」というアーキテクチャー。Transformersアーキテクチャを活用して、アクションを一つのチャンク(まとまり)とし、次の数ステップをまとめて予測することで、「Compound error」の問題を回避した。end-to-endで学習するためキャリブレーションの必要もない。

■「ALOHA」をモバイルへと拡張した「Mobile ALOHA」

*動画

「ALOHA」に台車をつけて双腕モバイルマニピュレータへと拡張したのが2024年1月にプレプリントが公開された「Mobile ALOHA」だ。前述の「ACT」と、「ALOHA」で収集したデータセットを使ったCo-trainingにより、50回程度の試行と、32,000ドル程度と低コストなハードウェアで高い性能を発揮した。

デモ動画では学習済みのロボットが調理やベッドメイキングなどを実行しており、ネット上でも広く話題になった。

*動画

従来は高性能・高コストなハードウェアが必要だったのに対し、リーダー側の台車をゴロゴロ押しながら教示することで簡易に教示データを収集し、Co-trainingにより必要なデータ収集のサンプリング効率を向上させた。

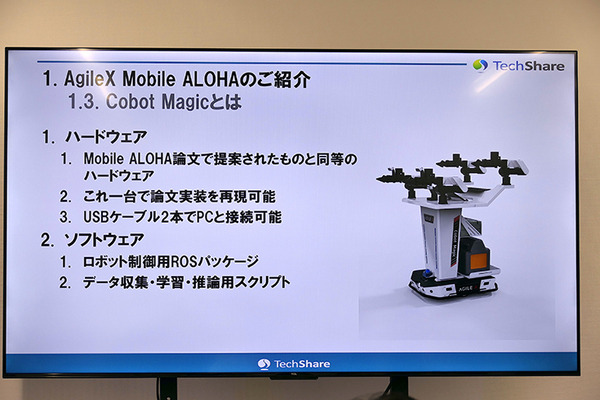

「Mobile ALOHA」はオープンソースとして公開されている。「COBOT MAGIC」は論文で提案されたハードウェア同等品を製品化したものだ。TechShareの松村氏は「これ一台で論文実装を再現できる。配線なども全てまとめられており、簡単に扱うことができる」と紹介した。

ROSパッケージやデータ収集・学習・推論用スクリプトなどソフトウェア一式も同梱されている。

■実際の学習時間とタスク成功率は?

*動画

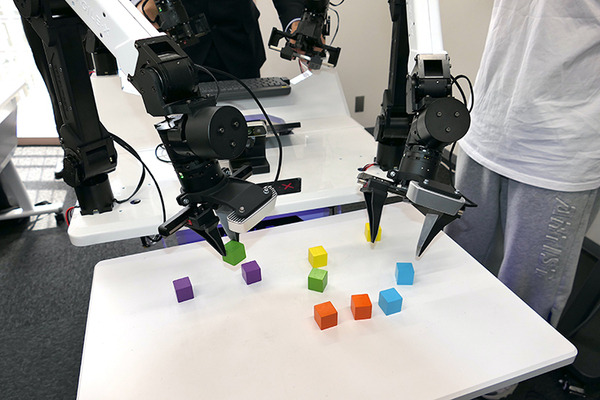

続いて、AgileX担当者による紹介と実機デモセッションも行われた。「Mobile ALOHA」を使った実験はデータ収集、トレーニング、推論実行という3段階で進む。

操作自体は簡単で、基本的にロボットを操って試行を繰り返し、データを使って学習させるだけだ。単純な「テーブルに置かれた静的な箱を掴む」といったようなタスクなら、ほぼ100%成功できるようになるという。

*動画

実際のところどのくらいの学習時間がかかるのかについては、前述のとおり、どんなGPUを使うか次第に大きく影響される。たとえばNVIDIA RTX A6000を使うと、3000回くらい、8時間の時間がかかるという。それでおおよそ8割程度の成功率だとのことだった。

ただし、精度は元々の学習データの質にも影響される。また、「Mobile ALOHA」の場合も、事前に「ALOHA」のみを使ってデータ収集することでサンプリング効率を上げることができるという。まだまだ研究が進められると色々な方法が出てきそうだ。

*動画

筆者も実際に操作させてもらった。アーム自体はまったく遅延なく動く。また、目の前のものを扱うので奥行き情報なども問題ないはずなのだが、手先にまったくフィードバックがないので、操作は意外と難しい。これで料理を行なった研究者たちはすごいと思ってしまった。

■国内のロボット研究者たちの活用を期待

AgileX社だけでなく、Unitree社やDOBOT社も、似たような製品を出そうとする動きがあるという。非常に注目されていることは間違いない。

「COBOT MAGIC」実機は、しばらくは東陽町にあるTechShare社のロボットショールームにて触ることができるとのこと。興味がある方はTechShareにコンタクトして欲しい。なお同社ショールームでは他にも移動台車やアームロボット、ヒューマノイド「H1」などを見ることもできる。

なお、「COBOT MAGIC」の手先カメラはRGB+デプス(Orbbec製)だが、現状ではデプス情報は使われていない。奥行き情報も使うようになれば、さらに成功率は上がるかもしれない。

また、既存の古典的な位置合わせ手法と組み合わせたり、手先を単なるグリッパーではない、より複雑なハンドに変更するといったことも、研究面でも実装を早める意味でも面白そうだ。

さらに今後は、筆者の妄想だがロボットのための「大規模動作モデル」のようなものも登場して、少しファインチューンするだけで色々な動作ができるようになるかもしれない。多くのロボット研究者に活用されることを期待したい。

ロボットの見方 森山和道コラム