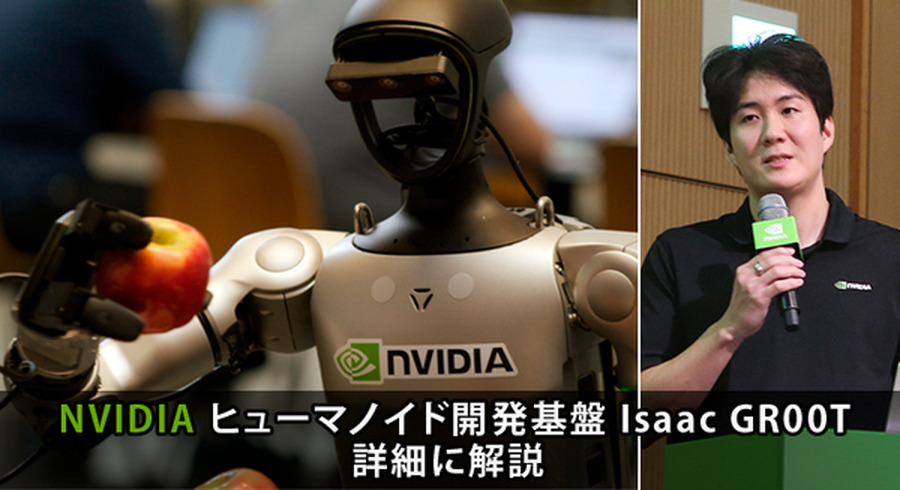

NVIDIAが2025年9月25日に東京ミッドタウンで開催したイベント「NVIDIA AI Day Tokyo」から、ソリューションアーキテクト 加瀬敬唯氏によるセッション「フィジカルAIで加速するヒューマノイドロボティクス NVIDIA Isaac GR00TとCosmosの紹介」をレポートする第三回。

今回はいよいよ、ヒューマノイド開発基盤プロジェクト「Isaac GR00T」(ジーアールゼロゼロティー、通称アイザック・グルート)のセッションについて、どこよりも詳しく、やさしく解説したいと思う。

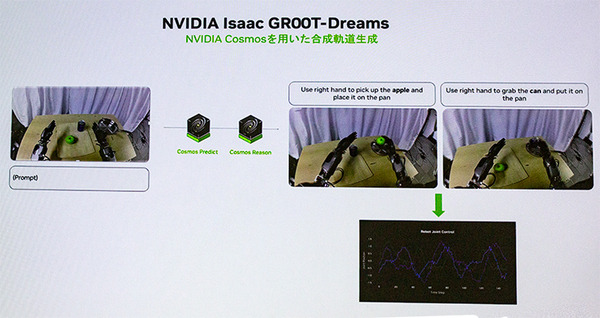

加瀬氏はセッションの終盤で、ヒューマノイド開発プロジェクト「Isaac GR00T」について解説、「GR00T Teleop(テレオペ)」「GR00T Mimic(ミミック)」「GR00T Gen(ジェン)」によるパイプラインと、更にそれらを拡張して、ロボットの汎化性能を向上させ「GR00T Dreams(ドリームス)」について紹介した。

ヒューマノイドが注目されている理由:「GR00T」と「VLAモデル」

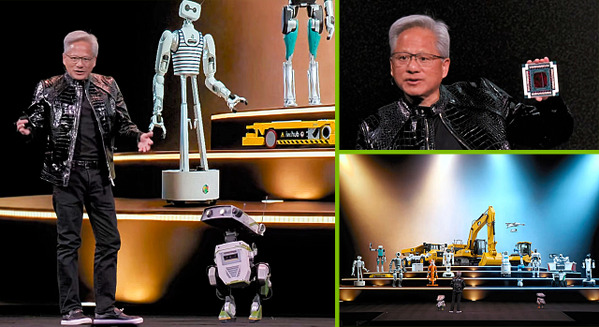

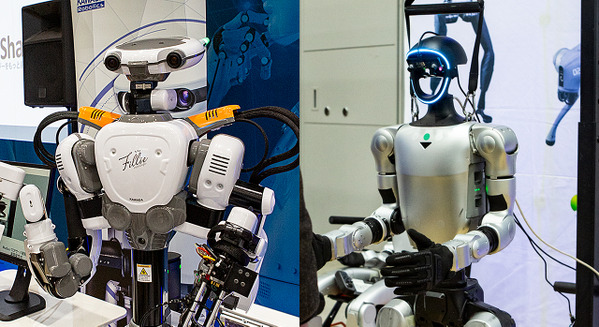

現在、ICT業界全体でヒューマノイドが注目されている。その理由のひとつはNVIDIAが「GR00T」の開発を加速している点にある。本格的なヒューマノイドロボットは1973年、世界に先がけて早稲田大学が開発、ホンダのASIMOなど、日本が技術的にリードした時期もあった。しかし、産業には繋げることができなかった。

AIが飛躍的に進歩した今、AIの身体性の体現としてヒューマノイドの実用化が期待されている。それにはNVIDIAやGoogleがシム2リアル(シミュレーションtoリアル)や、VLAモデル(Vision-Language-Action Model)を進化させ、それぞれ世界モデルを実装して、誰もがロボットを開発しやすい環境として「ロボット基盤モデル」を準備しているためだ。

NVIDIAはこれまでも、自社のGPUを中核として実践的なAIの開発環境を提供してきた。そのNVIDIAが次に来るのは「AIロボット」「ヒューマノイド」と公言しているので、注目されるのも当然の流れだろう。

ヒューマノイドに必要な機能と周波数

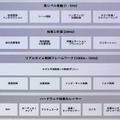

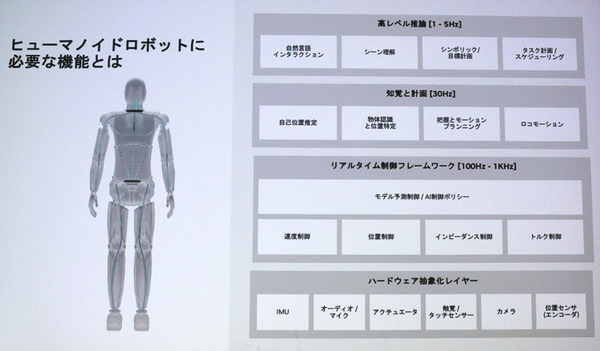

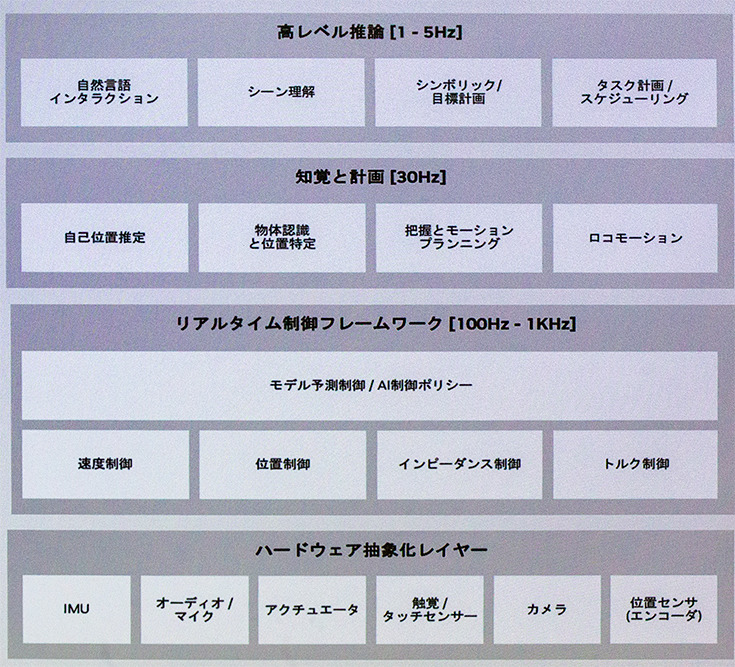

加瀬氏の解説は「ヒューマノイドに必要な機能とは」という説明から入った。人が行動するのに普段から自然に行っている行動を分解し、レイアー的に表示したのが次の表だ。

高レベル推論(1~5Hz)、知覚と計画(30Hz)、リアルタイム制御フレームワーク(100Hz~1KHz)、そしてハードウェア抽象化レイヤーに分けている。それぞれのレイヤーがどのくらいの周期(頻度)で更新・処理される必要があるかを示すのを「Hz」で示している。

ロボティクスでは、行動制御や認知処理は「ループ(周期的処理)」で実行され、高レベル推論は1秒に1~5回程度で情報を更新(実行)、カメラやセンサーからの入力処理(知覚と計画)は人間の「目のフレームレート」に近い30Hzくらいの周期、関節やバランス制御(リアルタイム制御)は人間の神経反射のように高速に行われ、アクチュエーター(モーター)の制御はミリ秒単位で扱うことになる。

すなわちこの表で上の思考は「じっくり考えて」「ゆっくり計画して」、下の制御は「超高速で回さないと体が動かない」ことを示し、それぞれ開発のレイヤーも異なることを表している。

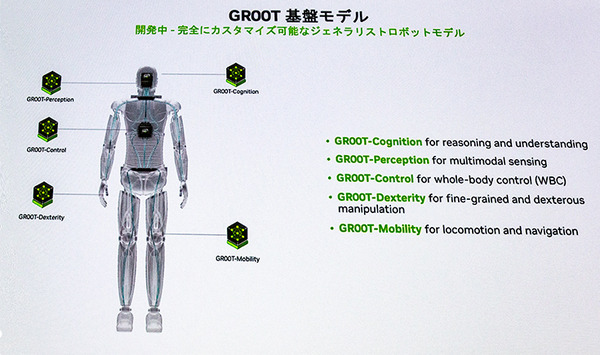

加瀬氏は「NVIDIAでは、これらをGR00Tの「Cognition」「Perception」「Control」「Dexterity」「Mobility」に分けて研究開発し、開発者の皆さんが使いやすいように提供しようと考えている」と説明した。

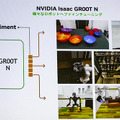

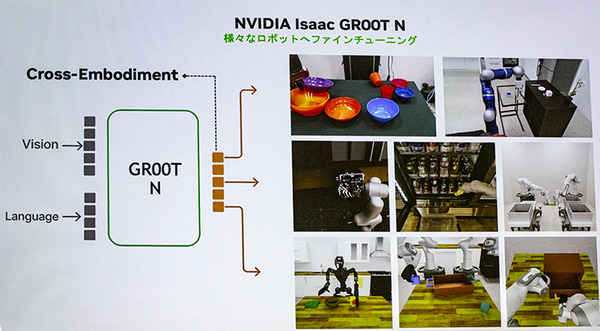

ヒューマノイド用VLA基盤モデル「GR00T N」

NVIDIAは2025年に入って、GR00Tプロジェクトとしてヒューマノイド用VLA基盤モデル「Isaac GR00T N」を発表した。「GR00T N」(セッションの時点で最新はバージョン1.5)では、システム2では低周期でVLM(Vision Language Model)を回し、システム1では高周期の Hzの観点でも分けて構成されている。

加瀬氏は「この構成はヒューマノイドに限らず、アーム型や双腕型など様々なタイプのロボットにも適用可能」として、ロボットのファインチューニングと汎用性について触れた。ただ、現状の「GR00T N」では上半身、特に双腕の制御に特化し、オープンソースとして提供していて、下半身の制御やブラッシュアップは今後の開発予定となっている。

Teleop – Mimic – Gen で膨大な学習データを生成

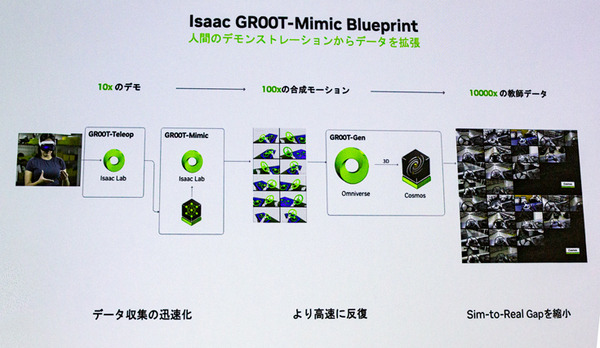

「GR00T N」での開発においても、膨大なロボット向け学習データが必要になる。それを支援するのが「GR00T Mimic」。人が遠隔操作で実施した行動データをもとに拡張し、学習データをデジタル上で増やすしくみだ。

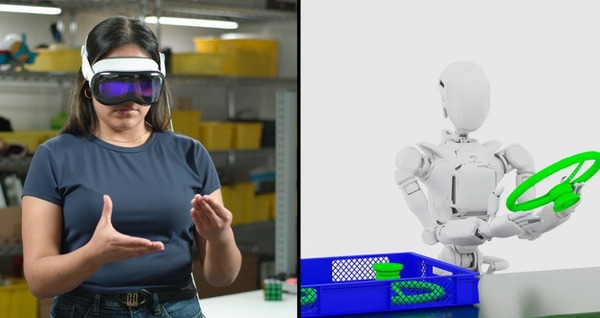

「GR00T Teleop(テレオペ)」で遠隔操作した軌跡情報等を抽出してロボットにマッピングし、「Isaacラボ」環境で動かしてデータを収集する。

「GR00T Mimic(ミミック)」はテレオペで得た少量のデモデータからバリエーションを持たせた大量の動作データを生成(学習用データをスケール)、さらにシーンや環境・物体配置のパターンを増やすため(ドメインランダム化)「GR00T Gen」で環境・オブジェクト・背景・テクスチャなど、多様なパターンを組み合わせて学習することで行動に汎用性を持たせ、シミュレーションと実世界とのギャップを低減する。

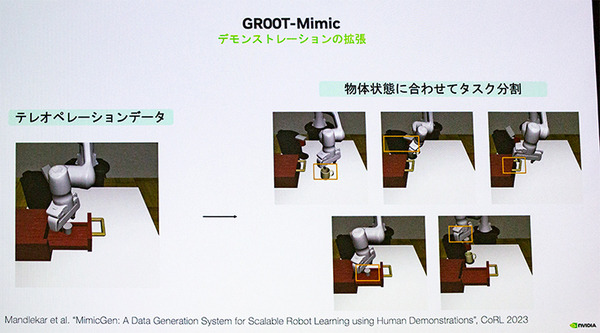

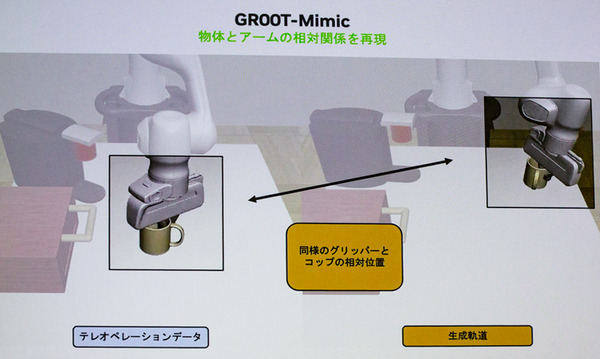

加瀬氏は「GR00T Mimic」の詳細説明として、珈琲メーカーにコップをセットする動作を例に、物体の状態に合わせてタスクを分割し、ランダムに別の場所に珈琲カップを移動したものを生成し、マグカップとグリッパー(アーム)の相対値を抽出し、それに合わせて軌道を生成する「物体とアームの相対関係を再現」のしくみを解説した。

更に「GR00T Mimic」で生成したデータを多様化(汎用化)するために、背景、物体、照明、配置などの環境データを「GR00T Gen」で生成して、さまざまな状況に適用させる。これが「GR00Tにおけるデータ生成パイプライン(ワークフロー)」だ。

「GR00T Teleop」で遠隔操作で軌跡等データ取得

人間がロボット操作を行い、その動きを記録する。

「GR00T Mimic」で学習用データ生成・拡張

得られたデモのデータをもとに、異なるパラメータ変換や補間、ノイズ付加などを行って多様な運動パターンを合成する。

「GR00T Gen」で環境の多様化(汎用化)

環境(背景、物体、照明、配置など)を多様に変化させて、生成された動作データをさまざまな状況に適用できるようにする。

膨大な学習データを想像的に生成して汎用性を強化する「Dreams」

加瀬氏は最後に「GR00T Dreams」に触れた。「GR00T Dreams」は、前述の既存のデモデータから生成した汎用性・拡張性のある合成軌道データを更に発展させるもの。

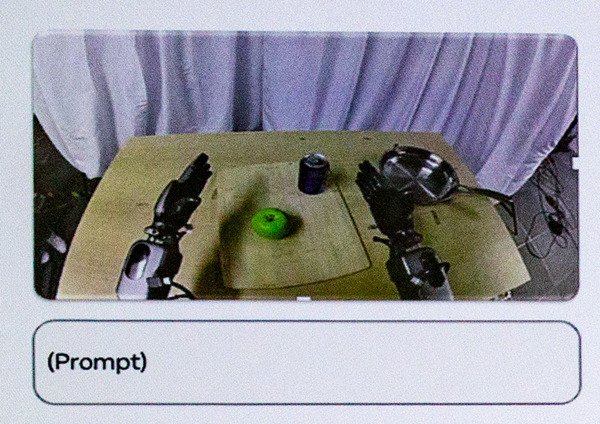

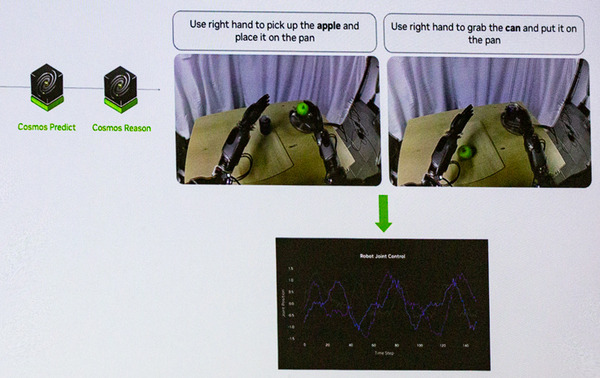

前回解説した世界基盤モデル「Cosmos Predict」を活用したもので、上のスライド画面でいうと、左上の1枚の画像とプロンプトによってモーションを生成する(下図も参照)。

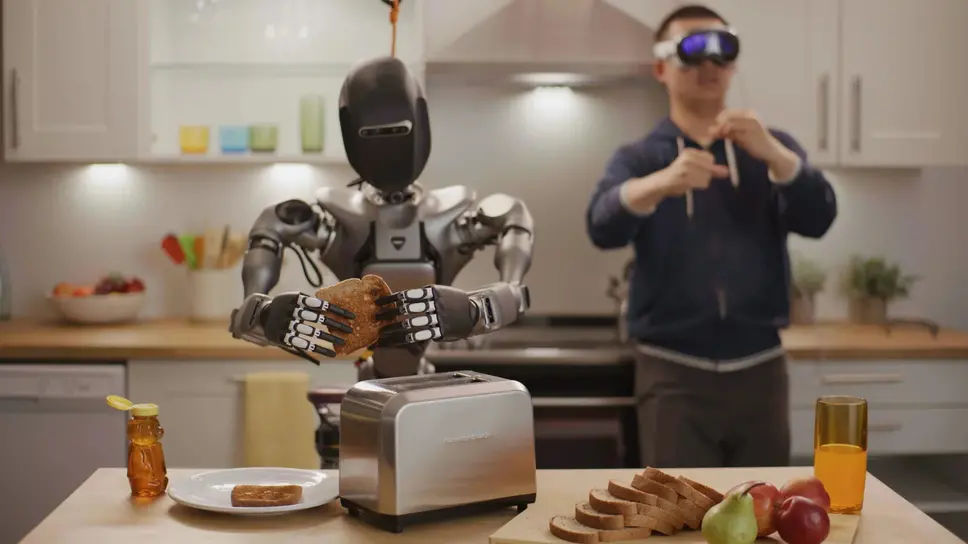

例えば「リンゴをつかんで右のフライパンのところに置いてください」といったプロンプトに従って、Cosmos世界基盤モデルを通して行動すべき動画が生成される。

「GR00T Dreams」は静止画などの初期画像をもとに、言語命令プロンプトの入力に従って、ロボットが動作する動画(未来予測動画)を生成することで、動作のバリエーションを想像的に作り出して増やす、ものになっている。

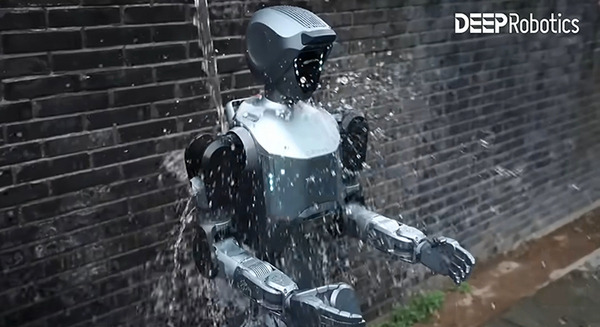

リアル世界で再現が難しいシーンの生成も

「GR00T Dreams」は、リアル世界ではデモで再現することが難しいシーン(例としては、人が怪我をしたり、火事になる結果を招くシーンなど)でも、デジタル上で再現することでモデルに経験させることができ、未知の環境下での動作のバリエーションも増やすことができる。

GR00T-Dreamsで想定されている具体的なタスク例

繰り返しになるが、前述のパイプライン(Teleop→Mimic→Gen)では生成が困難な学習用データを、「GR00T-Dreams」と世界基盤モデルを使って創造的に生成することで、想定できるあらゆる状況の学習データを用意し、汎化性能を向上させようというもの。

最後に著者による補足になるが、「GR00T-Dreamsで想定されている具体的なタスク例」をNVIDIAのブログ等からまとめて表記しておこう。

1.未知の環境での移動・探索

ロボットが初めて見る廊下を探索し、ドアの前で停止する動作を生成。

GR00T Teleopでは実際に全ての建物や廊下を操作・収録するのは不可能だが、Dreams なら新しい環境バリエーションを仮想的に生成できる。

2.人間との協調作業

人が工具を差し出したときにロボットが自然に受け取る、本を手渡すときに安全な角度で持つ動作を生成。

GR00T Teleop で実際にすべての「手渡しパターン」を収録するのは困難だが、多くのDreams ならバリエーションを想像的に創り出せる。

3.複雑な物体操作(Manipulation)

ロボットが初めて見る形の椅子を持ち上げて移動する、皿を棚に片づける、といった動作を生成。

GR00T Mimicで量産できるのは既知の物体を使ったバリエーションに対して、世界モデルとDreamsなら「見たことのない家具や道具」でもデータを合成して生成可能。

4.不安定な状況でのリカバリ動作

ロボットがつまずいた際に倒れないようにバランスを取り直す動作を生成。

リアルではロボットを転ばせると危険であり、コストと時間がかかるが、Dreamsなら仮想的に無数の転倒・リカバリ動作を生成して繰り返すことも可能。

加瀬敬唯氏によるセッション「フィジカルAIで加速するヒューマノイドロボティクス NVIDIA Isaac GR00TとCosmosの紹介」をもとに、著者の解説を踏まえながら3回に渡って、NVIDIA CosmosとIsaac GR00Tを解説してきた。

NVIDIAのプロジェクトも実質、2025年から始まったばかり。ヒューマノイドロボットにも最適な、最新のエッジ搭載用のAIスーパーコンピュータボード「Jetson Thor」(ソー)のリリースもいよいよこれからというタイミングだ。

今からでも遅くない。

今回の記事がロボットの研究や開発を検討する一助になればうれしい。

1.NVIDIAが語るフィジカルAIで加速するヒューマノイド開発の最前線 ドメインランダム化とシム2リアル 「NVIDIA AI Day Tokyo」レポート(1)

2.ヒューマノイド開発を支援する「NVIDIA Cosmos世界基盤モデル」とは・・ 世界モデルと世界基盤モデルの違いを解説 「NVIDIA AI Day Tokyo」レポート(2)

3.生成AIで進化したNVIDIAヒューマノイド開発基盤「Isaac GR00T」を詳しく解説 「NVIDIA AI Day Tokyo」レポート(3)

NVIDIAのオンラインセミナー 見逃し配信を公開中

を2025年7月29日(火)に、ロボスタ初のオンラインセミナー「NVIDIAがヒューマノイド開発を身近にする、フィジカルAIとロボット開発プラットフォームの全貌を聞く」を開催しました。プレミアム会員になると、見逃し配信(動画)を視聴することができます。詳細はこちら

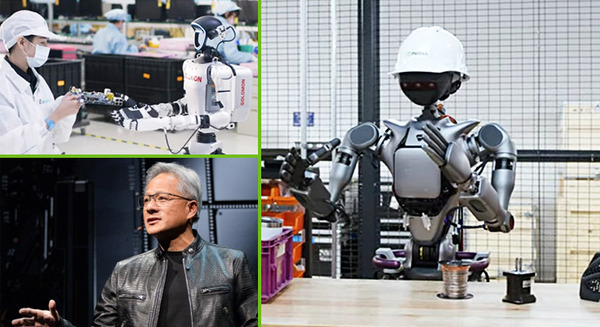

世界一のAI企業、NVIDIAはヒューマノイド向けAIやロボットの開発基盤「NVIDIA Isaac GR00T」の提供を2025年から開始しました。

NVIDIAが提供するフィジカルAI開発のためのプラットフォーム「NVIDIA Omniverse」や、ロボティクス向けの「NVIDIA Isaac Sim」などによって、ヒューマノイドロボット開発の効率が格段に向上したと言われています。世界的に知られるロボット開発企業も既に使い始めています。

セミナーでは、それらの事例を踏まえながら、ヒューマノイドや業務用ロボットをどのような方法で開発を始めればばいいのか、従来の開発プロセスとどのように違うのか、今後、どう変わっていくのかなどを、NVIDIA担当者によるプレゼンテーションとロボスタ編集長・神崎洋治による深堀りで全貌を解明していきます。

詳細はこちら

NVIDIAが語るフィジカルAIで加速するヒューマノイド開発の最前線「NVIDIA AI Day Tokyo」レポート ドメインランダム化とシム2リアル

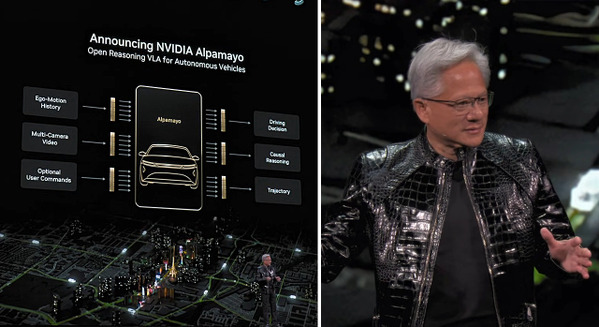

次世代自動運転「NVIDIA DRIVE AGX Thor」開発者キットを提供開始 リーズニング視覚言語アクションや生成AIにも最適

NVIDIAが産業用ロボティクスの開発・実装を加速、新しいフィジカルAIモデルとデジタルツイン・ライブラリを発表 Cosmos WFMは200万DLを突破

href=”https://robotstart.info/company/nvidia”>NVIDIA 関連記事