涙がこぼれるほど感動する、それはとても幸せなことです。

生活範囲のほとんどが自分の部屋や家の中だけとなってしまっている高齢者が、遠く離れた結婚式の披露宴会場に瞬間移動し、たくさんの人達に祝福されている孫夫婦の様子をまるでその場にいるかのように感じられたなら・・

その体験にどれほど心を揺さぶられたことでしょうか。

Pepper App Challenge 2015 Winter最優秀賞に輝いた「HUG」

Pepper用のロボアプリNo.1を決める開発コンテスト「Pepper App Challenge 2015 Winter」(以下 PAC2015と表記)が、2015年11月28日に開催され、ダックリングズの「HUG Project」(HUG)が最優秀賞を受賞しました。Pepperが成り代わり、本人がまるでその場にいるかのようにコミュニケーションをはかることができるシステムです。本人がPepperに乗り移ってその場に参加できるシステム、と表現した方が良いかも知れませんが、未来感があって、かつそれを実際の生活の中で実践したことが評価されての受賞でした。

この「HUG」、じつに面白いのです。

いまロボットとともにとても注目されている技術にVR(Virtual Reality:バーチャルリアリティ)がありますが、HUGはロボットとVR、両方の最新テクノロジーを上手くマッチさせ、手足、頭の動きでロボットの操作を実現しています。まるで近未来の傀儡師(くぐつし)、人形つかいのような話ですが、それを支えている技術を探りました。

実際の結婚式にお婆ちゃんの分身として参加したPepper

その日、ソフトバンクロボティクスのロボット「Pepper」は、寝たきりのお婆ちゃんに代わって披露宴に出席していました。お婆ちゃんの腕の動きや視線に合わせてPepperも同様に動作し、見て、聞いて、話し、あたかもお婆ちゃんが披露宴に参加しているかのように振る舞います。友人達の祝福を受けながら新郎新婦が満面の笑みでPepperのそばに近付きます。新郎新婦が拡げた両手に呼応するようにお婆ちゃんも震える手を大きく拡げると、新郎新婦は手を広げたPepperとしっかりと抱き合いました。お婆ちゃんは震える声で「おめでとう」と新郎である孫につぶやき、新郎も「ありがとうね!」と答えました。

HUGを開発したきっかけは「病室で寝たきりのお婆ちゃんにも結婚式に参加してもらいたい」というダックリングズ代表取締役、高木紀和氏の思いでした。高木氏本人の結婚式本番でこのシステムを実際に稼働させ、愛知県犬山市で寝たきりのお婆ちゃんが東京で行われた披露宴にロボットで参加したのです。

その時の映像がこちら

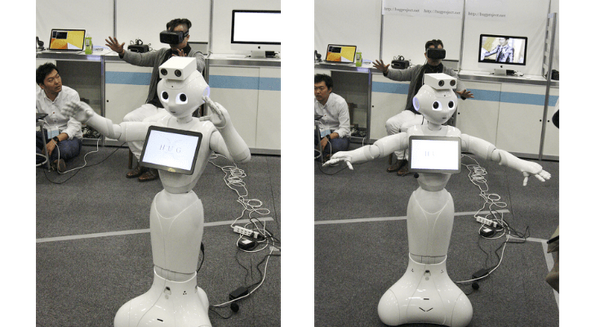

PAC2015の会場でロボットへの乗り移りを体験

疑似体験や仮想現実の「VR(Virtual Reality)」が再び注目されています。ゴーグル型のヘッドマウントディスプレイ(以下、HMDやヘッドセットと表記)を装着し、広い視界の空撮映像やCGによる立体映像等を観た経験がある人もいると思います。ゲーム機での利用も進められていて、今年9月に開催された東京ゲームショウ2015ではソニーのプレイステーションVRが出展され、注目を集めました。HUGはこのヘッドセットや各種センサーを使って、現場のロボット(Pepper)を頭や腕の動きで操作することができ、Pepperが見ている視界の映像をディスプレイで見ることができるシステムです。

そうは言っても「頭や腕の動きでどうやってロボットを操作するの?」と、具体的にはピンと来ないかもしれません。

PAC2015の会場では、コンテスト出場者によるブースが設けられていて、最優秀賞を受賞したHUGのブースでもPepperとシステムが展示されていました。来場者がロボットに乗り移る疑似体験もできましたので、早速、私も体験してみました。

まず体験者であるユーザはゴーグル型のヘッドセットを装着します。視界を完全に覆うタイプのHMDです。かぶるように装着するともう景色(映像)が見えていますので、景色がはっきり見える顔の位置にヘッドセットをずらして装着は完了です。目の前のディスプレイに見えている映像はPepperが見ている視界です。頭をゆっくり右に振るとその動きに合わせてヘッドセットの映像の視界も動きます。実際にはユーザの頭の動きに合わせて、Pepperが頭を右に振ったことで視界が変わっていきます。

Pepperの頭の可動範囲には限界があるので、ユーザがそれ以上に首を動かした場合、Pepperはユーザが見たい視界を追従するために身体ごと向きを変えます。このようにPepperが動いてユーザが見たいところを映像として見られるだけでもVR的でとても面白いのですが、それは序の口でした。

Pepperの視界で映像が見えていると解っていても、そのときはまだPepperが自分自身の分身としてそこに存在している、という実感はまだありませんでした。実感したのは、自分の手を前に差し出し、頭を下げて手のひらを見下ろした時。視界の中の自分の手がPepperの白い手になっています。自分の手を上下に動かすと白いロボットの手が上下に動き、指を開くとPepperの指が開く・・・このときロボットとの一体感、バーチャルリアリティの没入感を体験することになったのです。

ユーザが腕を拡げれば、Pepperも大きく腕を拡げ、頭の向きを変えればそれに呼応してPepperも向きを変えます。Pepperの周囲にいる人はPepperとしてであってもユーザの存在を感じ、前に立っている人はPepperの動作に呼応してハグ(抱き合う)したり、手を差し出せば握手をして応えてくれます、これはロボットならではの疑似体験であり、コミュニケーションと言えるでしょう。

体験してますます、このHUGがどのような技術で実現しているのか興味がわきました。そして、そのしくみは調べれば調べるほど面白いものでした。

HUGを実現したVR技術とそのしくみ

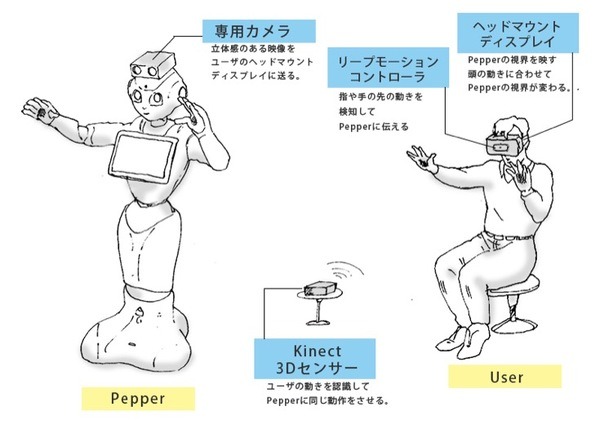

HUGには大きく分類して4つの技術が融合されています。

ひとつはPepperのロボット本体、これは既にご存じの方は多いと思いますがソフトバンクロボティクス製のサービスロボット。Pepper本体には頭の位置に専用カメラが装着されています。ほかに、ヘッドマウントディスプレイ(HMD)、リープモーション、キネクトで構成されています。

頭の傾きや視線でPepperの視界を変えられる

ヘッドマウントディスプレイは目の前で映像が見られる小型のディスプレイですが、今や機能はそれだけにとどまりません。HMDにセンサーが内蔵されていて、頭の傾きや動きを検知しています。人の動きを認識する技術は「モーションセンシング」と呼ばれ、ユーザの頭の向きや傾きを検知する機能を「ヘッドトラッキング」と言います。製品としては「Oculus Rift」(オキュラス社)などが注目されています。

PAC2015の体験ブースではOculus Riftを使用し、ユーザの頭の動きをトラッキングしてPepperの頭を連動させました。Pepperの頭の可動範囲いっぱいを超えて、それ以上にユーザが頭を動かした場合、Pepperは身体ごと回して視界を追従する機能をもたせています。

なお、結婚式の際には、ヘッドセットに「Oculus Rift」とは別の「FOVE」(フォーブ社)を利用しました。FOVEはヘッドトラッキング機能に加えて、ユーザの視線を検知するアイトラッキング機能を併せ持っています。寝たきりのお婆ちゃんは頭を動かすより、視線だけで視界を変えたり、Pepperの向きを変えられる方が便利だろう、という配慮からです。FOVE社はソニー・コンピュータエンタテインメントのゲームプロデューサーだった小島由香氏と顔認識技術の専門家のロックラン・ウィルソン氏が共同で創業したスタートアップ企業です。肢体不自由の人が目線(視線入力)でピアノをコード演奏するEye Play the Pianoプロジェクトの実績も持っています。

このようにHUGは、ヘッドセットに「Oculus Rift」を使えばヘッドトラッキング機能でPepperの視界を操ることができ、FOVEを使えば視線だけでもPepperの視界を操ることができる機能を持っています。

Eye Play the Piano

▽ FOVEのホームページ(参考) http://www.getfove.com/jp/

腕、指の動きを3Dセンサーでトラッキング

上半身の動きで要となるのが腕の制御です。HUGではユーザの腕の動きを「Kinect」(キネクト)、手の動きを「Leap Motion」(リープモーション)でセンシングしてPepperに伝達しています。

Kinect(Xbox One用Kinectセンサー)はマイクロソフトが発売している3Dセンサーで、「Kinect for Xbox 360」等、コントローラを使わずに手足や頭等、ユーザの動きによってゲーム内のプレイヤーを操作できることで知られています。最近のモデルでは人の動きを読み取るだけでなく、その情報を処理するプロセッサも機器内に搭載しています。

指や手の動きを認識しているのは Leap Motion Controllerで、ヘッドセットの前面部に取り付けてあります。手を前方に出すと指や手の甲(平)を検知、指先一本一本の動き、前後左右、上下、ひねりなど、100分の1mmの精度で認識できるとされています。Pepperの場合はそれぞれの指を独立して動かすことができないので、グーかパーの制御になってはしまいますが、HUGでは指の動きも検知することができます。

Leap Motion

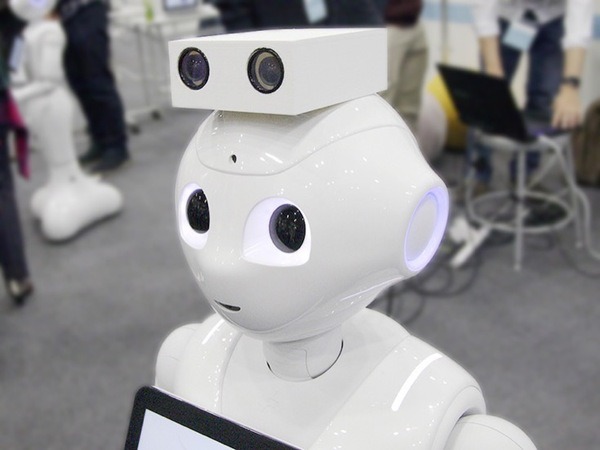

Pepperの頭部に装備したカメラ

Pepperの頭部には専用のカメラが別途装着されています。

Pepper本体の顔部には標準で額とクチにカメラが装備されていて、額のRGBカメラが主に前方を見ています。しかし、このカメラの映像ではVRの臨場感やリアリティを達成できないと判断し、別途頭部に60フレーム/秒(60fps)で映像が見られる専用のカメラを装備して機能の拡張をはかっています。フレームの数が少ないと映像がカクカクとした表示になってしまいますが、一般の映画では24fps、テレビ放送等の映像は以前から30fps等が目安となっているため、60fpsはスムーズな映像再生には十分な性能です。

では、なぜ専用カメラは二眼なんだろうか、と気付いた人もいるでしょう。

これは左右の目の視差をとって立体感を演出するため。すなわちユーザはヘッドセットで立体視された映像を見ていることになります。これも臨場感を増すには重要な機能です。

HUGは実用化しはじめているVRのコンポーネントを使い、市販ロボットとしては今までにない大きさのPepperと巧みに組み合わせ、ニーズを実現させています。私もHUGの先進性と未来感を高く評価したいと思いますし、Pepperのコンテストの最優秀賞にふさわしいプロジェクトだと感じました。ダックリングズでは、ロボット関連を含めたシステム開発事業者が比較的簡単に現場に導入・運営できるシステムとして、まずはこのHUGの完成度を高めていく、としています。

今後の課題

HUGの受賞を祝福するとともに、その一方で「Pepper App Challenge 2015 Winter」が、一般ユーザ向けのロボアプリ開発コンテストだという前提を考えたとき、違和感を感じることも確かです。HUGをはじめとして今回、出品されたいくつかはロボアプリに種別されるべきものなのかという疑問です。今回は「Pepper Innovation Challenge 2015」という(よく似た名前ですが)Pepper活用による課題解決ソリューションを対象にしたコンテストも併設されています。そのことからも、ロボアプリや課題解決ソリューションの位置付けを明確にした方がよかったのではないか、と感じています。

また、今回のコンテストはPepperの今後の課題をきわめて明確にした大会でもあったと思います。

次回は、ロボアプリの開発とビジネス、ロボアプリストアとiPhoneを絡めて解説したいと思います。また是非ご覧ください。