最近のニュースで注目されているキーワードのひとつに「ディープラーニング」があります。革命的にコンピュータが進化して、ディープラーニングによって世の中がひっくり返るほどの変化が起こるのではないか、と期待している人も多いと思います。とはいえ、今ひとつ実態がよく解らないディープラーニング、どんなことに使われるのでしょうか?

今回は、お馴染みPepperでは、このディープラーニングとどのように連携し、どのようにこの技術を活用しようとしているのかを考えます。

ディープラーニングとは

ディープラーニングを詳しく解説すると膨大で難解な原稿になってしまうので、今回は一般的に知っておきたい知識として、誤解を恐れずに簡潔に解説したいと思います。ディープラーニングとは「繰り返し学習することで特徴を発見する自律学習」のことです。人間の構造を模したしくみと言われ、人がものを認識したり学習する過程に近いことや、自動的に学習していく点などが注目されていて、「人工知能(AI)」が進化するために重要な技術のひとつと言われています。

という説明でもまだ難しいので、最も有名なディープラーニングの実績例を紹介すると、米Google社が買収したディープマインドという会社が開発したディープラーニングのシステムは、1000枚以上のYouTubeの画像を見せ続けることによって「猫」という存在を学習し、画像に猫が写っているかどうかを判別できるようになったと言います。

コンピュータが自律的に学習して理解を進めていく…このような発表にはなにやら空恐ろしいものを感じますが、なにせこのディープラーニング、なんでこれほど賢く学習できるのか、その一部はまだ研究者たちにも解明されていないという点も実に謎めいています。

ディープラーニングは広い分野で実用化を目指して研究や開発が進められていますが、先のGoogleの例のように、現時点でまずは飛躍的な向上が見込まれているのが画像や音声等の解析分野です。いろいろな企業から試作の段階ながらいくつかのツールが登場したり、デモンストレーションが行われ、実際の製品やサービスへの組込みが行われ、実用化が少しずつ始まっています。

では、このディープラーニング、ロボットの分野では近い将来、どのような機能として利用が見込まれているのでしょうか。

とりわけ注目されているソフトバンクの「Pepper」では、この技術をどのような用途に使おうとしているか、開発者やコンサルタントの方はもちろん、一般のニュースウォッチャーの皆さんもとても気になっているところだと思います。

Pepperでもディープラーニングの実装とその活用が予定されています。その片鱗は、ソフトバンクが2015年7月に開催した「SoftBank World 2015」において、孫正義氏による基調講演で披露されています。今回は、ソフトバンクが現時点で公表しているディープラーニングとPepper連携に絞って解説します。

Pepperにおけるディープラーニングのデモンストレーション

SoftBank World 2015の基調講演で孫氏は、情報革命の大きな可能性としてIoT(モノのインターネット)、AR/VR(拡張現実/バーチャルリアリティー)、AI(人工知能)、ドローン、クラウド&ビッグデータ、ウェアラブルデバイス、ナノマシン、そしてスマートロボットをキーワードとして掲げ、特にIoTとAI、スマートロボットは「3つの成長分野」として特に注目していることを示しました。

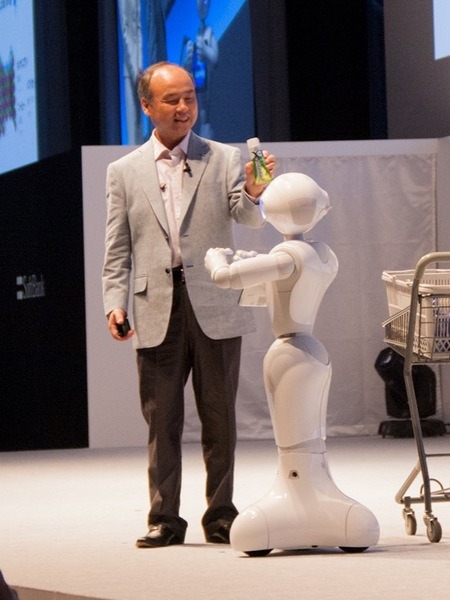

ソフトバンク社の構想として、現時点では「Pepper」がスマートロボットの中心となるのですが、この基調講演ではPepperの新しい機能(開発中の機能)として「ディープラーニング」が紹介され、ステージ上でデモンストレーションが行われました。

ちなみにこの時、孫氏より来場者に対して「ディープラーニングというワードを知っているか」という質問が行われ、挙手した人は全体の約2割くらいでした。

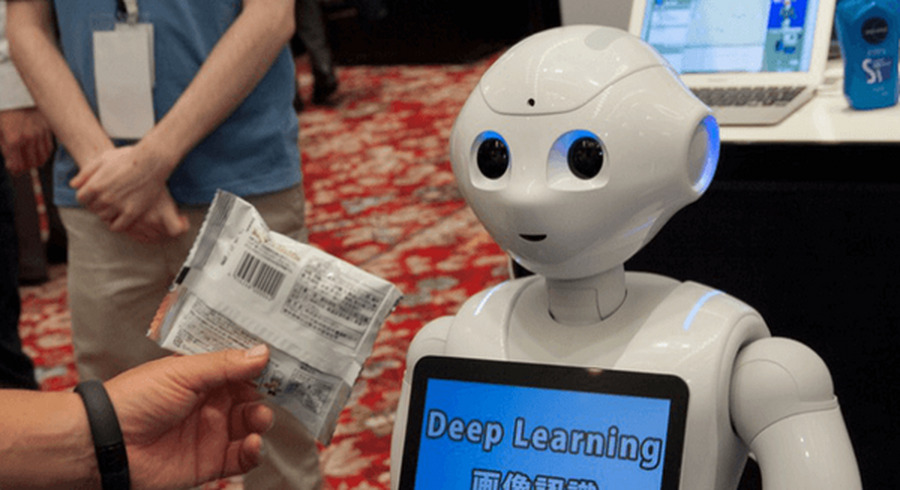

デモの舞台はドラッグストア。まず、アシスタントの女性が中にいくつか商品が入ったカート(買い物かご)を持ってステージ上に出て来ました。Pepperがドラッグストアの店員、孫氏はドラッグストアに来たお客さん役です。孫氏はカートの中から商品をひとつ取り出して、Pepperの顔の前に差し出して見せます。

するとPepperは孫氏が持っている商品を画像で認識し、「○×石鹸ホワイトです、肌にやさしく洗える、クリームみたいな石鹸です♪」と商品名と特徴を音声で説明しました。

続いて孫氏がシャンプーのボトルを差し出して見せると、Pepperは「○×薬用シャンプーです。吸い込む泡が毛穴の脂もニオイもすっきりと落とします♪」と説明します。孫氏はその様子に感心しながら「育毛効果もあるといいんだけど・・」と返して会場がどよめく一面もありました。

ここまでは、技術的に見るとお客さんが差し出した商品を画像として取り込み、製品部分を抽出して形状やデザインを認識し、商品名を特定して解説する、といった流れです。

続いて、孫氏が3つめの商品である、ハミガキ剤をPepperの顔の前に差し出します。

しかしPepperは「すいません♪、それは覚えていません、教えてもらえますか?」と回答します。Pepperが記憶している商品リスト、いわゆるデータベースに載っていない商品だったようです。

そこで孫氏が「そうか、じゃあ教えよう」と言って、再度ハミガキ剤をPepperの顔の前に差し出し、「これはね○×クリーンEXだよ」とパッケージから読んでPepperに教えます。

するとPepperは「ディープラーニングぅぅ♪」と両手を上げて叫び(このポーズ自体は演出ですね)、「はい、覚えましたぁ♪ もう一度見せてください」と言います。

再び、孫氏がハミガキ剤をPepperに見せて「これはなにかな?」と聞くと「それは○×クリーンEX フレッシュミントです。歯のミクロのデコボコにある歯垢を落とす新商品です♪」と応えました。

孫氏は「商品名を覚えただけじゃなくて自分で検索したのか」と感心し、商品の説明までこなしたPepperを褒めてあげます。気分をよくしたPepperは、「僕は将来このように、ディープラーニングとワトソン(IBM Watsonの意)を組み合わせてどんどん学習していきます♪」と宣言しました。

・・と、こういう流れでした。

自律学習の可能性が拡がる

最後のハミガキ剤についてはお客さんが見せた画像から製品部分を抽出して基本的な商品名を特定し、それを素にインターネット上の情報を収集して商品説明部分を抽出する、という例を演出したデモでした。ちなみにこのハミガキ剤「○×クリーンEX」にはフレッシュミント、スプラッシュクール、リッチシトラスの3つの味があります。お客さんが教えた情報は「○×クリーンEX」のみでしたが、画像からそれが「フレッシュミント」であることも劇中では特定しています。

まだ開発中の機能なので技術的な詳細は不明ですが、デモの解説のとおりの手順をPepperが踏んだと仮定すると、次のような流れで学習が行われたと推測できます。

画像と「○×クリーンEX」という情報からインターネット上の公式ホームページを検索し、ホームページ内に記述されている内容をワトソン等で解析、商品の特徴にあたる文章を抽出します。更に3つの味があることを解析し、ラベルの画像(デザイン)の違いから、この画像の商品は「フレッシュミント」であることを特定、他の味のラベルについてもホームページから同様に記憶する…ということが考えられます。そして、その画像認識や説明解析の部分にディープラーニング等の技術が活用されます。(ワトソンの機能や特徴についてはまたの機会に詳しく解説します)

ちなみに、従来の画像認証は画像が一致しているかどうかを判別して特定する技術が中心でした。全体のバランスやパーツごとの形状が一致しているかどうかを判断するものです。しかし、立体のものを認識する場合は同じ方向から見るとは限りません。同じ方向からきちんと見せれば高い精度で認識するという段階を経て、もう少し曖昧に、異なる角度でも被写体が何であるかを認識する、といった段階に進化しています。そして更に、人間の脳がものを判別するのに似たプロセス、すなわち従来とは別のアプローチから認識したり学習するディープラーニングも導入することによって認識精度を格段に向上できるのではないか、と考えられています。

実際にPepper×ディープラーニングを体験

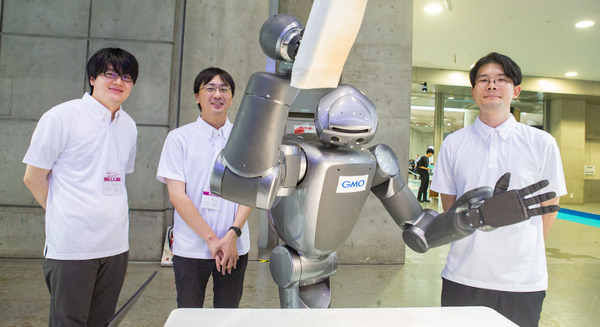

SoftBank World 2015では基調講演やセミナーのほかに、各社の展示ブースが設けられていました。ソフトバンクのブースではPepperによるディープラーニングを使った画像認識のデモが実演されていたため、基調講演よりもう少し詳しい説明を聞くことができました。

ブースでの体験デモの内容は、来場者がいくつかの製品からひとつを選んでPepperに見せると、その製品名等をPepperが音声で応えるというシンプルなものです。その時のデモではワトソンとの連携はされていません。

その時の認識のしくみが従来のものとは異なります。例えば、従来であれば製品の写真を様々な角度から撮って画像としてデータベース上に登録しておき、来場者が差し出した画像を検知して、全体像や特徴的なデザイン等、マッチしたものを該当製品として回答するというのが一般的なしくみだったと思います。

Pepperのディープラーニングでは、何枚もの画像を認識させることによって自動的に直線を見分ける疑似神経細胞や丸みを見分ける疑似神経細胞など、いろいろな疑似細胞がソフトウェア的に作られていき、そのような原始的な(基礎的な)形状を見分ける疑似神経細胞がたくさん作られた結果、それらを組み合わせていくと、直線と曲線、色の組み合わせ等から「特徴量」を発見できるようになり、例えば「○×クリーン」のハミガキ剤だろう、これはワッフルだろう等と認識するのです。

もちろん、この解析作業では、CGデータのような立体図面のようなデータを持っているわけでもありません。それでも、光の反射が異なる、てかり方が異なる、といった識別や形状による変化も、Pepperではディープラーニングで学習できるようになるだろうと考えられています。

一方、現段階ではハミガキ剤などの製品では裏側を見せた場合は間違う確率は高くなるということです。これはドラッグストアなどの販売店において、顧客に対する差別化のためにオモテ面には特徴的なデザインを採用しているものの、ウラ面はどれも似ているデザインが多く、特徴を明確に見いだせない可能性が高いためです。しかし、これは人間でも間違うレベルのもので、実際にもしも、ドラッグストアの店舗の棚にすべての商品が後ろ向きに並べられていたら、判別がしづらくて大変、きっとお客様は混乱してしまうことでしょう。

デモの内容は実際にはどのように使われる?

今回のデモで見たPepperは実際はどのようなケースで導入される可能性があるのでしょうか。画像と音声の認識や発話はロボットにとって重要なインタフェースです。それらの精度が上がることはロボットの利便性に大きく関わってきます。なんど見せたり話しかけても「ちょっと解らないなぁ」なんて回答を連発されたら興ざめしてしまいますが、認識率が上がり、自律学習していけばやりとりが格段にスムーズになるでしょう。

また、今回のデモの機能、そのものの利用を想定すると、例えば大型玩具店のトイザらスや欧米の大手量販店等では、陳列している商品のバーコードを読み取らせると販売価格が表示される機械が店舗内に置かれているのを見かけます。近い将来、バーコードを照らすのではなくではなく、Pepperに商品のパッケージを見せると商品名と販売価格、商品の特徴を喋って回答する、更にはオススメの商品を紹介してくれるというシステムがスムーズに行えることが考えられます。

また、その場合は店舗が商品名と実売価格などの基本的なデータを用意する必要はありますが、画像等はPepperに見せて解析させることで登録を行っていけるでしょう。登録作業もあたかもヒトに教えるように行われるかもしれません。

ディープラーニングの場合は店舗が扱う商品に合わせて、適切な特徴量をとれるようにトレーニング(チューニング)を行っていくことで、解析や認識の精度(正解率)を上げていくことができる、とされています。また、近い将来は実際にメーカーのホームページから製品の特徴などの情報を収集できる可能性もあり、そうなればPepperは自動的に商品の情報を学習していくので店舗側の登録の手間も格段に少なくなることが期待できます。

最後にもう一度、展示ブースでシャンプー商品のボトルを胸の辺りに持ってPepperに見せて・・・

「これなに?」

と、尋ねてみました。

するとPepperは私の方を見て「それはね~・・・・♪」と言った後、画像を認識した合図である”ポロン”という音を鳴らして・・

「社員証ですね~♪」と応えました。

私もスタッフたちも一瞬「えっ!?」と驚きましたが、どうやらPepperは私が首からかけていた「報道関係者証」を見ていたようで、それを社員証と認識してしまったようでした。

間違え方の可愛さにブースにいた人々は大笑い、スタッフは苦笑いでしたが、もう一度シャンプーを見せてやり直すと、Pepperは正しく認識して製品名を言ってくれました。

これは2015年夏の時点のこと。

もちろん明日、明後日に実用化できる技術とは限りません。しかし、2016年はもっと進化したディープラーニングの世界をPepperやロボットたちは見せてくれるでしょう。2016年も機会があれば、取材等を通じて更に詳しいロボットとディープラーニングの情報をお届けできると思っています。お楽しみに。