TensorFlow勉強会(4)に「唐揚を掴むロボット」が登場!

TensorFlow勉強会(4)に、株式会社アールティの中川さんが登壇し、「TensorFlow唐揚サーバーロボット」を披露しました。

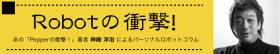

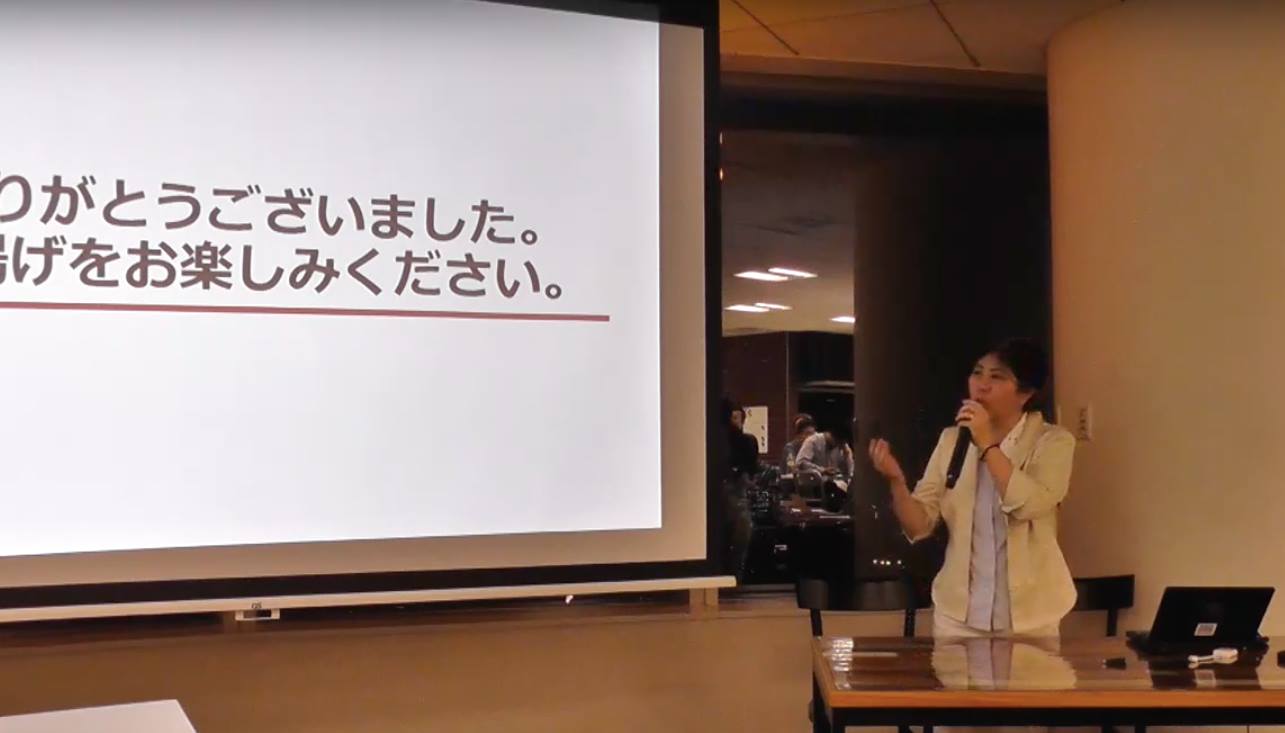

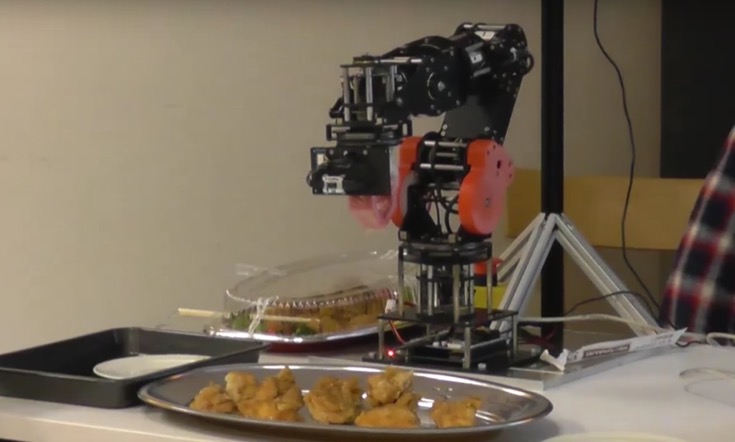

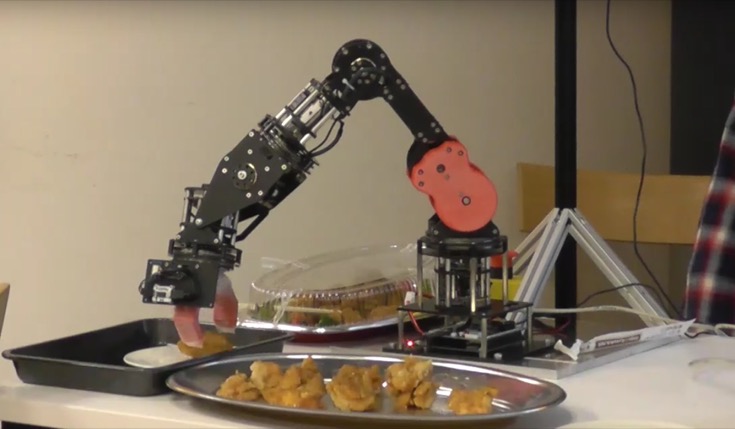

行われたのは、WEBカメラ・トルク指令型のロボットアーム「NEKONOTE」・Linux PC(画像処理・ROS)を組み合わせたデモです。

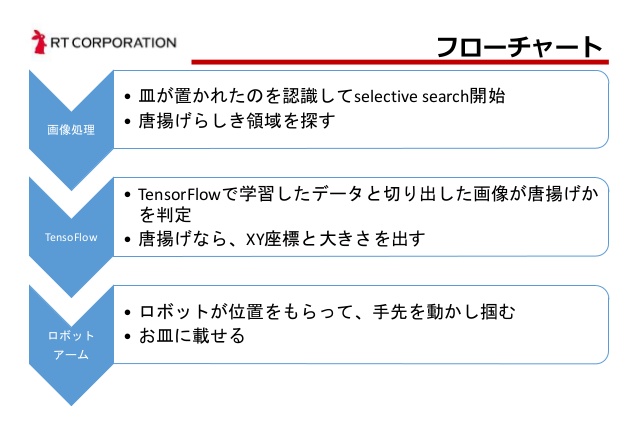

唐揚げロボットの流れは、お皿が置かれたのを認識して、「selective search」を開始、唐揚げの位置を特定して、アームが掴み、お皿に載せるという流れです。

これらのデモの様子は以下の動画の2時間20分あたりから御覧ください。

唐揚げを判定する部分には、TensorFlowで構築したニューラルネットワークが使われています。

そのためには、まず、学習データ(唐揚げの画像)を与える必要がありますが、ネットで画像検索しても、大抵はお更に盛られた画像ばかりで、唐揚げ単品の画像は皆無。そこで、無ければ作るしかないという事で、中川さん宅の食卓には毎週土曜日に唐揚げが並んでいたそうです。

「なぜ “唐揚げ” を選んだのか」という問いには、「特に意味は無かった」と回答されていました。ただ、食品を掴むというのは、柔らかく、潰れてはいけないので「最後に残されたフロンティア」と言われるくらい難しいとのこと。

掴む部分の素材は、食品を扱う時に使う普通のゴム手袋。つまり、唐揚げをつかんだのは、ロボットアーム自体の性能によるところが大きいようです。このロボットアーム「NEKONOTE」は、JSONで手軽に制御することができます。

ご興味がある方は、当日のスライドが公開されていますので、ご参照ください。

このように、いつもギークなお話が聞けて面白い「TensorFlow勉強会」。今回は、旬ということで、DQN(deep Q-network)の話が多かったように思います。ご興味がある方は、こちらに動画がありますので、ぜひご覧ください。

※唐揚げはスタッフで美味しく頂きました。

この記事を読んだ人におすすめ

関連する記事はまだありません