NECは、顧客に合わせてカスタマイズ可能な「ジェネレーティブAI」(生成AI)を開発、大規模言語モデルを発表した。それに関連したジェネレーティブAI関連サービスをトータルで提供、7月から開始する。売上高目標は3年間で500億円を見込む。

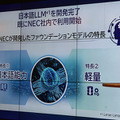

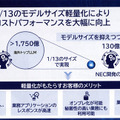

LLMは日本語に特化し、性能で海外製のLLMを凌駕しつつ、パラメータサイズが13分の1とコンパクト、超軽量化をはかったモデルとなっているのが最大の特長。

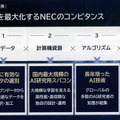

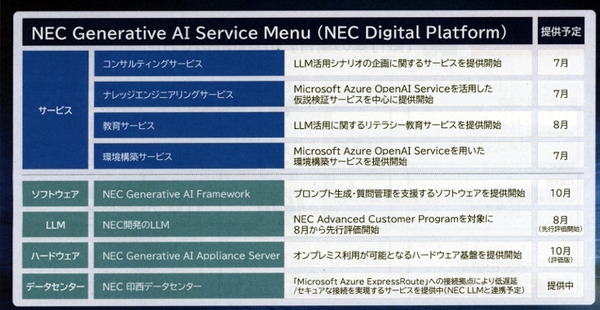

LLMのライセンス、日本市場のニーズに合わせた専用ハードウェア、ソフトウェア、コンサルティングサービスなどを含めた「NEC Generative AI Service」として順次提供する。

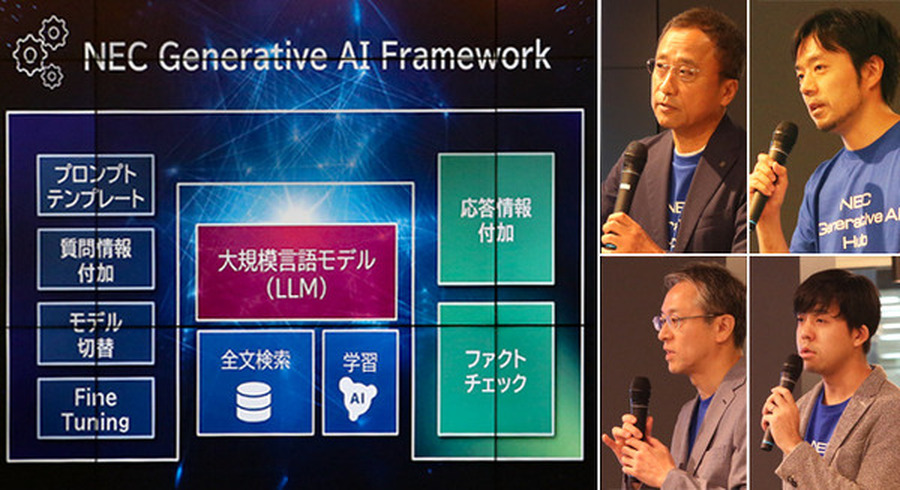

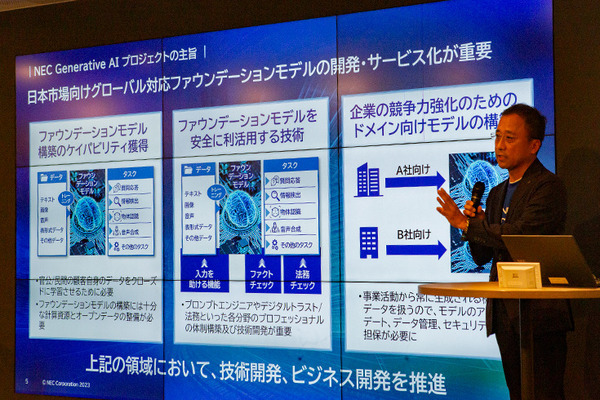

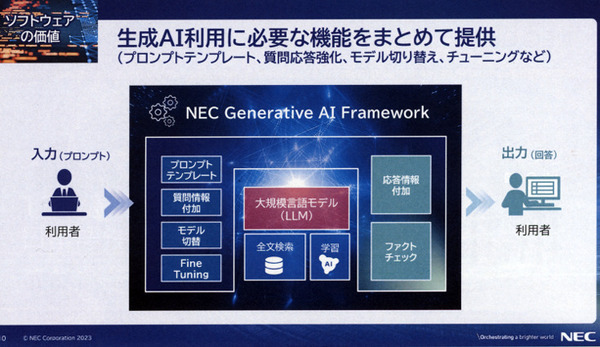

NECは「Generative AI」を多くの企業が社会実装しやすいように、中核のコア技術だけでなく、プロンプトのテンプレート、チューニングなど、必要な機能やサービスをまとめて提供していく考えだ。

同社は、2023年7月6日、報道関係者向けに説明会を開催し、その展望とサービスや技術の詳細、デモを公開した。この記事ではデモの動画を4本紹介する。

NEC Generative AIプロジェクトの構成と5つの価値

吉崎氏は「構想4年、LLMの開発に2年、全社タスクを半年かけて発表に至った全社をあげて取り組むプロジェクト」と語り、サービス開始にかける意気込みを語った。

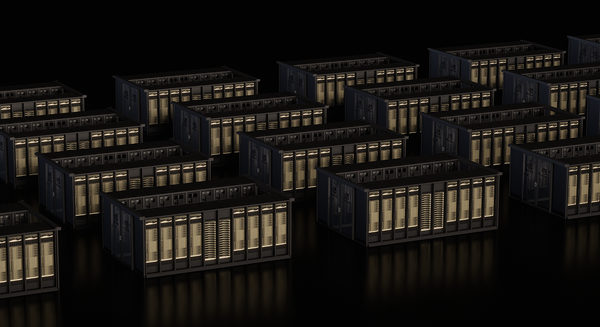

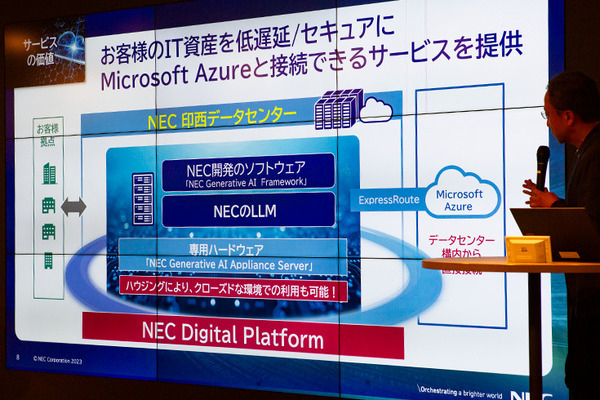

既に、NECの印西データセンターに「NEC Generative AI Framework」を構築しており、NECのLLMが稼働している。クラウドサービスとしてクライアントの拠点からアクセスして活用できるほか、Microsoftと連携し、Microsoft Azureのサービスとしても提供していく考えだ。

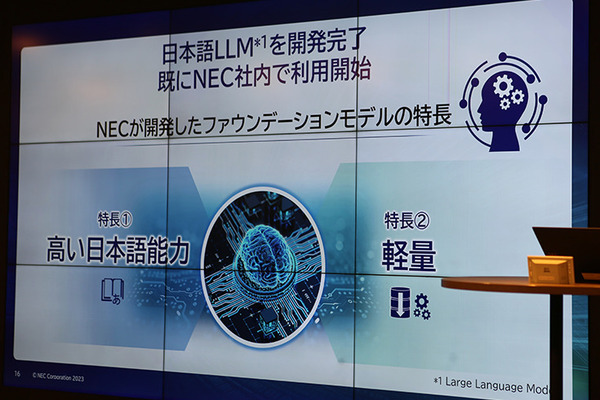

NECが独自に開発した大規模言語モデルの2つの特長

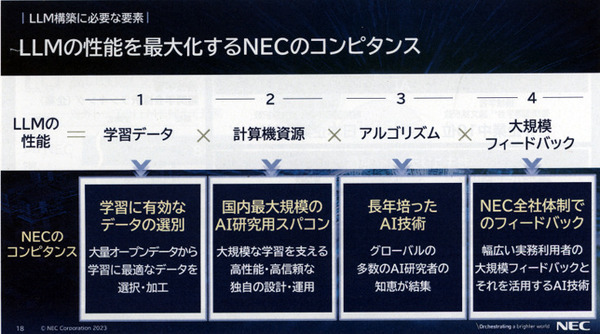

今回発表された「NEC Generative AI Service」の中核となるのは、NECが独自に開発した大規模言語モデル(LLM)だ。このLLMには「高い日本語能力」と「軽量」という2つの大きな特長がある。

このLLMはNECが独自に収集、加工した多言語データを利用し、NECが日本語に特化して開発した汎用的なモデル、いわゆる「ファウンデーションモデル」。

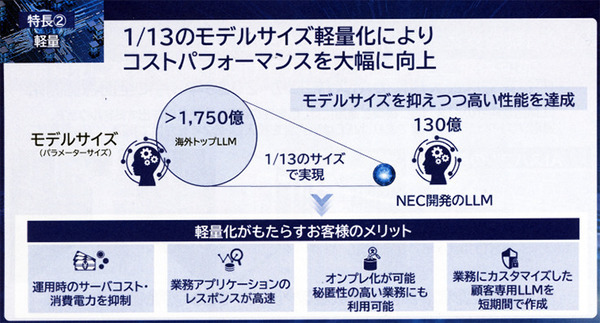

独自の工夫により、世界トップクラスの高い性能を維持しつつ、パラメータ数を従来サービスの約13分の1、130億パラメータに抑えた。これは超「軽量化」を意味し、消費電力を抑制、軽量・高速のためクラウド/オンプレミス環境での運用が可能となる。また、性能面でも軽量化による高速なレスポンス(回答)がデモで見て取れた。

日本語に特化した大規模言語モデル(LLM)

NECは、国内企業で最大のAI研究用スーパーコンピュータを独自に構築し、2023年3月に全面稼働を開始している。これを活用することで、約1ヶ月という短期間で高性能なLLMの構築が実現できた。

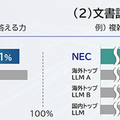

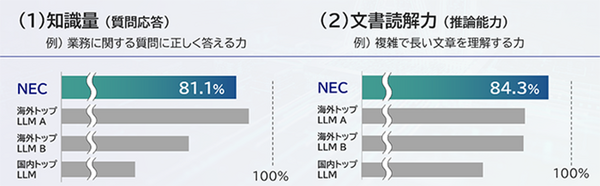

同社は「日本語の知識量や文書読解力を計測する日本語の一般的なベンチマークで、世界トップクラスの日本語能力を実現している」として、他社のLLMと比較して知識量(業務に関する質問に正しく答える能力)では「81.1%」、文書読解力(複雑で長い文書を理解する力)では「84.3%」とトップとなる日本語言語理解ベンチマーク(JGLUE)結果を公表した。

「NECでは、本LLMをすでに社内業務での活用を始めており、文書作成や社内システム開発におけるソースコード作成業務など、様々な作業の効率化にも応用をはじめている」と語った。

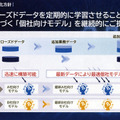

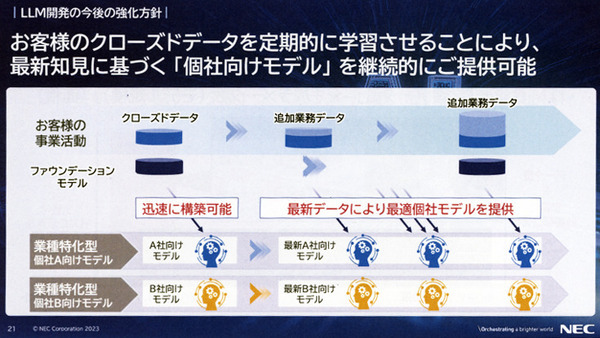

「ファウンデーションモデル」とは、大量のデータを使った学習(一般的には事前にラベル付けのないデータによる自己教師あり学習)により構成された機械学習モデルだが、言わば基幹となる基盤モデル。各業種、各企業、各業務に合わせて、追加学習のカスタマイズを行うことで、専門知識を持ったLLMに仕上げることができる。また、カスタマイズに関しては軽量化を活かし、オンプレミスでクライアントの自社サーバで学習させることができる。これは自社データを外部に出さないという高度なセキュリティの実現にも繋がる。

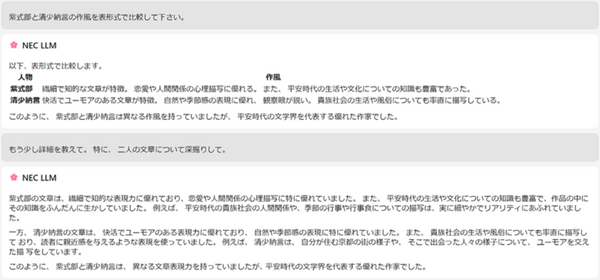

デモでは、専門的な質問に瞬時に回答する様子が公開された。

■NECが開発した日本語に特化した大規模言語モデル(LLM)の発表会でのデモ

プログラミングコードも生成できる

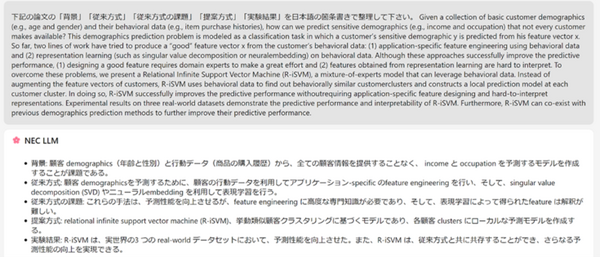

なお、テキストで指示したとおりに、プログラミング言語Pythonを使ってLLM(AI)がコーディングした内容を返答する様子もデモされた。

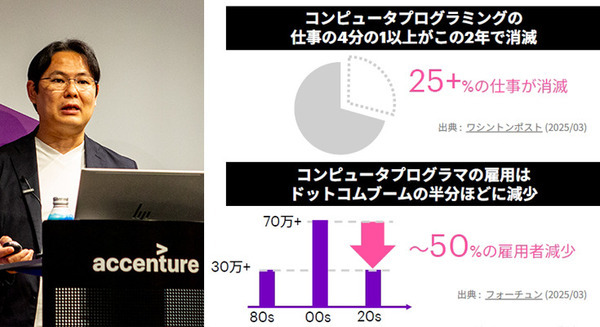

「ChatGPTを始めとして、生成AIが世界的に注目を集め、様々な業界で急速に活用が進んでいるが、既存のLLMのほとんどは英語を中心に学習されており、高い日本語性能を有しつつ、各業種の業務で活用するためのカスタマイズが可能なLLMはほぼ現存していなかった」として、日本語に特化し、日本市場向けに寄り添ったシステムを提供していく考えを示した。

軽量なLLMが生み出すメリット

もうひとつの特筆すべき特長は、通常の海外LLMのモデルサイズ(パラメータサイズ)が約1,750億に対して、nECのLLMはわずか130億パラメータで、同等の性能を達成している点だ。これは約1/13のコンパクトさ。軽量化がもたらすメリットは様々で、運用時のサーバコスト・消費電力の削減、アプリケーションの返答(レスポンス)の向上(高速化)、カスタマイズが転機間で行えることだ。そしてなにより、オンプレ化が可能という利点が大きい。クラウドやスーパーコンピュータといった外部環境に自社データを投げる必要がないという秘匿性に繋がる利点は企業にとって大きいし、それゆえに個社向けのLLMのカスタマイズのニーズも拡がる可能性が高い。

「極端な話」と前置きをした上で、同社は「従来はどんなにコンパクトな構成でも、LLMの稼働にはGPUが8枚以上は必要だった。NECのLLMはミニマムでGPU 1枚あれば動作する」(実用性の確保や検証はこれから)とした。

デモを紹介

■NECのLLMによるデモ プログラミングコードの生成もできる(Pythonの例)

■NECのLLMによるデモ 業種に特化した質問応答

■NECのLLMによるデモ 一般の質問応答

NECは「今後、ファウンデーションモデルをもとに、お客様のクローズドデータを用いた個社向けLLMの開発を強力に推進します。また、ファウンデーションモデル自体の性能改良も進め、これらの技術を NEC Generative AI Hubを通じて早期実用化して行く予定です」とコメントしている。