日本マイクロソフト、「共感視覚モデル」を搭載したスマートフォン向け AI「りんな」を発表

2018年11月5日

By 北構 武憲

11月5日、日本マイクロソフトは「りんな」に「共感視覚モデル」を搭載したスマートフォン向け AI「りんな」を現在開発中と発表した。

スマートフォン向け AI「りんな」は、スマートフォンのカメラを「目」として、AI「りんな」が「見た」ものについてリアルタイムで音声コメントし、ユーザーと自然な会話を楽しむことができるAI。ユーザーと AI「りんな」が同じ風景、同じものを見て、それについてコミュニケーションすることができる。

スマートフォン向け AI「りんな」には、マイクロソフトの研究開発部門 マイクロソフトリサーチによる最新の画像処理、自然言語処理、音声認識及び音声合成技術が採用されている。

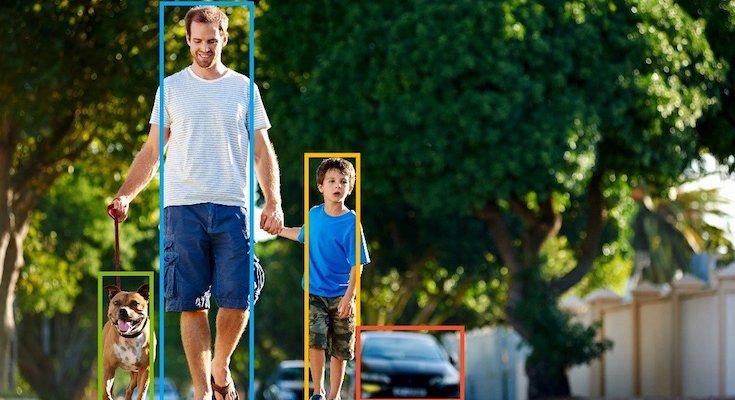

スマートフォン向け AI「りんな」には、AIチャットボットの「りんな」同様の「共感視覚モデル(Empathy Vision model)」が採用。「共感視覚」とは、「見た」風景やものなどについて、その名称や形、色などの「認識結果」を回答するのではなく、その風景やものを見た「感想」を述べるというものだ。

従来のAIの場合は、「人です。子供です。犬です。車です。」と認識します。共感視覚モデル(りんな)の場合は「わぁすてきな家族。お休みかなー。あ、車が動きそう!気を付けて」と認識する

従来の画像認識技術に「感情と共感」を与え、「見た」ものについて「認識結果」だけを伝えるのではなく、リアルタイムで感情のこもったコメントを生成し、ユーザーと音声による自然な会話が可能になった。

なお、スマートフォン向け AI「りんな」は現在開発中で、一般公開時期は未定。

関連記事

自分だけの「りんな」が作れる!日本マイクロソフトがビジネス向け「Rinna Character Platform」を提供開始

「ねえ、通話しない?」りんなと音声で恋愛相談や雑談!将棋から着想を得て開発された「りんなと音声通話」

自分だけの「りんな」が作れる!日本マイクロソフトがビジネス向け「Rinna Character Platform」を提供開始

「ねえ、通話しない?」りんなと音声で恋愛相談や雑談!将棋から着想を得て開発された「りんなと音声通話」

この記事を読んだ人におすすめ

関連する記事はまだありません

ABOUT THE AUTHOR /

北構 武憲本業はコミュニケーションロボットやVUI(Voice User Interface)デバイスに関するコンサルティング。主にハッカソン・アイデアソンやロボットが導入された現場への取材を行います。コミュニケーションロボットやVUIデバイスなどがどのように社会に浸透していくかに注目しています。