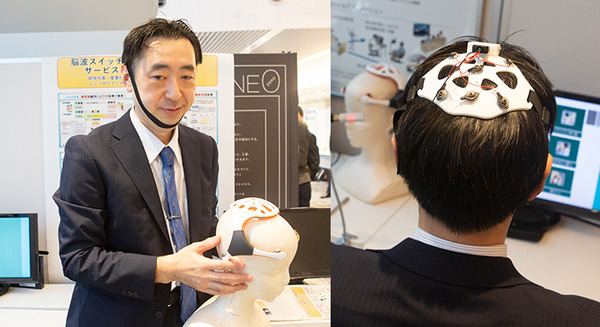

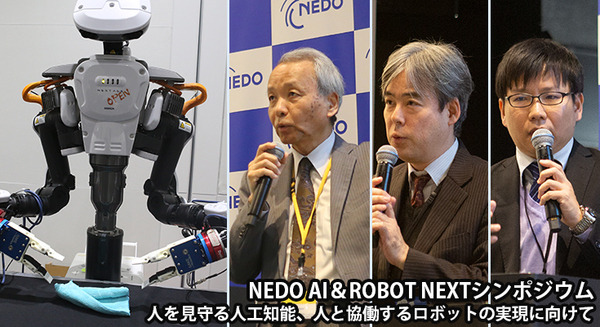

「NEDO AI&ROBO NEXT シンポジウム ~人を見守る人工知能、人と協働するロボットの実現に向けて~」において、「きめ細かい動作認識の研究開発」というテーマで千葉工大の竹内彰一氏が登壇した。この研究は実に興味深い内容だった。

(※冒頭の写真 千葉工業大学 人工知能・ソフトウェア技術研究センター 主席研究員 竹内彰一氏)

お母さんが子どもを抱っこして部屋から出ていく動画

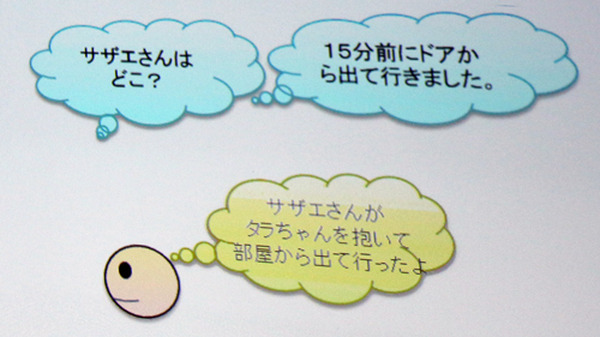

まず短い動画が再生される。女性が子どもを抱っこして部屋の外へ出ていくだけの動画が流れた。

この映像からAIは「サザエさんがタラちゃんを抱いて部屋から出て行った」ことを解析する。

そこで誰かがAIに「サザエさんはどこ?」と質問したとする。AIは「15分前にドアから出ていきました」と答える。

続けて誰かが「一人で?」と質問すると、AIは「タラちゃんと一緒でした」と答える。

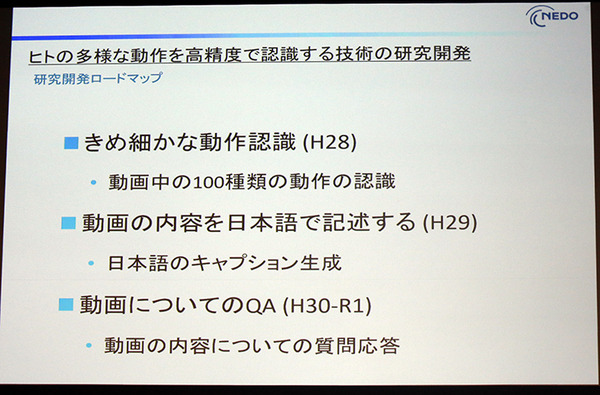

千葉工大は「きめ細かい動作認識の研究開発」のひとつとして、このような研究をしているという。実用的な記憶と会話技術の融合がとても面白いと感じた。深層学習のトレーニングやすさまじいデータセットの話を聞くと、さらに興味が深まった。

AIが見たシーンを言葉で説明して回答する技術

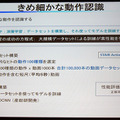

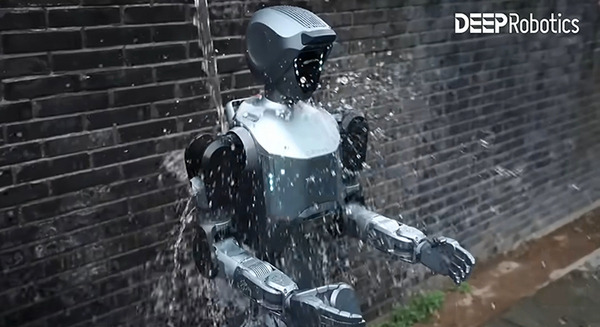

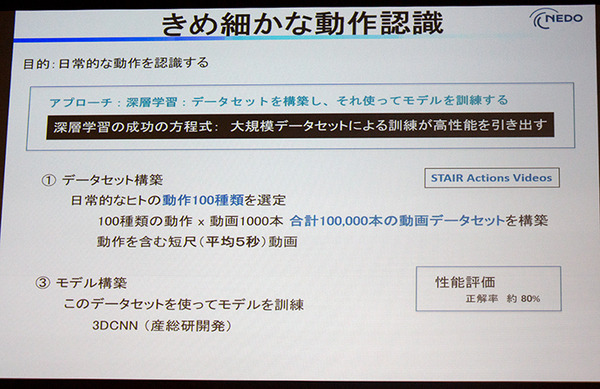

これは、AIが見てきたものを言葉で説明して返す技術。深層学習でトレーニングしたAIに対してたくさんの動画を見せて、なんの動作だったかを説明させるというもの。

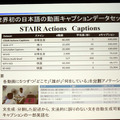

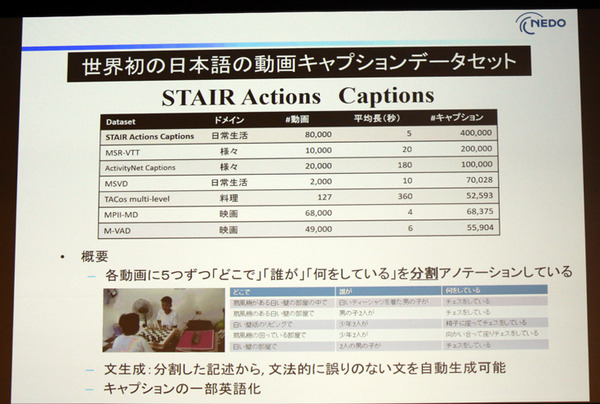

具体的な方法は、深層学習用の動画とラベル付けをしたデータセットを構築する。家庭内の日常動作に限定し、握手する、皿を磨く、歯を磨くなど、100種類のの動作シーンについて、それぞれ1000本の動画を用意した「STAIR Actions Videos」というライブラリを用意した。合計10万本ある動画のうち、8万本の各動画に、それぞれ5つずつ「どこで」「誰が」「何をしている」といういわば分割したラベル付けを行い、アノテーションを行ったデータセットとしては、40万本の動画を用意した例は他にはないという(大学プレスセンターの発表(プレスリリース))。

そのデータセットを使ってAIモデルをトレーニングした。産総研で開発した動作認識に適する3D-CNN 深層学習モデルを使って実証した結果、80%程度の正解率で回答するレベルに達したという。

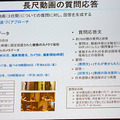

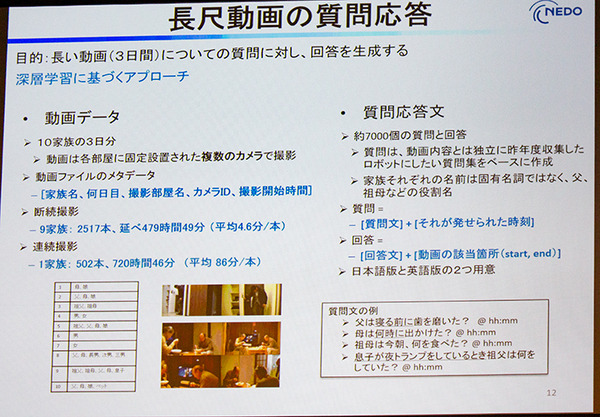

10家族、3日分の長尺動画

また、現在は長尺動画の解析にも着手しているという。このデータがまたすごい。3日間の生活を録画した動画を10家族分、複数のカメラで撮影したものを用意した(ただし、連続で撮影し続けたのは1家族で、ほかの9家族は部屋に人がいる時間のみ録画した)。

これを解析すると何が起こるのか。

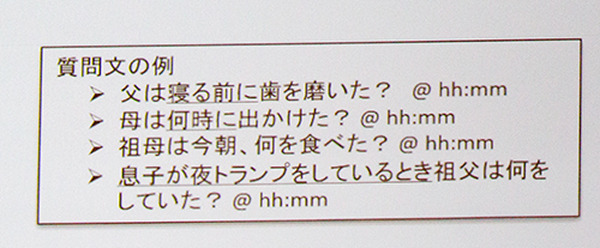

「父は寝る前に歯を磨いた?」という質問に対して、AIは現在の時間軸に最も近い父親の寝る前の動画のデータを確認し、歯を磨いたかどうかを回答する。

更には「息子が夜トランプをしているとき、おじいちゃんは何をしていた?」という質問にAIが回答できるようになるという。その場合は、息子が夜トランプをしている時間を動画データから解析し、別の部屋にいるおじいちゃんの同じ時間の行動を解析して回答するという複雑なプロセスが行われることになる。

セキュリティカメラの画像をAIが解析する技術が盛んに研究され、精度が向上しているが、さらにその先にはこのように様々な場所と状況、人の動きをAIがに質問すると回答してくれる、そんな未来がやってくるかもしれない。もちろん、プライバシーの問題はついて回るものの、ルールや原則を厳重に設けることで、とても面白い技術に発展するように感じた。

なお、データセットは公開されている。

STAIR Actions Videos