NVIDIAは7月19日、生成AI(ジェネレーティブAI)に関する報道関係者向け説明会を開催した。「生成AIと従来の AIの違い」や「生成AI活用に着手している企業」「生成AI開発の課題」などを説明した後、NVIDIAがクラウドで提供している生成AI関連のソリューションやクラウドパートナー、導入事例等を紹介した。

なお、NVIDIAは「生成AI Day 2023 Summer」を2023年7月28日開催する。画像生成AIや大規模言語モデルの最新情報や活用方法を解説する(基調講演は既に満席)。

生成AIと従来のAIとの違い、生成AIが影響を与えるビジネス分野

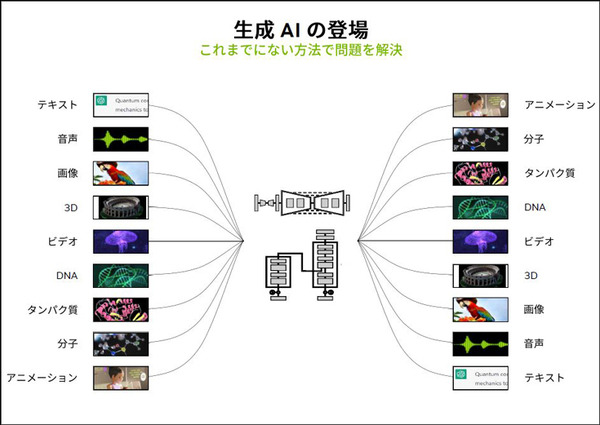

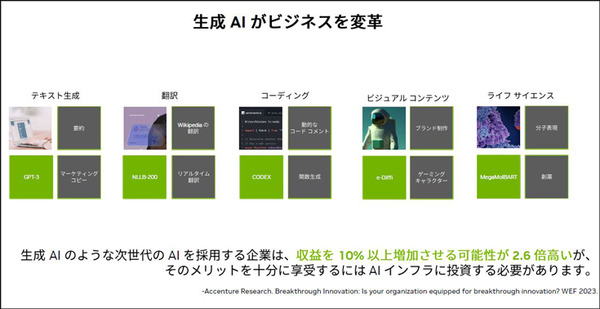

登壇したエヌビディア合同会社のテクニカルマーケティングマネージャー澤井理紀氏は、現在、生成AIが世界中で話題となっていて、その影響はチャットボットや音声対話応答だけでなく、様々な分野に及んでいることを紹介した。

特にChatGPTで話題になった「テキスト生成」では、チャットボットで自然な対話をしたり、ニュースや論文を要約したり、キャッチコピーなどの生成を行うことができる。また、翻訳をしたり、様々なプログラミングコードの生成、絵画の描画やゲームキュラクターの生成、ライフサイエンスの分野でも運用が始まっている。

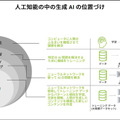

AI分野での生成AIの位置付け

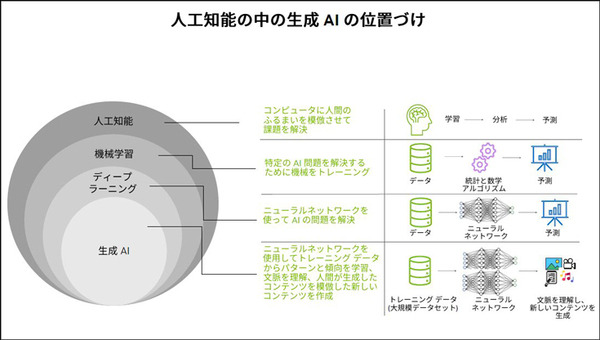

澤井氏は続いて、生成AIがAI全体の中ではどのような位置付けにあるかを図でしました。「人工知能」全体のカテゴリーの中では、コンピュータが学習することによって何かを判別したり、推論して判断を支援する「機械学習」、それをディープニューラルネットワーク(DNN)を使って行う「ディープラーニング」があり、ディープラーニングがこの10年でAIの進化をもたらした。そこに大きく貢献しているのがNVIDIAのGPUであることは周知のとおりだ。そのブレイクスルーを更に推し進めたのが「生成AI」だ。

「生成AI」の進化のベースとなっている技術に「Transformer」(トランスフォーマー)がある。Transformerとは入力部分の各部分の重要度を差分的に重み付けする「セルフアテンションメカニズム」というしくみを採用したディープラーニングモデルのこと。エンコーダーは言語の構成を理解し、デコーダーで言語を生成する、AIの新たな波となった。

生成AIの課題

ビジネスへの活用が急速に進む生成AIだが、従来のAIと比較してメリットと同時に大きな課題もいくつかある。メリットとデメリットは立場(視点)によって異なるが、NVIDIAを含めてモデルを開発するエンジニアやデータサイエンティスト視点から見ると、メリットは学習データのラベル付けが不要であること、多くのタスクをこなせる可能性があることが挙げられるが、なんといってもパラメーターが膨大になることが課題としてのしかかってくる。しかし、並列処理ができるという利点もあり、膨大な計算資源を投入できれば、チカラヅクで開発期間を縮める可能性もあることを示唆している。

ChatGPTの場合、10,000基のNVIDIA GPUのスケーラリビティを活用

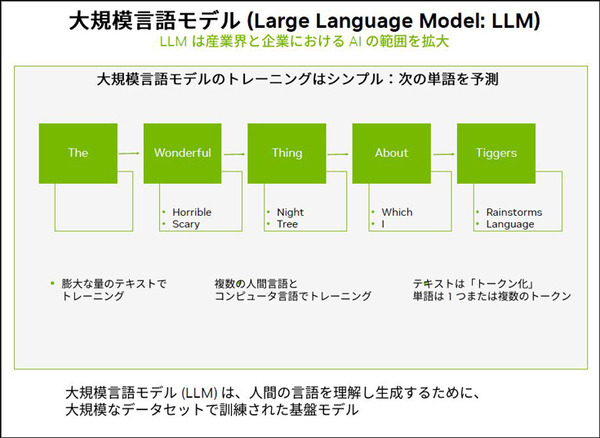

澤井氏は「生成AIのひとつである”大規模言語モデル”は従来のAIのようなラベル付けは不要だが、従来のAIのパラメータが数億に対して、大規模言語モデルでは数十億から数兆が必要」とした。

一方で並列処理が可能で、GPUの高速性を活かして並列で学習を行うことを解説した。同氏によれば、ChatGPTの場合、10,000基のNVIDIA GPUのスケーラリビティを活用して、数週間でトレーニングが行われた、とした。

「H100」はトランスフォーマーエンジン搭載

さて、ここからは生成AIにおけるNVIDIA GPUの優位性の話になる。

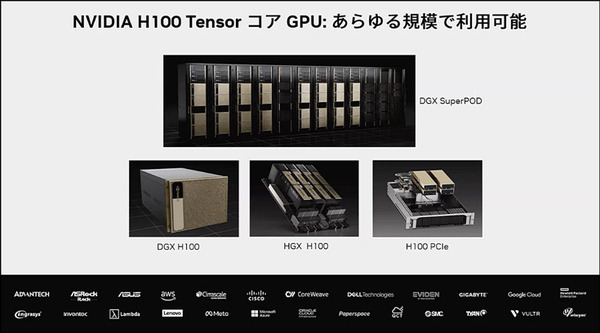

解説してきたように、生成AIの膨大なパラメータには膨大なGPU能力が必要であり、それに適しているGPUが最新モデルの「H100」テンソルコアGPUとなる。その理由は「H100」には生成AIを支えるトランスフォーマーを高速に処理するためのトランスフォーマーエンジンが搭載されているためだ。

また、NVIDIAの他のシリーズと同様、「H100」はPCIエクスプレス用の拡張ボードユニットからオンプレミスのサーバ、スーパーコンピュータまで、幅広く活用できるラインナップとそれを支えるソフトウェアが用意されている。生成AIが活気づいた市場に対応する性能をいち早く取り入れている。ただ、需要も膨大なため、現在はフル生産の体制を取って供給対応が行われているという。

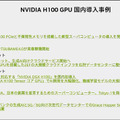

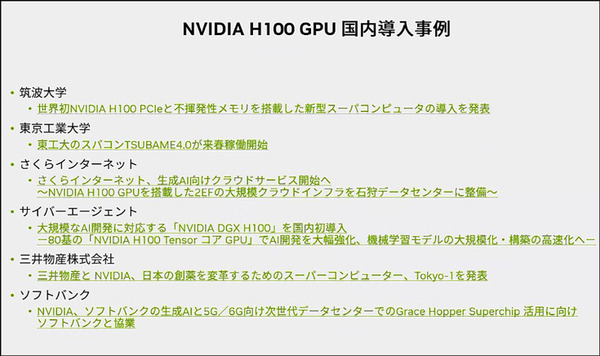

「NVIDIA H100」導入事例

「NVIDIA H100」には既に導入事例もあり、澤井氏はプレスリリースされている6つの組織(筑波大、東工大、さくらインターネット、サイバーエージェント、三井物産、ソフトバンク)に採用されていることを紹介した。

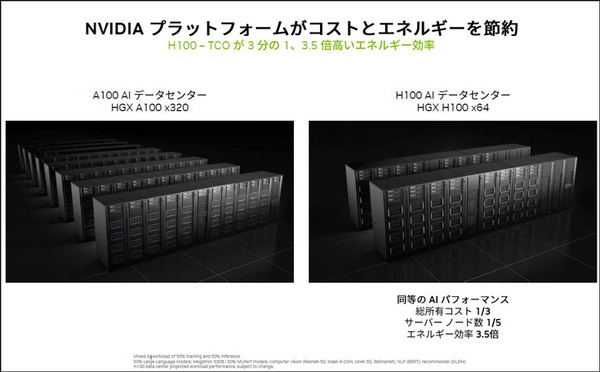

前モデル「A100」と「H100」の性能比較

また、「H100」を前モデルGPU「A100」と比較した性能比較も紹介した。

HGX A100 320基と同等の性能を「H100」では64基で実現でき、その結果、所有コストは1/3、サーバノード数は1/5、エネルギー効率は3.5倍を達成するという。

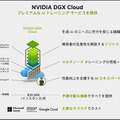

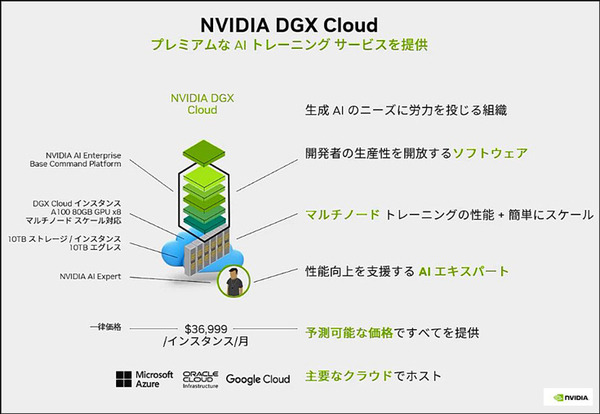

「H100」の技術をクラウドで提供

また「NVIDIA DGX Cloud」(GPUを8基搭載)として、Microsoft Azure、オラクルクラウド、Googleクラウドからの提供も行われる。「NVIDIA DGX Cloud」では生成AIに必要なソフトウェアも同時に提供され、複数のインスタンスを使用して超高速に処理することができる。

なお、従来どおり、NVIDIAは生成についてもディベロッパーが開発しやすいように、各種ソフトウェア関連の提供も前述のクラウドサービスで具体的に行っている。

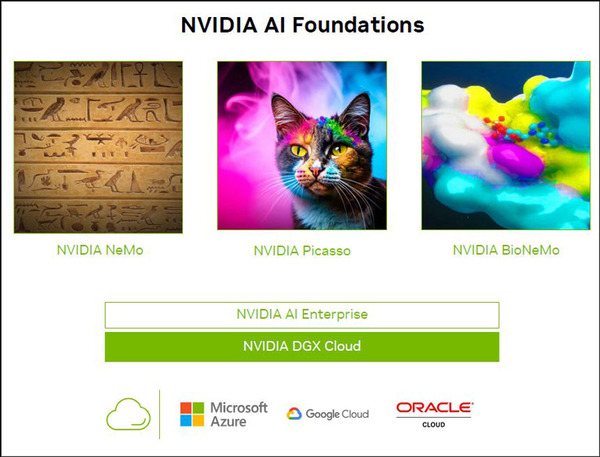

大規模言語モデルに「NVIDIA NEMO」(パーソナライゼーションが可能)、画像/ビデオ/3D生成アプリケーションのための「NVIDIA Picasso」(Text-to-Image/Text-to-Video/Text-to-3D)、創薬向け生成AIのカスタマイズと運用のためのクラウドサービス「NVIDIA BioNeMo」だ。

それぞれのソリューションについては、機械があれば詳細を解説したいと思うが、ビジネス活用できそうと感じるエンジニアはNVIDIAの公式ページや各クラウドサービス等の情報を調べてみねとよいだろう。