NVIDIA NIMで「DeepSeek-R1」が利用可能になった。NVIDIAは、「DeepSeek-R1」とその「リーズニング」機能や「テストタイムスケーリング」に言及、6,710億パラメータのDeepSeek-R1モデルをNIMプレビュー版として提供開始したことを発表した。

AIと「リーズニング機能」

「DeepSeek-R1」は、最先端の「リーズニング機能」を備えたオープンモデルだ。「リーズニング」とは情報や事実を基にして結論を導き出すプロセスや手法のことで、大規模言語モデル(LLM)の重要な機能のひとつとしても注目が高まっている。

その「リーズニングモデル」は、直接的な応答を提供するのではなく、1つのクエリに対して複数の推論パスを実行し、思考の連鎖、コンセンサス、および検索方法を実行して最適な回答を生成するもの。

中国のスタートアップ企業 DeepSeek(2023年7月に設立)が開発した高性能な大規模言語モデル(LLM)。リリースされたばかりで、今後更に詳細と評価が出ると思われるが、現状での特徴は下記の通り。

・高性能 「OpenAI o1」に匹敵する性能と高度な処理能力がある。

・低コスト 他の高性能AIモデルと比較して低いコストで開発・提供されている。

・日本語対応 日本語を含む複数の言語での対応が可能。

・オープンソース ローカル環境で動作が可能。

・商用利用可能 商用利用も認められている。

・コンパクトモデル 小規模版も提供されていて、個人の環境でも動作できる。

「テストタイムスケーリング」とは

この一連の推論パスを実行すること、つまり、推論を用いて最適な回答に到達するため、モデルの推論時にスケール(拡張や縮小)を適用する手法を「テストタイムスケーリング」(Test-time Scaling)と呼ぶ。

「DeepSeek-R1」はこのテストタイムスケーリング則の絶好の例でもあり、エージェント型AI推論の要求に対してアクセラレーテッドコンピューティングが不可欠だという理由を示している。

大規模な推論の展開が必要に

モデルが問題を反復的に「思考」できるようになると、より多くの出力トークン(トークンとはテキストを意味のある最小単位に分割したもの)が作成され、生成サイクルが長くなるため、モデルの品質は継続的に向上すると言われている。

リアルタイム推論と、DeepSeek-R1などのリーズニングモデルからの応答の高品質化をどちらも実現するには、大量のテスト時の計算が不可欠であり、より大規模な推論の展開が必要になる。

NVIDIAは「R1は、論理推論、リーズニング、数学、コーディング、言語理解を必要とするタスクでトップクラスの精度を実現すると同時に、高い推論効率も実現している」という。

6,710億パラメータのDeepSeek-R1モデルをプレビュー版として提供

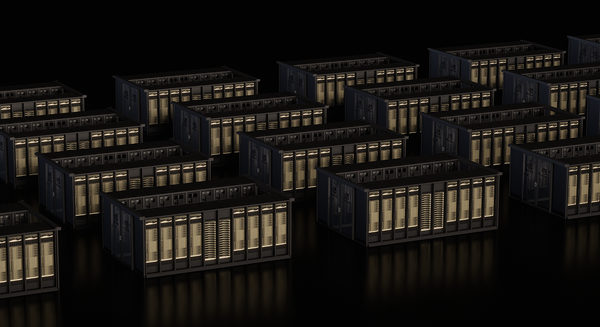

開発者がこれらの機能を安全に試行して独自の専用エージェントを構築できるように、6,710億パラメータのDeepSeek-R1モデルを現在、「build.nvidia.com」にてNVIDIA NIMマイクロサービスのプレビュー版として提供している。DeepSeek-R1 NIM マイクロサービスは、単一のNVIDIA HGX H200システムで最大3,872トークン/秒を生成できる。

開発者はアプリケーションプログラミングインターフェイス(API)使ってテストや試用を行うことができ、今後、NVIDIA AI Enterpriseソフトウェアプラットフォームの一部として、ダウンロード可能な NIM マイクロサービスが提供される予定だ。

DeepSeek-R1 NIMマイクロサービスは業界標準のAPIをサポートしているため、シンプルに展開が可能。企業は自社で選んだアクセラレーテッドコンピューティングインフラ上でNIMマイクロサービスを実行することで、セキュリティとデータ プライバシーを最大限に高めることができる。NVIDIA NeMoソフトウェアとNVIDIA AI Foundryを併用することで、企業は専門的なAIエージェント向けにカスタマイズされたDeepSeek-R1 NIMマイクロサービスを作成することも可能だ。

DeepSeek-R1 テストタイム スケーリングの絶好の例

DeepSeek-R1は、大規模なMixture of Experts(MoE)モデル。他の多くの一般的なオープンソースLLMの10倍にあたる、6,710億という驚異的なパラメータが組み込まれており、128,000トークンという大規模な入力コンテキスト長をサポートしている。また、このモデルではレイヤーごとに非常に多くのエキスパートが使用されている。R1の各レイヤーに256のエキスパートが含まれ、各トークンは評価のために 8 つの別々のエキスパートに並行して振り分けられている。

R1のリアルタイム回答には多数の高速GPUが必要

R1のリアルタイムの回答には、推論のためにすべてのエキスパートにプロンプトトークンを振り分けるための、高帯域幅かつ低遅延の通信で接続された高い演算性能を持つ多数のGPUが必要になる。

NVIDIA NIMマイクロサービスで提供されているソフトウェア最適化と共に使うことで、NVLinkとNVLink Switchを用いて接続された8基のH200 GPUを備えた単一のサーバーで、6,710億パラメータの「DeepSeek-R1モデル」全体を最大3,872トークン/秒で実行できる。

このスループットは、すべてのレイヤーでNVIDIA HopperアーキテクチャのFP8 Transformer Engineを使用し、MoEのエキスパートの通信に900GB/秒のNVLink帯域幅を使用することで実現する。

リアルタイム推論では、GPUの1秒あたりの浮動小数点演算(FLOPS)における最大限の性能を引き出すことが不可欠だ。次世代のNVIDIA Blackwellアーキテクチャは、最大20ペタフロップスのFP4ピーク演算性能を備えた第5世代 Tensorコアと推論用に特別に最適化された72GPU NVLinkドメインにより、DeepSeek-R1などのリーズニングモデルのテストタイム スケーリングに大幅な向上をもたらすだろう。

DeepSeek-R1 NIMマイクロサービスを今すぐ使ってみよう

開発者は、build.nvidia.com で現在提供中のDeepSeek-R1 NIM マイクロサービスを今すぐ体験できる。

また、NVIDIA NIMを使用することで、企業はDeepSeek-R1を簡単に展開でき、エージェント型AIシステムに必要な高い効率性を確保できる。

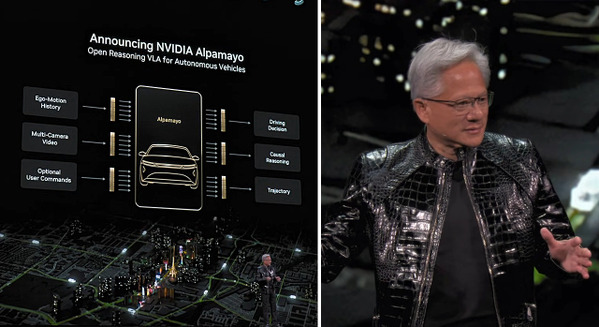

NVIDIAとトヨタが自動運転AI開発で連携 自動運転トラックでAurora、Continentalも連携追加 NVIDIAと連携する理由

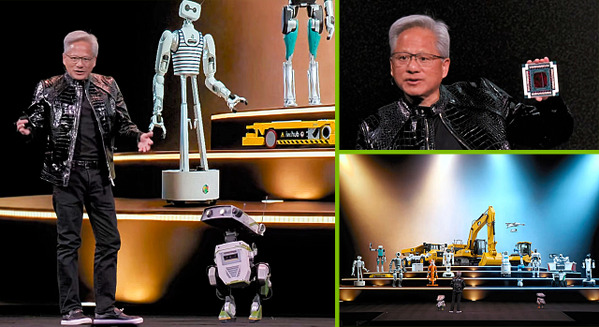

NVIDIAがデジタルツイン基盤「Omniverse」をロボティクス、自律走行車、ビジョンAIなどに拡張する生成AIモデルと「ブループリント」を発表

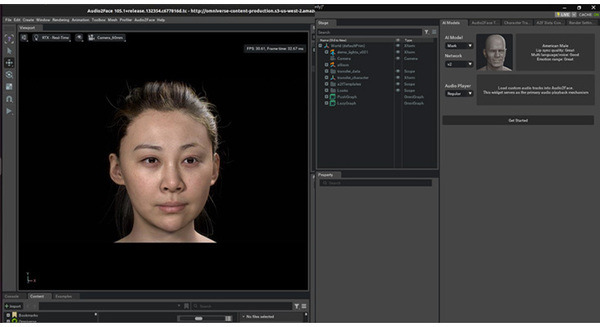

NVIDIA ACEで開発、AiHUBのデジタルヒューマン「Sali」 自然な発話と受け応えが魅力

ヘッドウォータースが「NVIDIA NIM ACE」で対話型AIデジタルヒューマンサービスを開始 生成AIやRAGも導入

NVIDIAがOpenUSDの機能をロボットや工業デザイン向けに大幅拡張 生成AIモデルやNIMマイクロサービスを発表