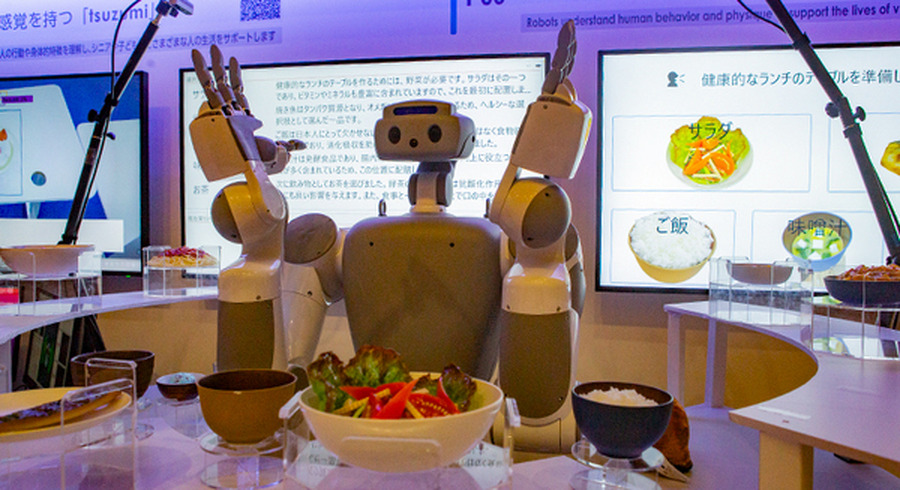

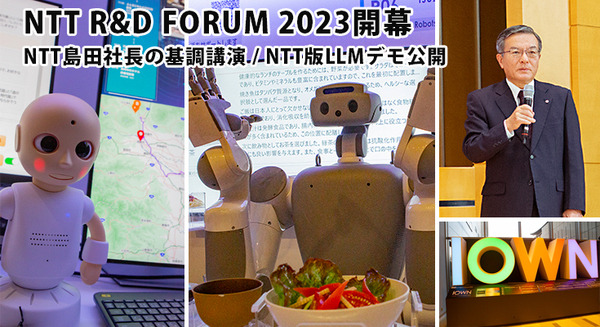

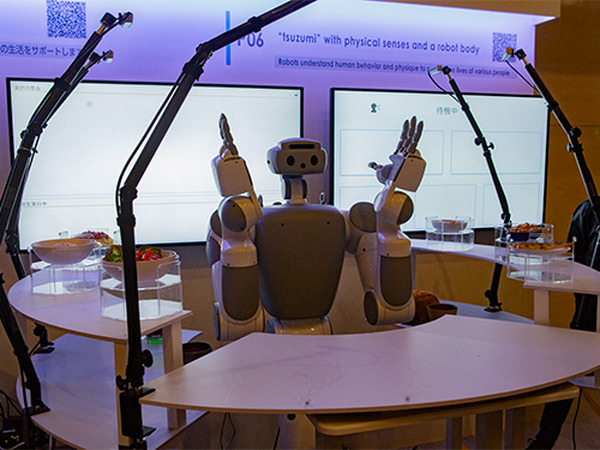

NTTは、現在開催中の「NTT R&D FORUM 2023 – IOWN ACCELERATION」(R&Dフォーラム)で、大規模言語モデル「tsuzumi」とロボットとの連携デモを公開した。テーマは大規模言語モデル「tsuzumi」を使って、身体感覚を持つロボットの物理的作業を制御すること。

食事として用意されたパスタや焼き魚、サラダ、アイスクリームなどが置かれた中で、人がロボットに対して「健康的なランチのテーブルを作って下さい」と音声で依頼すると、AIが依頼に合った献立を選び、最適な位置にテーブル配置してくれる。

「健康的なランチ」という曖昧なオーダーに対して、大規模言語モデル「tsuzumi」が理解して、並んでいる食事の要素を考慮して、最適なものを選択して、最適な置き方でテーブルに配置する。

なお、なぜ「tsuzumi」がそのメニューを選択したのかを、ロボットの音声や後ろのディスプレイに表示して明示してくれている。この作業はシステム的に作ったものではなく、LLMが生成しておこなっているという。食事の置き方(配置)も「tsuzumi」が生成して配慮している。

■「健康的なランチのテーブルを準備してください」

NTTの生成AI大規模言語モデル(LLM)「tsuzumi」驚きのデモ徹底公開! パワポの図表や写真、人物像まで理解するマルチモーダルLLMの実際

NTT版生成AI大規模言語モデル(LLM)「tsuzumi」驚異の性能を披露 NTT R&Dフォーラム2023開幕 NTT島田社長の基調講演と見どころ

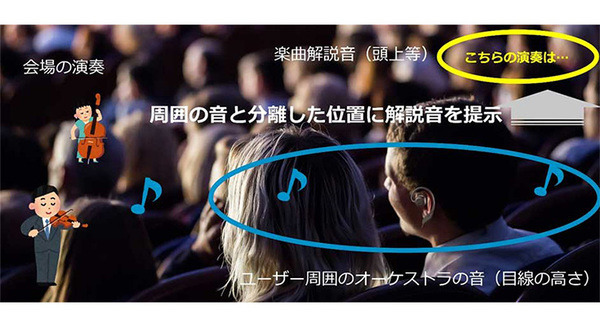

NTT オープインイヤー型音響デバイスが進化 必要な音がクリアに聞こえる技術を確立 耳元の音を空間的に制御

NTT わずかな筋の動作を操作命令につなげる入力インタフェースを開発 重度身体障がい者の脳信号や視線入力操作に活用

NTT R&Dフォーラム関連記事

NTT R&Dフォーラム2023