AIがさまざまな予測や判断を行い、人がその影響を受ける社会。

AIが下したその予測や判断は正しいのか?

人種やジェンダーの影響を受けていない公平、公正なものなのか。

AIによる偏見や差別を回避することは可能なのか。

2019年7月30日、第2回「ABEJA コロキアム」が「AIとバイアス、その在り処」というテーマで開催された。

登壇者は東京大学/理化学研究所/日本ディープラーニング協会理事などで活躍中の江間有沙氏、アーティストの長谷川愛氏、ABEJA Labsリサーチャーの白川達也氏の三人。

AIの普及とともに、採用や融資の判断、犯罪予測など、従来は人の勘や経験値に頼って意思決定していた領域において、AIに判断させる動きが加速している。一方で、AIのアルゴリズムに「バイアス」(偏り)はないのか、という問題提起や、バイアスのある判断結果がもたらす社会への影響も懸念されている。

今回は白川氏の講演にスポットをあてて、AIとバイアスについて解説する。

AIのバイアスとは

ABEJAは、AIの倫理・法・社会的課題を討議する有識者委員会 「Ethical Approach to AI」(EAA)を発足した(関連記事「ABEJAが「AIの法務・倫理」を議論する委員会「Ethical Approach to AI」(EAA)を設立 AIと差別、法律、倫理、個人情報保護など議論」)。

「バイアス」とは、解りやすいところでは「AIを開発する技術者の偏見によって、AIが偏った推論(判断)をしてしまう」こと。ひとつの例として、故意でなくても「AIの学習データとして用意したビッグデータが何かに偏った傾向にあることによって、AIが偏向した推論(判断)をしてしまうこと」等を言う。

AIのバイアスが招いた悪い事例

ABEJA Labsリサーチャーの白川達也氏は今まで実際にあった事例として、有名なMicrosofのTayのケースを掲げた。Microsoftが開発し、2016年にリリースしたAI会話ボットの「Tay」は、Twitterで誰かが発言した内容を学習していくシステム。誰でも教育できるという点があだとなり、悪意のある人物たちに差別用語や不適切な学習を施されてしまい、同社はわずか数日でTayのサービスを中止してアカウントを閉鎖した。

他にはGoogle Photosの例を紹介した。このサービスには投稿した写真をAIが解析して関連するタグを自動で付ける機能があるが、黒人の顔が写った写真に対してAIはゴリラのタグを付けてしまい、そのことに批判が集中したケースだ。

もうひとつ有名な事例が、Amazonの求人採用業務の履歴書チェックに使われているAIが女性を差別的に扱っていた事例だ。この原因は、AIが学習した際に使用した過去の履歴書データがそもそも男性のものが多いため、テクノロジー企業の採用は男性が多いというバイアスを反映してしまっていた、とされている。

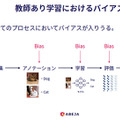

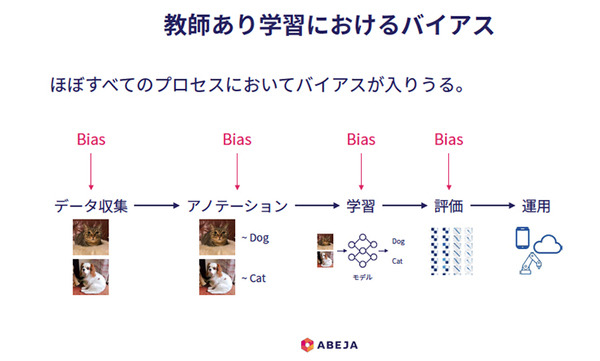

AI機械学習のすべてのプロセスにバイアスが入る可能性がある

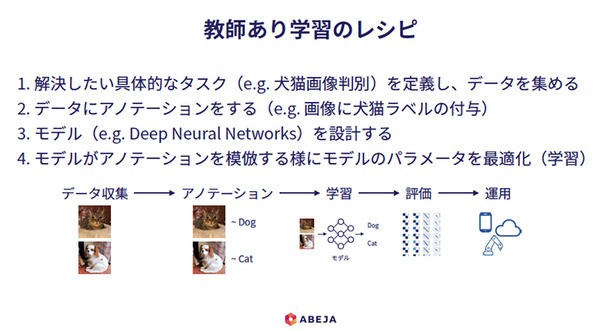

白川氏は典型的な「教師あり学習のレシピ」を紹介した上で、データ収集、アノテーション、学習、評価のプロセスでバイアスが入る可能性があることを指摘した。

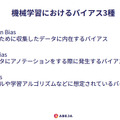

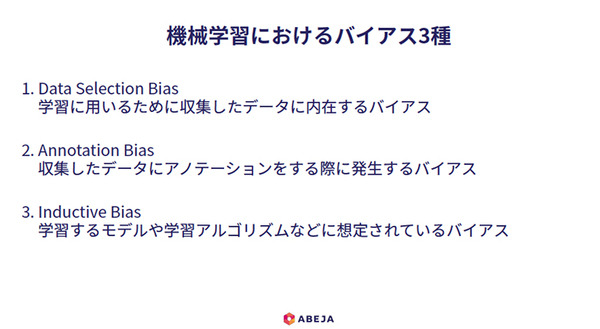

次に機械学習における多いバイアスを3種類あげた。データ収集時のバイアスは、AIを機械学習する際のビッグデータに偏りがあるために発生するもの。例えば従来、研究で使われてきたデータセットは西洋人の顔画像が多い(最近では中国人も多い)一方で、データセットの少ない人種は、AIの学習精度が低くなりがちだ。年齢別に言えば、20~40歳に分布が集中しているため、子供や高齢者に対する年齢推定の精度は低くなりがちだという。

データの偏りが解析の精度に及ぼす問題、というだけなら不公平や差別という方向には進まないと思うが、白川氏はこう続ける。

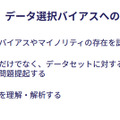

「AIはデータセットにないものは学習できないという大前提があり、人がデータセットを作りやすい対象をAIが優先してしまう構造を生み出しかねない。それはマジョリティが優先されやすい構造になる」。また、マイノリティにも注目したデータセットを組むべきという意見もあるが、マイノリティには存在そのものに気づくこと自体が難しく、気づけたとしてもマイノリティとなっているデータを相当量収集することは困難という側面もある。

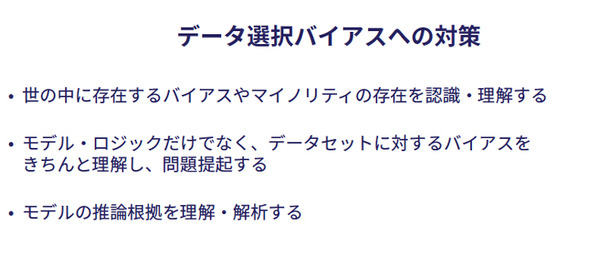

ここで重要となるのが、3番めの「モデルの推論根拠を理解・解析する」ことだと言う。

白川氏は「機械学習におけるバイアス問題の難しさ」に触れた。Deep Neural Networks(DNN)など一部のモデルは、推論プロセスがブラックボックスに近く、なぜその様な推論に達したのか、その理由を説明することが不可能な点に課題があると指摘する。DNNの推論プロセスを可視化し、解釈することを目指す研究、すなわちブラックボックス化させない方向の研究が進められている。その一方でディープラーニングのようにビッグデータで学習することを前提とした学習・推論手法は、説明可能性をむしろ放棄することで、精度の向上を達成している面(精度と解釈可能性のトレードオフ)があると言う。そのため、解釈可能性は原理的に、部分的にしか実現されないだろうと見る。

また、「解釈できたつもり問題」も存在するという。解釈できたつもりでも、より詳細な解析によってAIモデルが想定外のプロセスで推論を行っていることが発覚するケースもあるという。

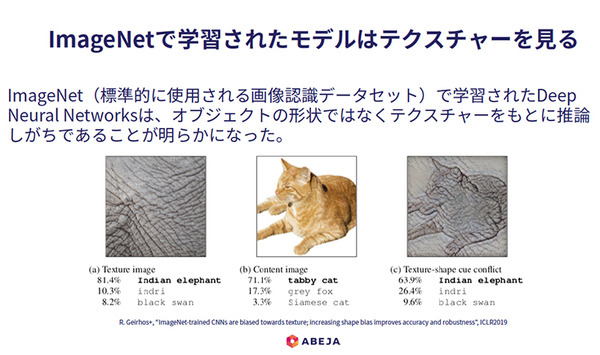

人間にとってAIの推論結果が理解できない事例として、白川氏は解りやすい話をあげた。

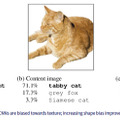

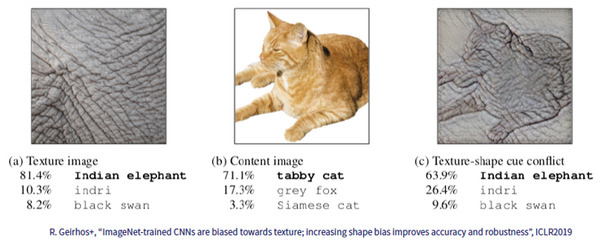

学術研究で標準的に使用される画像認識データセット「ImageNet」のデータを使って学習したDeep Neural Networksは、オブジェクトの形ではなくテクスチャー(素材感)をもとに推論しがちであることが明らかになったと言う。例えば、人間はネコかどうかを「形状」で判別しがちだ。下図の右の画像は像の皮膚のテクスチャー上に描かれた「ネコ」だ。これを「ImageNet」のデータセットで学習したAIは「像」と判定するという。

人間の判断基準や常識から言えば、形状よりテクスチャーを優先することに「想像すらできない」「あり得ない」と感じる人も多いだろう。白川氏は「DNNによってコンピュータが人間に近づいたことは事実だが、人間と同じ判断・推論をするとは限らない、人間の直感には反する結論を出すケースも多い」と指摘する。

白川氏はまとめとして、「AIの学習や推論にはバイアスが存在する可能性があること、その認知と理解が重要」だと言うこと、モデルやロジックに存在するバイアスの解析も重要だが、「データセットに存在するバイアスの解析も重要」であり、その点の認知を拡げていきたい、と語った。更に「判断根拠の提示可能性と精度のトレードオフの折り合い、それについての社会的理解と需要」についても触れた。白川氏は「DNNは鉄腕アトムのようなもの(人間と同様の見方をするの)ではなく、エイリアンのような(人間が想像できない変な推論を行う)もの」だということを理解しておくべきだ、と語った。

「AIの倫理」「AIとバイアス」については、ディープニューラルネットワークが進化する上で非常に重要なテーマであり、今後ますます重要性が増すことになるだろう。多くの議論や討論が交わされていくことになるだろう。注目していきたい。

ABEJA Labsリサーチャー。京都大学理学部卒業、同大学院理学研究科数理解析専攻中退。機械学習、Deep Learningを中心にシーズ技術の開拓や研究開発を行っている。最近は機械学習を通じた現象理解に興味があり、とくに人のこころを機械学習的に描いてみることでどんな理解ができるか模索中。