2024年1月24日から26日の日程で、東京ビッグサイトにて「第8回ロボデックス東京 ロボット開発・活用展」を含む「FACTORY INNOVATION Week 2024」が行われた。こちらではロボットの手先や指に注目したい。進展著しいAIの活用と合わせて、ロボットはもっと色々な作業ができるようになるだろう。

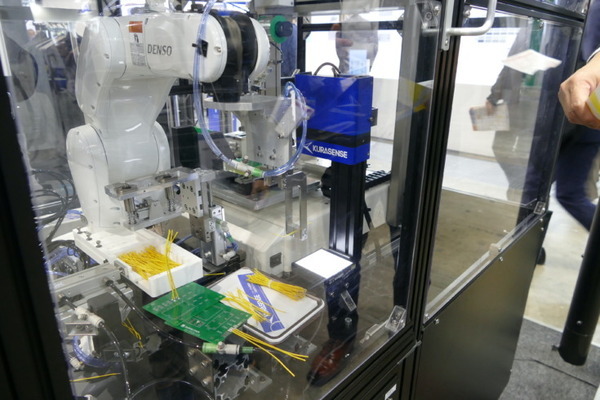

■クラボウ「クラセンス」を使ったケーブルのハンドリング

最近はロボットも、だいぶ器用になっていて、色々なものが扱えるようになっている。普及が進んできた3Dカメラを使って物体を正確に認識してハンドリングする方式が一般的だ。「FACTORY INNOVATION Week 2024」でも、クラボウが独自開発して販売しているビジョンセンサー「クラセンス」を使ってケーブルをピッキングする様子をデモしていた。

フニャフニャとかたちが変わるケーブル類は、扱いが難しい。いっぽう、自動車や電機製品の組み立てではケーブルの扱いは必須だ。クラセンスはそのために開発された高速3Dビジョンセンサーである。ねじれや奥行きも認識し、回転を補正できる。高速センシングなので揺れにも対応する。たとえば束から一本を取り出して挿入するような作業が可能だ。

人に頼るしかなかったケーブルの取り扱いやコネクタ挿入の自動化が可能になることから、「クラセンス」は2022年に第10回ロボット大賞「日本機械工業連合会会長賞」を受賞している。

2023年10月には新型も発売された。従来よりも認識精度や位置決め精度が向上している。より小さく細かいものを認識可能になった。「Kurasense-C100FX」はセンサーヘッドを分離できる小型版で、ロボットのハンドに直接つけることもできる(リリース)。クラボウではクラセンスを活用した、半田付けやワイヤーハーネス取り付けパッケージ製品も展開している。

このように、モノを扱いたければ、まずはしっかり見て、その座標をロボットに送ることができるビジョンセンサーを使うのが王道だ。

■ロボットが「手探り」できるようになるには

だが、3Dセンサーは値段が高い。また見えない場所もある。いっぽう人間が物体を扱うときのことを考えると、最初パッと一瞥するだけで、あとはほぼ見ておらず「手探りにお任せ」ということも少なくない。実のところ、指先と手のひらの感覚だけで扱っていることも多い。

その「手探り」をロボットでもなんとか実現できないかという考え方は以前からある。どんな方式をとるにせよ、次世代のロボットハンドには何らかのかたちで「触覚」のような感覚が必要なのではないか、という点については皆が同意するところだ。

「ロボデックス」でも3種類の「指」が出展されていたので、この機会にレポートしておきたい。

■位置と姿勢を非接触で把握し、簡単バラ積みピッキング可能 Thinker近接覚センサー

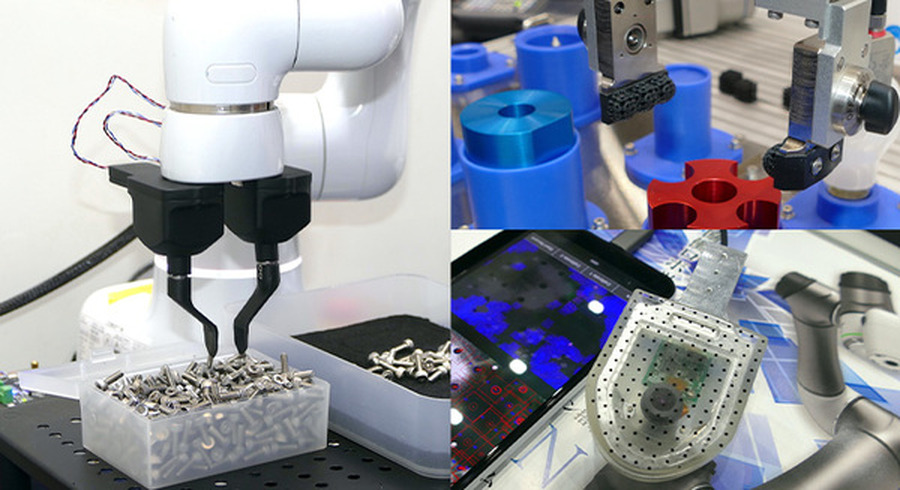

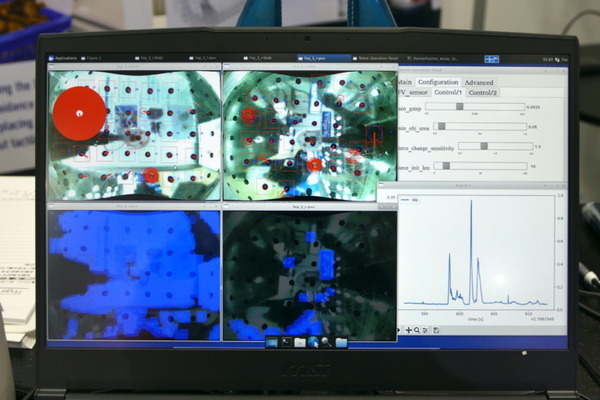

まず一つ目は、Thinkerのロボットハンド用近接覚センサーだ。Thinkerについては創業当初の2022年9月に本連載でも取り上げたが、カメラではなく赤外線を使ったセンサーで、距離だけではなく、対象の位置と姿勢を非接触で把握することができる。ロボットは掴みたいものに合わせて姿勢を変えることが簡単にできる。

この近接覚センサーと、素材ごとに異なる反射率を学習させた軽量のAIモデルを組み合わせることにより、距離と角度を検出し、ロボット制御に返す。ガラスや鏡など従来のロボットピッキングが苦手なものも扱えることができ、プログラミングコストも低減できる。「いわば反射神経的に少ない演算量でつかめている。中央のコントローラーの演算量を減らすことができる」という。

「Think Hand F」はその近接覚センサーを使った「フローティング機構搭載ロボットハンド」だ。バネを使ったフローティング機構で指が3次元的に動けることで「突き指」による故障を防止。その指の動きを内蔵の近接覚センサーで見ている。

すると、カメラなし、対象物(ネジなど)の姿勢がわからなくても手探りでのバラ積みピッキングができるようになる。つかみそこねても指の開きで検知してすぐにリトライする。

カメラで見ているわけではなく、ただ適当に指を突っ込んでいるだけなので、途中でワーク(作業対象物)を追加しても問題ない。位置がずれていてぶつかったりしても、衝突事故にならず、簡単にやり直せる。

逆に、取っているものが減ってくると、何もないところに指を入れることになる。全部取らせたい場合は、ワークを追加するカラクリなどと併用するか、簡単な二次元カメラを使って、どこにワークの山があるかを認識させることになる。

Thinker 取締役CTOの中野基輝氏は「ロボットの裾野を広げていく上でも、次世代のロボットハンドには必要なソリューションだと考えている。ハードウェアと組み合わせることで、ロボットハンド側で位置誤差を吸収し、考えさせることで、中央のコントローラの演算量を下げることができる。非常に堅牢で、人間がまさぐって取るような作業を、コストをあげずに実装できる」と語った。

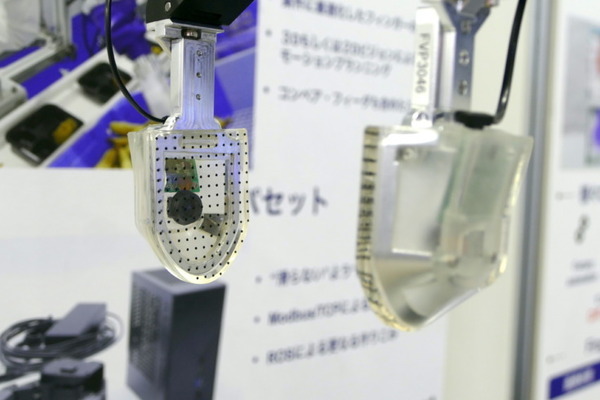

■力と滑りを画像で検出 「視触覚」センサーのFingerVision

いっぽう、独自の「視触覚」センサーを用いているのがFingerVisionのロボットハンドだ。シリコーン製の透明で柔軟な皮膚と、指先に仕込んだカメラを使って、触覚を再現する技術だ。花や食品のような、繊細な物体もそっと掴むことができる。

たとえば「FOOMA JAPAN 2023」では山善のブースでエビフライのピッキングをしていた。

特徴は、x, y, z各方向の力の分布だけでなく、滑りの分布なども検知できるところ。物体をつかんだあとに、対象が指先から滑っても、その滑りを検知して、掴みなおすといったことが簡単にできる。人間が行っているように、「指のどのあたりで持っているか」といったこともわかるという。

直接カメラで見ているのでハードウェア機構はシンプルで、そのぶん安くつく。耐久性については指先部分だけ交換すればすむ。

FingerVisionは2023年10月には追加の資金調達を行い、アメリカで開催された「CES2024」にもJ-Startupパビリオンに出展した。いまは主にサンプル出荷で、各社が社内で検証している段階だという。

FingerVIsion CRO(Chief Revenue Officer)の角谷雄一氏によれば「自動化できてないところの把持検証用に購入してもらえる方が多い。今はまだ量産モデルには対応できていない。これから作っていく段階だ。なるべく早くしたい」とのことだった。

■樹脂を使った「柔軟指」で対象の落下防止

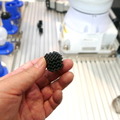

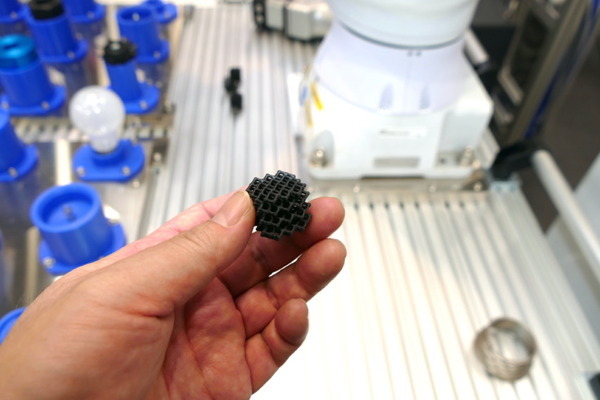

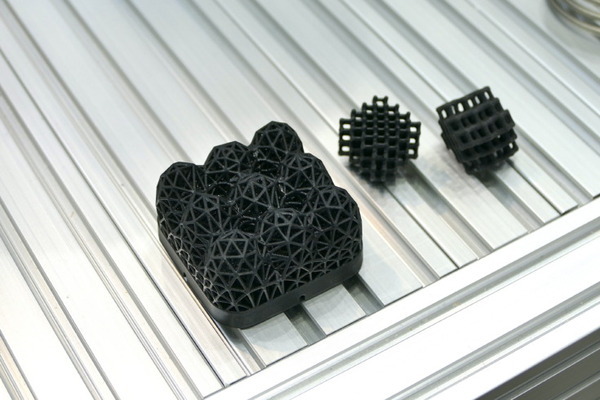

メーカー商社のリックスのブースでは、九州のロボットベンチャーKiQ Roboticsと共同研究開発した「柔軟指」が出展されていた。3Dプリンターで作られた樹脂製の指で、対象に合わせて変形するラティス(格子)構造とすることで柔軟性を持たせたものだ。

これをロボットの手先につけることで、様々なものを掴み損なうことなく掴めるようになる。ロボデックスでも電球や金属部品など、様々なものを一つの指で扱えることをデモしていた。

重量によってラティス構造にもいくつか違うタイプがあるが、一つでも色々なものがつかめるため、段取り替えの工数を減らすことができるとのこと。耐久性が気になるところだが、ゲルなどの柔軟素材と違って、素材そのものは強度があるものを使って構造で柔らかさを実現しているため、耐久性もあるという。

主に製造業を対象としている。実際に工場で使ったところ、つかみそこねが減り、ラインが止まる「チョコ停」がなくなったとのこと。単純な仕組みながら効果が高そうなので、今後の展開が楽しみな技術である。

■人による遠隔操作で複雑な動作も覚えられるロボット

さて、このように色々な「指」や「感覚」の研究開発が行われているのだが、そもそも、もっと頭がよければ、いまの硬くてあまり感覚や自由度のないロボットハードウェアでも色々なものを扱えるのではないか、という考え方もある。

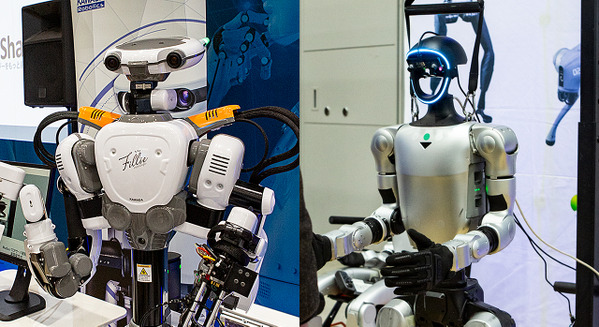

たとえば最近成果が公開された例のなかではGoogle DeepMindとスタンフォード大の「Mobile ALOHA」がわかりやすい。これは安価な両手遠隔操作システムの「ALOHA(A Low-cost Open-source Hardware System for Bimanual Teleoperation)」を動けるように改良したもので、様々な家事を遠隔操作で行い、学習させることができる。このロボットは特別なセンサー類などは使っていない。それでも様々なタスクが行えている。これは、コントローラーである人間のアタマのおかげだ。

遠隔操作したデータは、ロボットを器用にするためのAI学習用のデータに用いられる。動作をチャンク分けしてTransformerのエンコーダで表現して、接触が多い複雑な行動も行えるようになるという。

「Mobile ALOHA」は各タスクについて50回のデモを行った。既存の動かないタイプの「ALOHA」のデータを使ったデータと合わせて学習させることで、成功率90%で複雑なタスクができるようになったとされている。

もちろん、まだ失敗もする。

強化学習や大規模言語モデルの活用など、AIのロボットへの適用は今後もどんどん進む。AI活用にせよセンサー活用にせよ、やがて、もっと賢くて、器用で、複雑なタスクをこなせるロボットが登場することは間違いない。ロボットのパフォーマンスはさらに向上する。ただ、問題はそれがいつかということだ。