検証開始の経緯

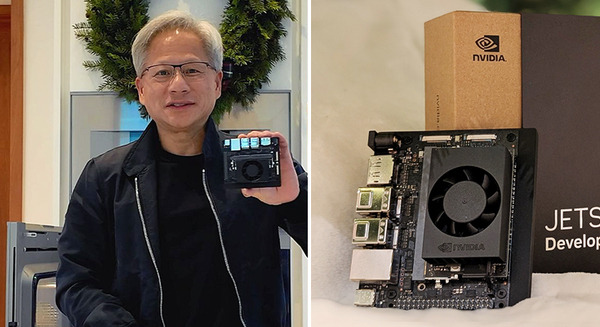

ヘッドウォータースでは、「Azure OpenAI Service」による企業向けGPTサービスラインナップの拡充を行っており、企業向けに生成AI、ならびにLLM(大規模言語モデル)と、RAG(Retrieval Augmented Generation)システム、伴走支援型ラボなど多くのソリューションを提供。また、NVIDIAとのコラボレーションによって、「NVIDIA Jetson」シリーズを活用したエッジAIソリューションの開発に取り組み、スマート化を推進する企業に対しても同様にソリューションを提供してきた。

そのような状況の中、同社が強みとしているエッジAI領域で、スマートストア、スマートファクトリー、スマートシティ、スマートモビリティを提供する顧客企業から「生成AIを使って、さらにスマート〇〇化を進められないか?」という相談が増えてきた。

そのような声に応えるため、生成AI×エッジAI領域の取り組み強化を目的に、日本マイクロソフトのSLM「Phi-2」と、Meta社の「LLaMA」をベースとしたオープンソースSLM「TinyLlama」、ならびにVLM「LLaVA」をNVIDIAの「NVIDIA Jetson Orin Nano」上で検証することによって、エッジAIと生成AIを組み合わせたビジネス活用方法の整理と活用拡大に向けたアーキテクチャーの確認を行っていく。

検証内容について

SLMの主な利点は、「LLM(大規模言語モデル)の軽量化」にある。通常LLMを運用するにはAIが膨大な量のデータを処理するために高価なコンピューティングリソースが必要になるため莫大なコストが必要となる。一方、SLMは小規模なデータ処理となるため、消費電力が少ないエッジデバイスのような小型コンピュータ上で言語モデルを稼働させることができ、さらにクラウドを経由せずローカル(オフライン)環境で言語モデルを扱える事から、セキュアでコスト効率も良いという特徴がある。

これらの特徴を最大限に発揮させるため、オープンソースのVLM「LLaVA」を「NVIDIA Jetson Orin Nano」で稼働できるように4ビット精度で量子化してメモリ使用量を削減させます。これによってパフォーマンスを向上させた「nanoVLM」「Live LLaVA」を活用でき、画像や映像、テキストを読み込むマルチモーダルな生成AIの稼働が可能となる。

検証を通して、

・自動車×生成AIによる「音声対話できる自動車」

・スマートファクトリーにおけるセキュリティを考慮したオンプレミス型生成AI

・音声によるロボティクスの機械制御

・スマートシティの都市OSデータを活用した生成AIによる案内

・スマートストアにおいて自動接客を行う生成AI

といったソリューションの展開を目論んでおり、このような事例で生成AI×エッジAI領域の言語モデルテクノロジーを活用していくとしている。

今後について

ヘッドウォータースでは、SLMやMiniVLMといった小型化された言語モデルは生成AIをあらゆるプラットフォームに適用させるために必要なテクノロジーであると考えており、今後は、生成AI×エッジ音声/画像解析、生成AI×オンプレミス、TinyGPT-V利用やモバイルVLM推進、RAGシステムにSLMを活用する「ハイブリッドRAG」、Databricksのデータ連携、NVIDIA社の生成AIアプリマイクロサービス「NIM」に関するソリューション展開を図るとともに、顧客企業ともビジネスパートナーとなり共に生成AI経済圏を拡大する取り組みを行っていくとしている。

ヘッドウォータースとマクニカが協業 「NVIDIA Jetson」を利用した「エッジAI」の企画から運用までを包括的サポート

ヘッドウォータース、NVIDIA Jetsonに標準対応したエッジAIデバイス一元管理ソリューションを開発 スマートシティ推進を加速

rinna、Metaの大規模言語モデル「Llama 2」の日本語継続事前学習モデル「Youri 7B」を公開 Llama 2とYouri 7Bの特徴とまとめ

【Jetson Orin Nano レビュー(2)】Orin Nano対AGX Orin/AGX Xavierベンチマーク対決 実務でのAI演算能力でも実用性を測る!

NVIDIA「Jetson Orin Nano」のベンチマーク結果を公開 従来NanoやTX2 NXとの性能差は?「GTC 2022」レポート

【速報】NVIDIA「Jetson Orin Nano」を発表 従来Nanoの約80倍の高性能 超小型AIコンピュータ Orinファミリーは3機種に