フルスタックのNVIDIAアクセラレーテッドコンピューティングプラットフォームは、最新のMLPerf Training v4.0ベンチマークにおいて、再び卓越した性能を発揮した。

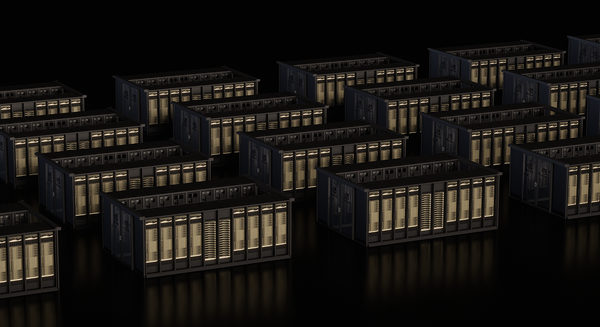

NVIDIAは、GPT-3 175Bに基づく大規模言語モデル(LLM)ベンチマークの性能を、昨年NVIDIAが提出した記録的なものと比較して3倍以上向上させた。NVIDIA Quantum-2 InfiniBandネットワーキングで接続された11,616基のNVIDIA H100 TensorコアGPUを搭載したAIスーパーコンピューターを使用して、NVIDIAは、1年前に提出した3,584基のH100GPUの3倍以上という大規模化と、広範なフルスタックエンジニアリングによって、今回のベンチマーク性能向上を達成した。

NVIDIA AIプラットフォームのスケーラビリティのおかげで、EosはGPT-3 175Bのような巨大なAIモデルをさらに高速にトレーニングできるようになり、この優れたAI性能は大きなビジネスチャンスにつながる。例えば、最近の決算発表の説明会では、LLMサービスプロバイダーが、NVIDIA HGX H200サーバー上でLlama 3 70Bモデルを稼働させることで、わずか4年間で投資した1ドルを7ドルに変えることができることを説明。このリターンは、LLMサービスプロバイダーがLlama 3 70Bを$0.60/M トークンで提供し、HGX H200サーバーのスループットが毎秒24,000 トークンの場合を想定している。

NVIDIA H200 GPUが生成AIとHPCを強化

NVIDIA H200 Tensor GPUは、Hopperアーキテクチャの強みを基盤としており、H100 GPUと比較して40%以上のメモリ帯域幅を持つ141GB のHBM3メモリを搭載している。AIトレーニングで可能なことの限界を押し広げるNVIDIA H200 TensorコアGPUは、MLPerf Trainingのデビューにおいて、H100のパフォーマンスを最大47% 向上させた。

NVIDIA ソフトウェアが比類なき性能の向上を実現

さらに、512基のH100 GPU搭載した構成を使用したNVIDIAの成果は、NVIDIAソフトウェアスタックへの多数の最適化により、わずか1年前と比較して最大27%高速化した。この改善は、継続的なソフトウェアの強化が、同じハードウェアであっても、いかにパフォーマンスを大幅に向上させることができるかを示している。

この作業はまた、ほぼ完璧なスケーリングも実現した。昨年の3,584基のH100 GPUから今回の提出で11,616基とGPUの数が3.2倍増加したため、提供されたパフォーマンスも向上した。

LLMファインチューニングに秀でる

企業が事前トレーニングされた大規模言語モデルをカスタマイズしようとする中で、LLMのチューニングは業界の重要な作業となっている。

MLPerfは今回、Meta Llama 2 70Bに適用された一般的なLoRA (Low-Rank Adaptation) テクノロジに基づく、新しいLLMチューニング ベンチマークを導入した。

NVIDIAプラットフォームは、このタスクで優れた性能を発揮し、8基から1,024基のGPUまでスケーリングし、NVIDIAが提出した最大規模のGPU は、記録的な1分半でベンチマークを完了した。

Stable DiffusionとGNNトレーニングの高速化

NVIDIAはまた、Stable Diffusion v2のトレーニング性能を、前回の提出と同じシステム規模で最大80%加速させた。

これらの進歩は、NVIDIAソフトウェアスタックに対する多数の機能強化を反映したものであり、ソフトウェアとハードウェアの改良が、いかにトップクラスの性能を実現するために効果的かを示している。

R-GATに基づく新しいグラフニューラルネットワーク(GNN)テストでは、H100 GPUを搭載したNVIDIAプラットフォームが、小規模でも大規模でも優れていた。H200は、シングルノードのGNNトレーニングにおいて、H100と比較して47%の向上を実現。これは、NVIDIA GPUの強力な性能と高効率を示すものであり、幅広いAIアプリケーションに最適である。

幅広いエコシステムのサポート

NVIDIA AIエコシステムの幅広さを反映して、ASUS、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Oracle、Quanta Cloud Technology、Supermicro、Sustainable Metal Cloudを含む10社のNVIDIAパートナーが結果を提出。このような幅広い参加と、各社の素晴らしいベンチマーク結果は、業界全体でNVIDIAのAIプラットフォームが広く採用され、信頼されていることを裏付けている。

AIコンピューティングにベンチマークのベストプラクティスをもたらすMLCommonsの継続的な活動は極めて重要である。AIとHPCプラットフォームの第三者による評価を受けた比較を可能にし、AIコンピューティングを特徴づける急速な変化に対応することで、MLCommonsは重要な購買決定の指針となる重要なデータをあらゆる企業に提供している。

また、NVIDIA Blackwellプラットフォームにより、トレーニングと推論の両方において、1兆パラメータの生成AIモデルにおける次世代レベルの AI性能が間もなく実現することも明らかにした。

生成AIやLLM、人型ロボットなど大規模演算に期待される「NVIDIA Blackwell」 従来比較で最小1/25のコストとエネルギー使用量

NVIDIA 大規模言語モデルと生成AIにも特化した「Blackwell プラットフォーム」とは 性能向上は最大30倍、コスト/エネルギー消費は最大1/25に

NVIDIA Grace Hopper SuperchipがMLPerf推論ベンチマークを席巻!H100 TensorコアGPUのトップクラス性能を証明

NVIDIA H100(Hopper)がMLPerfにデビュー、すべてのワークロード推論で世界記録を樹立、前世代GPU比で最大4.5倍のパフォーマンス