世界中の国々が、自国のコンピューティングインフラ、データ、労働力およびビジネスネットワークを使って人工知能を生み出す能力「ソブリンAI」を追求している。AIシステムをその地域に合わせた価値観、法律、興味関心に整合するものにブラッシュアップしている。

このような取り組みを支援するため、NVIDIAは2024年8月27日、開発者が高性能な生成AIアプリケーションの構築と展開を簡単に行えるようにする、4つの新しいNVIDIA NIMマイクロサービスを投入すると発表した。NIMマイクロサービスとは、生成AI推論に必要なソフトウエアやツール類がインストール済みのコンテナ。

新たに投入されるマイクロサービスは、地域のニーズを具体的に想定して作られており、主要なコミュニティモデルに対応している。これらのモデルは、現地の言語と文化遺産についての正確な理解と改善された対応力によって、ユーザーとの対話を向上させている。

開発者は高度なコパイロット、チャットボットおよびAIアシスタントを構築可能

ABI Researchによれば、アジア太平洋地域だけでも生成AIソフトウェアの売上は、今年の50億ドルから増加し、2030年までには480 億ドルに達するものと予想されている。

日本語データを基にしてトレーニングされたLlama-3-Swallow-70Bと標準中国語(マンダリン)を基にしてトレーニングされたLlama-3-Taiwan-70Bは、現地の法律、規制および他の習慣を深く理解しており地域の言語モデルとなっている。

「Rakuten AI 7B」は「Mistral-7B」を基に、英語と日本語のデータセットにより学習を行った一連のモデルだ。同大規模言語モデルのチャットモデルとインストラクションチューニング済みモデルが、それぞれのNIMマイクロサービスとして利用可能になっている。なお、「Rakuten AI 7B」の基盤モデルとインストラクションチューニング済みモデルは、「LM Evaluation Harness」の基準で2024年1月~3月に楽天内で評価を実施し、オープンな日本語大規模言語モデルにおいてトップの平均スコアを獲得した。

地域の言語で大規模言語モデル(LLM)のトレーニングを行うことによって、文化的および言語的に微妙な違いがよりよく理解され、それらが反映されるため、より正確でニュアンスのあるコミュニケーションが可能になり、アウトプットの効果が高まる。

これらのモデルは、Llama 3のような基本的なLLMと比較した場合、日本語と中国語の言語理解、地域の法的課題への対応、質疑応答、ならびに言語翻訳や要約において優れた性能を発揮する。

シンガポール、アラブ首長国連邦、韓国、スウェーデンから、フランス、イタリア、インドにいたる、世界中の国々が、ソブリンAIへの投資を行っている。

新しいNIMマイクロサービスにより、企業、政府機関および大学では、それぞれの環境でネイティブの LLM をホストできるようになり、開発者は高度なコパイロット、チャットボットおよび AI アシスタントを構築することができる。

ソブリンAI NIMマイクロサービスを使ったアプリケーション開発

開発者は、パフォーマンスを向上させながら、NIMマイクロサービスとしてパッケージ化されたソブリンAIモデルを本番環境に展開できる。

NVIDIA AI Enterpriseで利用可能なマイクロサービスは、NVIDIA TensorRT-LLMオープンソースライブラリによって推論に最適化されている。

新しいLlama–3-Swallow-70BとLlama-3-Taiwan-70B NIMのベースモデルとして使用されたLlama 3 70B向けのNIMマイクロサービスは、最大5倍のスループットを提供する。これにより、本番環境でモデルを実行する際の総費用が削減され、レイテンシの低下によってユーザー体験が向上する。

新しいNIMマイクロサービスは、2024年8月27日よりホステッドアプリケーションプログラミングインターフェース(API)として利用可能となっている。

NVIDIA NIMの利用により、より高速で正確な生成AIの成果を実現

NIMマイクロサービスは、展開の加速と全体的なパフォーマンの向上を実現し、さらにヘルスケア、金融、製造、教育および法務を含む、世界の多様な業界の組織に必要なセキュリティを提供する。

東京工業大学は、日本語データを使って、Llama-3-Swallow 70Bをファインチューニングした。

東京工業大学学術国際情報センターの横田理央教授は、

東京工業大学 学術国際情報センター 横田理央 教授

LMは、誰にでも同じ利益をもたらす機械的な道具ではありません。むしろ、人間の文化や創造性と相互作用する知的ツールなのです。その影響は相互的なものであり、モデルは我々が訓練するデータの影響を受けるだけでなく、我々の文化や我々が生成するデータもLLMの影響を受けることになります。従って、我々の文化的規範を遵守するソブリン AIモデルを開発することは最重要課題となります。NVIDIA NIMマイクロサービスとしてLlama-3-Swallowが利用可能になることで、開発者は様々な業界の日本のアプリケーションに簡単にアクセスしてモデルを展開できるようになります。

と述べている。

例えば、日本のAI企業であるPreferred Networksは、このモデルを使って日本語医療データの独自コーパスを用いてトレーニングされたヘルスケアに特化したモデル「Llama3-Preferred-MedSwallow-70B」を開発。このモデルは、日本の医師国家試験で高いスコアを達成している。

台湾有数の病院であるChang Gung Memorial Hospital(CGMH) は、カスタムメイドの AI 推論サービス(AIIS)を構築し、すべてのLLMアプリケーションを病院システム内で集約している。Llama 3-Taiwan 70Bを利用して、患者が理解しやすく、よりニュアンスの伝わる医療言語を使い、最前線の医療スタッフの効率性を高めている。

CGMH Linko の Center for Artificial Intelligence in Medicine でディレクターを務める、Changfu Ku医師は、

CGMH Linko Center for Artificial Intelligence in Medicine ディレクター Changfu Ku医師

現地語の LLM で構築された AI アプリケーションは、文脈にあった案内を即時に提供することで、ワークフローを合理化するだけでなく、スタッフの育成を支援し、患者ケアの品質を高める継続的な学習ツールとなっています。NVIDIA NIM はこれらアプリケーションの開発を簡素化し、地域の言語でトレーニングされたモデルを最小限の専門知識で簡単に利用および展開できるようにしています。

と話している。

台湾に本社を置く電子デバイス メーカーのPegatronは、社内外で利用されるアプリケーションに、Llama 3-Taiwan 70B NIMマイクロサービスを採用する予定だ。同社は、このマイクロサービスを自社のPEGAAi Agentic AI Systemに統合することでプロセスを自動化し、製造や運用の効率を大幅に高める。

Llama-3-Taiwan 70B NIMは、世界的な石油化学製品メーカーのChang Chun Group、世界トップクラスのプリント基板企業である Unimicron、技術系のメディア企業であるTechOrange、オンライン契約サービスを提供しているLegalSign.aiおよび生成AIのスタートアップであるAPMICでも利用されている。これらの企業は、オープンモデルでも協力している。

NVIDIA AI Foundryで、カスタムのエンタープライズモデルを作成

地域のAIモデルが文化的な機微のわかる、ローカライズされた対応を実現している一方で、エンタープライズは、自社のビジネス プロセスと専門知識に合わせるために、それらモデルをファインチューニングする必要がある。

NVIDIA AI Foundryは、よく使われている基盤モデル、ファインチューニング用のNVIDIA NeMo、および NVIDIA DGX Cloudの専用キャパシティを備えたプラットフォームおよびサービスである。これにより、開発者はNIMマイクロサービスとしてパッケージ化された、カスタマイズ可能な基盤モデルを作成するためのフルスタックソリューションを利用できる。

さらに、NVIDIA AI Foundryを使用している開発者は、セキュリティ、安定性、ならびに本番環境の展開でのサポートを実現する、NVIDIA AI Enterpriseソフトウェアプラットフォームを利用することができる。NVIDIA AI Foundryは、開発者にAIアプリケーションを構築し、独自のカスタム地域語 NIM マイクロサービスを迅速かつ簡単に展開するためのツールを提供。その結果、開発者は文化的および言語的に適切な成果をユーザーに届けることができるとしている。

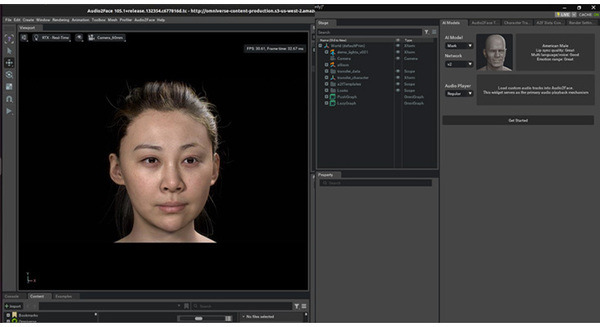

NVIDIAのデジタルヒューマン技術「ACE」がどんどんリアルに ブランドアンバサダーのAIアバター「James」を紹介 NVIDIA NIM

NVIDIAがOpenUSDの機能をロボットや工業デザイン向けに大幅拡張 生成AIモデルやNIMマイクロサービスを発表

アクセンチュアがNVIDIA AI Foundryを活用したカスタムLlama LLMを世界に先駆け開発 ビジネスに合わせた大規模言語モデル作成

NVIDIAのフルスタックAIプラットフォームがGPT-3 175Bベースのベンチマークで昨年比3倍以上向上

日本政府 AIインフラを1,146億円の助成で支援 NVIDIAが国内企業数社と協業、生成AIのインフラ構築「ソブリンAI」強化へ

NVIDIA 関連記事