大規模パラメータの大規模言語モデルは膨大な計算リソースとエネルギーを必要とするため、環境に対する負荷の増大が懸念されていることから、現在は軽量でありながら大規模モデルと同等の精度を実現するための小規模パラメータモデルの研究が活発化している。

このアプローチは、大規模言語モデルから重要な知識を抽出して、新たに有用なモデルを開発することから「知識蒸留」と表現されており、計算リソースの削減やエネルギー効率の向上に寄与する試みだ。

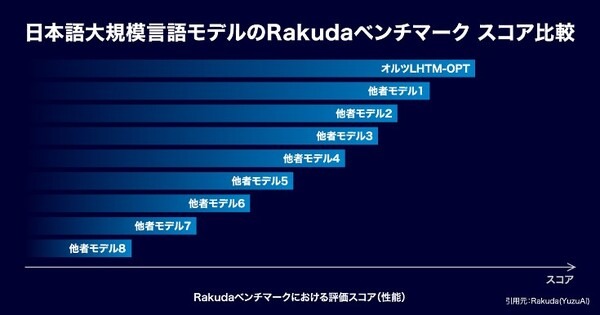

大規模言語モデル「LHTM-OPT(ラートム・オプト)」が最高性能を記録

P.A.I.(パーソナル人工知能)をはじめ、AIクローン技術でつくり出すパーソナルAIの開発および実用化を行う株式会社オルツは、このような社会課題を解決する生成AI開発に積極的かついち早く取り組みはじめ、小規模GPUマシンで実用的な、パラメータ数が最適化された新たな大規模言語モデル「LHTM-OPT(ラートム・オプト)」を開発し、日本語商用プライベートLLM(大規模言語モデル)として最高性能を記録したことを2023年10月19日に発表した。

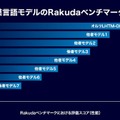

なお、同記録は「Rakuda」LLMベンチマークによる評価で、国内の大規模言語モデルの中での比較として国内トップ性能を達成している(2023年10月19日時点/同社調べ)。

小規模GPUマシンでも実行できる「LHTM-OPT」

同社が提供する大規模言語モデル「LHTM-2」は、パラメータ数が膨大で調整の自由度が非常に高く設定されている。それに対して「LHTM-OPT」は、そのパラメータを小規模GPUマシンでも実行可能であり、実用に最適化された軽量型モデルだ。

この開発にあたり、同社はオープンデータの学習だけでなく、独自の指示データや対話データのデータセットを作成し、精度を改善し、YuzuAIグループが出した日本語LLMを評価するRakudaベンチマークでは、「LHTM-OPT」の評価スコアが1152になり、2023年10月19日時点で日本国内で最高レベルに達した。

また、日本語言語理解ベンチマーク「JGLUE(Japanese General Language Understanding Evaluation)」8タスク平均においても、商用モデルとして国内最高スコア 56.12を記録(「LHTM-OPT」のJGLUE 主要4タスク平均のスコアは 75.08になっている)。

同社は、10Bパラメータ未満においてそれぞれのスコアを実現できたことは、グローバルレベルにおける当社の技術力の高さを示しているものと考え、今後も継続して様々なベンチマークで評価を行い、モデルをブラッシュアップすることで「LHTM-OPT」の性能と汎用性を向上させ続けるとともに、同モデルを基盤として自動質問応答、議事録自動要約、情報抽出、会話理解、予測分析のデータ整理・作成などの高度な処理が必要な問題に対応可能な多くのアプリケーションを実装していくと述べている。

軽量版大規模言語モデルが高精度を実現した意義

今回の「知識蒸留」を含めた学習と評価過程において、当社はデータ企画から作成、GPUリソースの評価・確保、学習プロセス最適化など一貫した企画・技術開発・運用を実践しており、その結果として軽量かつ高精度なモデルを実現することで、より実践的な生成AIプロダクトの基盤構築に対するオルツ技術の高い品質を証明している。

クライアントへの価値提供可能性

| カスタマイズ容易性 | 同社のクライアントは、今回開発した軽量かつ高精度なモデルを専門分野でファインチューニング可能。金融や製薬、製造、不動産など様々な分野固有の情報をベースにカスタマイズすることで、パラメータ数が圧倒的に多いLLMと同等の回答精度を保持しながら専門性を持たせることができるようになる。 |

|---|---|

| GPUコストの節約 | 同社のクライアントは、大規模言語モデルを基盤としたサービスを構築する際に課題となるランニングコストについても最適化される。軽量かつ高精度なモデルを運用することで、継続して活用する際のコスト対効果を最大化することが可能になる。 |

なお、LHTM-2/LHTM-OPT/GPT など大規模言語処理ソリューションに関する問い合わせ先は以下の通りだ。

「LHTM-2」ベースのBRAINの生成が可能に!オルツ、ノーコード生成AIプラットフォーム「altBRAIN」正式ローンチ

オルツが大規模言語モデルの開発受託を開始 1750億パラメータ規模から個別にカスタマイズ 価格は約20億円から

【動画】3人のデジタルクローンによる自由討論「未来はどうなるか」をオルツが実演公開 CEO米倉氏/成田悠輔氏/静電場朔氏

株式会社オルツ関連記事(ロボスタ)

株式会社オルツ