生成AIにパワーを与えている大規模言語モデル(LLM)には激しい技術革新が起きており、テキスト、画像、音声などの複数の種類のデータを処理するモデルがますます一般的になってきているが、これらのモデルの構築と展開は依然として容易ではない。

開発者が必要としているのは、モデルをすぐに体験、評価してユースケースに最適なモデルを判断し、費用対効果が高いだけでなく最高のパフォーマンスを発揮できるような形でモデルのパフォーマンスを最適化する方法である。

NVIDIAとGoogleは、開発者が世界クラスのパフォーマンスを備えたAI搭載アプリケーションを簡単に作成できるように、Google I/O 2024において新たに3つの協業を発表した。

Gemma + NIM

NVIDIAは、TensorRT-LLMの使用によってGoogleと連携し、イベントで発表された2つの新しいモデル、「Gemma 2」と「PaliGemma」の最適化が実現した。どちらのモデルも、Geminiモデルの作成に使用されたのと同じ研究技術に基づいて構築されており、それぞれが特定の分野に焦点を当てている。

Gemma2は、幅広いユース ケースに対応する次世代のGemmaモデルであり、画期的なパフォーマンスと効率性を実現するために設計された、まったく新しいアーキテクチャを特徴としている。

一方のPaliGemmaは、PaLI-3をヒントに開発されたオープンなビジョン言語モデル(VLM)。SigLIPビジョンモデルやGemma言語モデルといったオープンなコンポーネント上に構築されたPaliGemmaは、画像やショート動画への字幕付け、視覚的な質疑応答、画像内のテキストの理解、物体検出、オブジェクトセグメンテーションなどのビジョン言語タスク向けに設計されている。PaliGemmaは、さまざまなビジョン言語タスクでクラス最高のファインチューニング性能を実現するように設計されており、NVIDIA JAX-Toolboxによってサポートされている。

Gemma 2とPaliGemmaは、大規模なAIモデルの展開を簡素化する「NVIDIA AI Enterpriseソフトウェアプラットフォーム」の1つである「NVIDIA NIM推論マイクロサービス」とともに提供される。新しい2つのモデルに対するNIMサポートはAPIカタログから利用可能であり、まずPaliGemmaのサポートが始まっている。近日中にNVIDIA NGCおよびGitHubでコンテナとしてリリースされる。

Colab に高速化されたデータ分析を導入

Googleはまた、Google Colabが、オープンソースのGPUデータフレームライブラリである「RAPIDS cuDF」の標準サポートを開始することを発表した。

Google Colabはデータ サイエンティストに最も人気のある開発者プラットフォームの1つで、月間ユーザーは1,000万人にのぼる。Google Colabのユーザーは、「NVIDIA L4 TensorコアGPU」を使用して、コードを変更することなく、わずか数秒でpandasベースのPythonワークフローを最大50倍高速化できるようになる。

RAPIDS cuDFによって、Google Colabを使用する開発者は探索的解析や本番用データパイプラインを高速化することができる。pandasはその直観的なAPIによって世界で最も人気を集めるデータ処理ツールの1つだが、データサイズが増大するにつれて適用が困難になることも多くある。5~10GBのデータであっても、多数の単純操作が完了するまでにCPU上で数分かかることもあり、探索的解析や本番用データパイプラインの速度が低下する。

RAPIDS cuDFは、適用可能であればGPUでpandasのコードをシームレスに高速化し、適用できない場合はCPUのpandasにフォールバックすることで、この問題を解決するように設計されている。RAPIDS cuDFがColabで標準利用可能になることで、すべての開発者が場所を問わずに高速化されたデータ解析を活用できるようになる。

Firebase Genkitで協業

GoogleとNVIDIAは、NVIDIA RTXグラフィックスを使用したAI PCを活用することで、アプリ開発者がGemmaモデルの新シリーズなどの生成AIモデルをWebアプリケーションやモバイルアプリケーションに簡単に統合し、カスタムコンテンツの提供、セマンティック検索、質問応答を可能にするFirebase Genkitの協業も発表した。開発者はローカルのRTX GPUを使用して作業を開始し、その後に作業をGoogle Cloudインフラにシームレスに移行することができる。

また、開発者はGenkitでアプリを構築する際、モバイル開発者がアプリ構築に一般的に使用しているプログラミング言語であるJavaScriptを使用できるため、開発者の作業はさらに簡単になる。

NVIDIAとGoogle Cloud が複数の領域で協業

NVIDIAとGoogle Cloudは、AIを前進させるために複数の領域で協業している。

今後登場するGrace Blackwell搭載のDGX CloudプラットフォームやJAXフレームワークをサポートするほか、NVIDIA NeMoフレームワークの Google Kubernetes Engineへの導入が予定されており、こうした両社のフルスタックのパートナーシップによって、NVIDIAのテクノロジをGoogle Cloudで活用することでAIの可能性が広がっていくとしている。

日本政府 AIインフラを1,146億円の助成で支援 NVIDIAが国内企業数社と協業、生成AIのインフラ構築「ソブリンAI」強化へ

NVIDIA 創業者/CEOのジェンスン フアン氏のCOMPUTEXに先立つ基調講演を6月2日に配信 AI エコシステムの未来について語る

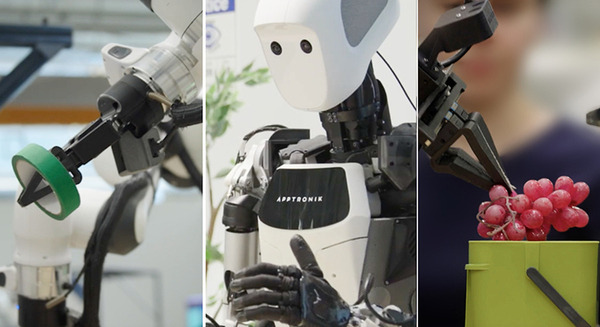

安川電機の新製品ロボット「MOTOMAN NEXT」に「NVIDIA Jetson Orin」と「Wind River Linux」採用 知性と自律性を実現

NVIDIA 大規模言語モデルと生成AIにも特化した「Blackwell プラットフォーム」とは 性能向上は最大30倍、コスト/エネルギー消費は最大1/25に

NVIDIAが量子コンピュータ開発を支援する「NVIDIA Quantum Cloud」開始 暗号化にGPUの並列処理を活用する「cuPQC」も

アクセンチュアとGoogle Cloudが連携を拡大 サイバーレジリエンス強化 Google Cloudのセキュリティ向けジェネレーティブAIを活用

NVIDIA 関連記事

Google I/O 2024