Amazon は大規模言語モデル「NVIDIA TensorRT-LLM」とGPUを使用した新しいAI機能を導入し、推論速度を2倍に向上させ、出品者の商品のキャッチコピーやタイトル、説明文の最適化と高速化を実践している、とNVIDIAは公表した。

オンラインショッピングの小売業、EC業界は競争が激しく、進化のペースが速い。

売り手は、魅力的で有益な商品リストを作成して消費者の目を引く必要があり、多くの注目を集めるとともに、信頼も得る必要がある。

NVIDIAは、Amazonが「NVIDIA Tensor コアGPU」を搭載した「Amazon Elastic Compute Cloud」(Amazon EC2) 上で最適化されたコンテナを使用し、スピードと信頼が求められる現代のEC業界で、バランスがよく魅力的なタイトルやキャッチコピー、説明文を作るために「生成AIツール」をパワーアップしていることをブログで紹介した。

EC業界を疾走するAmazonの生成ツール活用法

Amazonの新しい生成AI機能は、出品者が魅力的なタイトル、箇条書き、説明文、商品属性などのコンテンツをシームレスに作成するのに役立つという。

まず、Amazonではそれらコンテンツが改善できる可能性のある製品を特定し、生成AIを使って高品質なコンテンツを自動生成することができる。出品者は生成されたコンテンツを確認し、改善が必要であればフィードバックを提供するか、Amazonカタログへのコンテンツ変更を行う。

以前は、詳細な商品リストを人手のみで作成していたため、多大な時間と労力が必要だった。しかし、簡素化できるこのプロセスの導入により、出品者はタイトルや説明文などのコンテンツ制作以外の作業に集中する時間を増やすことができる、としている。

「NVIDIA TensorRT-LLM」とは

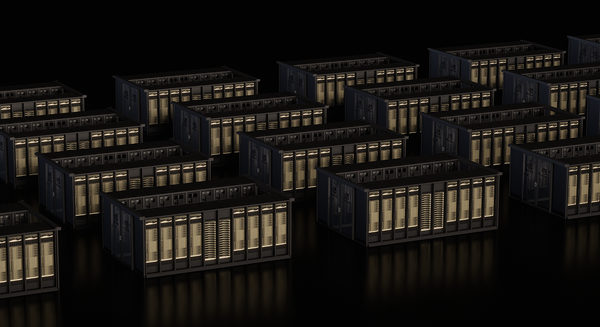

なお「NVIDIA TensorRT-LLM」ソフトウェアは、GitHubで公開されており、エンタープライズグレードのセキュリティ、サポート、およびプロダクションAI向けの信頼性を提供する「NVIDIA AI Enterprise」を通じてアクセスできる。

「TensorRT-LLM」オープンソース ソフトウェアは、AIの推論をより速く、よりスマートにする。「TensorRT-LLM」は、前述したAmazonの機能のケースのように、膨大な量のテキストで学習された大規模言語モデルで動作している。

「NVIDIA H100 TensorコアGPU」上で、「TensorRT-LLM」は、Llama 1 および 2、Falcon、Mistral、MPT、ChatGLM、Starcoder などの基盤LLM上で最大8 倍のスピードアップを可能にするという。

生成AIツールの推論効率を約2倍向上、推論のレイテンシーは約3倍削減

また、マルチGPUとマルチノードの推論、インフライト・バッチング、ページド・アテンション、FP8精度の「Hopper Transformer Engine」をサポート。これら全てでレイテンシを改善し、効率性を向上させ、出品者の業務効率を向上させているとしている。

Amazonは「TensorRT-LLM」と「NVIDIA GPU」を使用することで、TensorRT-LLMを実装使用する前と比較して、コストや必要なGPUの面で、生成AIツールの推論効率を約2倍向上させ、推論のレイテンシーは約3倍削減したという。

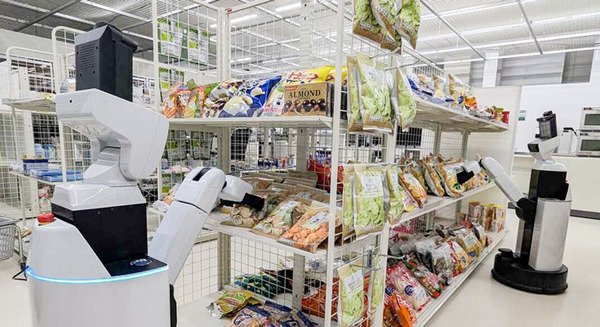

「cuRoboはCPUベースの50倍高速」NVIDIAロボット分野にも注力、高評価の理由 ロボット/デジタルツイン/シミュレータ/強化学習の最前線 単独インタビュー

トヨタ自動車 READY RoboticsとNVIDIAで協業 ロボットシミュレーション Omniverse , Isaac Sim を採用しREADY ForgeOSに統合

世界最大規模のAIとGPUイベント「NVIDIA GTC 2024」3月にリアルイベントで開催 基調講演はオンラインでも視聴可

NVIDIA関連記事

AmazonがAlexaのビジネス/地方自治体向けサービスを発表 高齢者施設やホテル、自治体等に「Alexa Smart Properties」提供開始

Amazonで自動車も売ります(初)! ヒョンデとアマゾンが広範囲な戦略的パートナーシップ連携 次世代モデルにAlexa搭載

Amazon関連記事